Modelos de linguagem com acesso a ferramentas, chamados de modelos de linguagem aumentada, têm potencialmente muitas mais capacidades do que os modelos de linguagem nativos. O método ReWOO pode torná-los muito mais eficientes.

Atualmente, o exemplo mais proeminente de um modelo de linguagem aumentada é o ChatGPT com navegadores da Internet ou plugins. Graças a essas ferramentas, o ChatGPT pode, por exemplo, obter informações atuais ou resolver tarefas computacionais de forma confiável.

O método ReWOO (Reasoning Without Observation) tem como objetivo contribuir para a eficiência desses modelos aumentados. No teste HotpotQA, um benchmark de raciocínio lógico em vários níveis, ele alcançou um aumento de quatro por cento na precisão com cinco vezes menos consumo de tokens.

O ReWOO alcança isso desacoplando o raciocínio do modelo de linguagem do acesso às ferramentas. Como resultado, os tokens do prompt precisam ser passados para a ferramenta apenas uma vez em vez de várias vezes.

Acesso às ferramentas otimizado para eficiência

Atualmente, os modelos de linguagem acessam as ferramentas chamando-as, passando a solicitação, aguardando a resposta, aceitando-a e depois continuando a gerar ao longo da resposta. O modelo executa, para, executa, para, e assim por diante. Isso leva tempo e poder de processamento, além de exigir o envio de tokens do prompt para a ferramenta várias vezes.

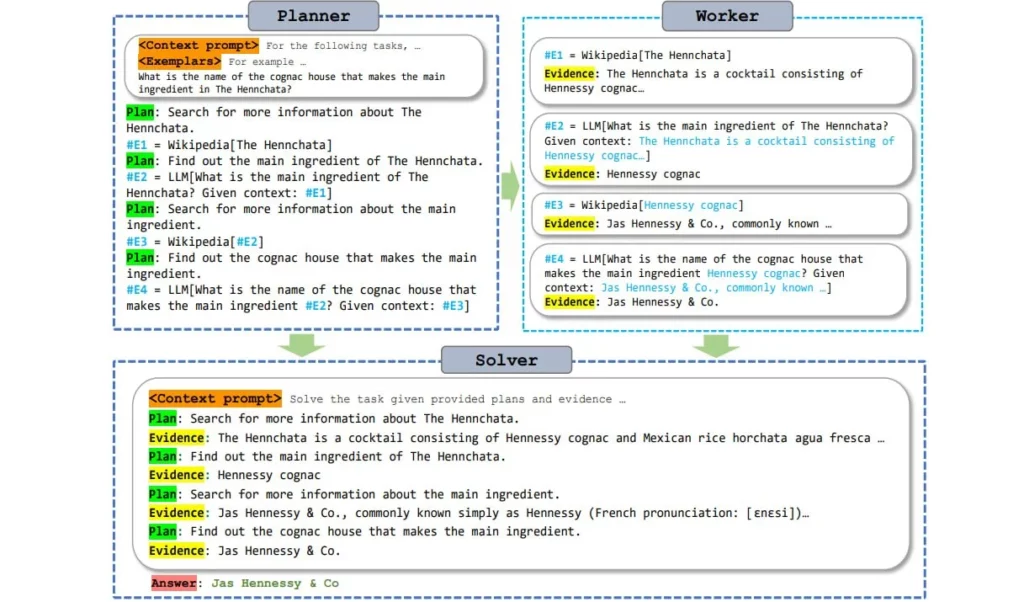

O ReWOO torna esse processo mais eficiente usando um módulo de planejamento que permite que o modelo de linguagem antecipe o raciocínio e defina onde as ferramentas são necessárias na resposta. O modelo, então, gera todas as subtarefas com todas as perguntas e o texto completo, mesmo que as informações das ferramentas ainda não estejam disponíveis.

De forma simplificada, isso pode ser comparado a um texto com lacunas que é preenchido com informações das ferramentas em uma única etapa. De acordo com os autores, os grandes modelos de linguagem pré-treinados têm conhecimento suficiente sobre a “forma” das respostas das ferramentas para permitir esse tipo de antecipação.

Como o modelo de linguagem armazena as consultas à ferramenta como subtarefas e as faz apenas uma vez e diretamente com todas as perguntas, o processo de geração não precisa ser interrompido e reiniciado várias vezes.

Esse processamento em “lote” das tarefas das ferramentas economiza poder de processamento, tornando os modelos de linguagem aumentada mais eficientes. Em particular, modelos pequenos podem produzir resultados de maior qualidade por meio desse uso eficiente e baseado em planejamento das ferramentas. A conclusão dos pesquisadores é: “Planejamento é tudo o que você precisa” – uma referência ao lendário artigo “Attention is all you need” sobre os Transformers.

Os pesquisadores fornecem um modelo de planejamento ReWOO baseado no Alpaca 7B e os conjuntos de dados usados para treinamento estão disponíveis no Github.