Modelos de lenguaje con acceso a herramientas, conocidos como modelos de lenguaje aumentados, tienen potencialmente muchas más capacidades que los modelos de lenguaje nativos. El método ReWOO puede hacerlos mucho más eficientes.

Actualmente, el ejemplo más destacado de un modelo de lenguaje aumentado es el ChatGPT con navegadores web o complementos. Gracias a estas herramientas, ChatGPT puede, por ejemplo, obtener información actualizada o resolver tareas computacionales de manera confiable.

El método ReWOO (Reasoning Without Observation) tiene como objetivo contribuir a la eficiencia de estos modelos aumentados. En la prueba HotpotQA, una evaluación de razonamiento lógico a varios niveles, logró un aumento del cuatro por ciento en la precisión con un consumo de tokens cinco veces menor.

ReWOO logra esto separando el razonamiento del modelo de lenguaje del acceso a las herramientas. Como resultado, los tokens de la indicación solo necesitan ser pasados a la herramienta una vez en lugar de varias veces.

Acceso optimizado a las herramientas para mayor eficiencia

Actualmente, los modelos de lenguaje acceden a las herramientas llamándolas, enviándoles la solicitud, esperando la respuesta, aceptándola y luego continuando la generación a lo largo de la respuesta. El modelo ejecuta, se detiene, ejecuta, se detiene, y así sucesivamente. Esto lleva tiempo y capacidad de procesamiento, además de requerir el envío de tokens del prompt a la herramienta varias veces.

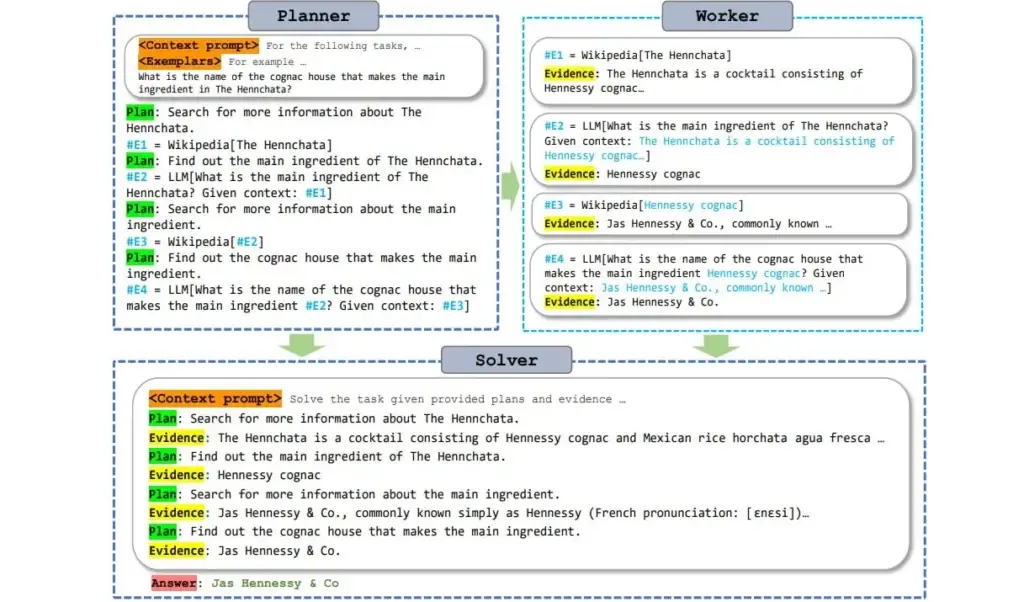

ReWOO hace este proceso más eficiente utilizando un módulo de planificación que permite que el modelo de lenguaje anticipe el razonamiento y determine dónde se necesitan las herramientas en la respuesta. El modelo luego genera todas las sub-tareas con todas las preguntas y el texto completo, incluso si la información de las herramientas aún no está disponible.

El marco de trabajo Rewoo. | Imagen: Binfeng Xu et al.

De forma simplificada, esto se puede comparar con un texto con espacios en blanco que se llena con información de las herramientas en un solo paso. Según los autores, los grandes modelos de lenguaje preentrenados tienen suficiente conocimiento sobre la «forma» de las respuestas de las herramientas para permitir este tipo de anticipación.

Como el modelo de lenguaje almacena las consultas a la herramienta como subtareas y las realiza solo una vez y directamente con todas las preguntas, el proceso de generación no necesita interrumpirse y reiniciarse varias veces.

Este procesamiento «por lotes» de las tareas de las herramientas ahorra potencia de procesamiento, lo que hace que los modelos de lenguaje aumentada sean más eficientes. En particular, los modelos pequeños pueden producir resultados de mayor calidad a través de este uso eficiente y basado en la planificación de las herramientas. La conclusión de los investigadores es: «La planificación es todo lo que necesitas», en referencia al legendario artículo «Attention is all you need» sobre los Transformers.

Los investigadores proporcionan un modelo de planificación ReWOO basado en Alpaca 7B, y los conjuntos de datos utilizados para el entrenamiento están disponibles en GitHub.