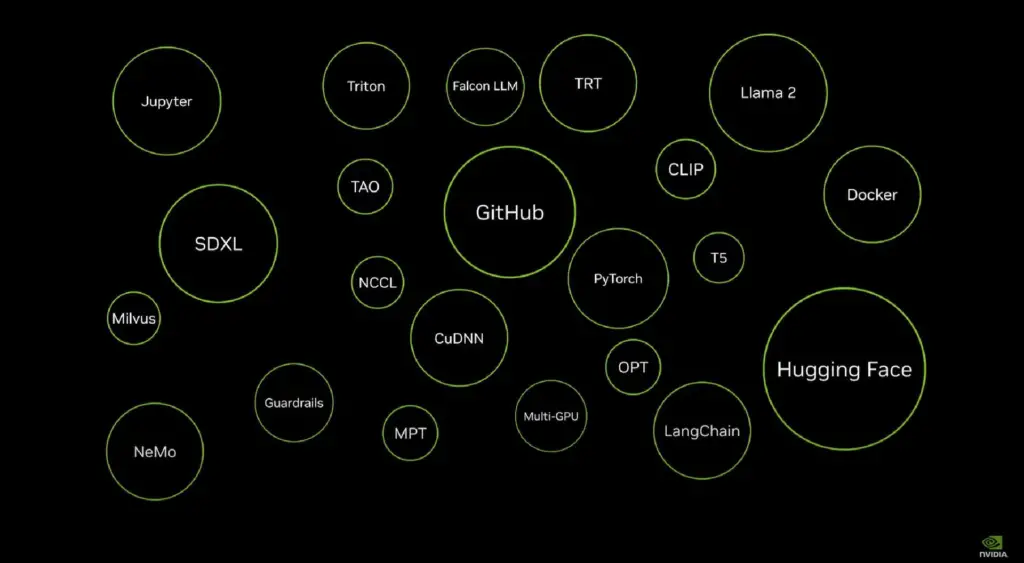

Conectándose a repositorios populares como HuggingFace, GitHub, el portal web empresarial de Nvidia llamado NVIDIA NGC y diversas fuentes de código de IA de código abierto o comercial, el Nvidia AI Workbench ofrece un espacio centralizado para los desarrolladores.

El Nvidia AI Workbench ha sido presentado, señalando un momento potencialmente transformador en la creación e implantación de la IA generativa. Al aprovechar Nvidia AI Workbench, los desarrolladores pueden esperar un proceso más ágil, que les permita trabajar en diferentes plataformas de IA de Nvidia, como PC y estaciones de trabajo.

Aunque puede que no inunde el mercado con contenido de IA, no hay duda de que Nvidia AI Workbench está posicionada para hacer del viaje hacia el desarrollo y la integración de la IA una experiencia más fácil de usar.

¿Qué ofrece Nvidia AI Workbench?

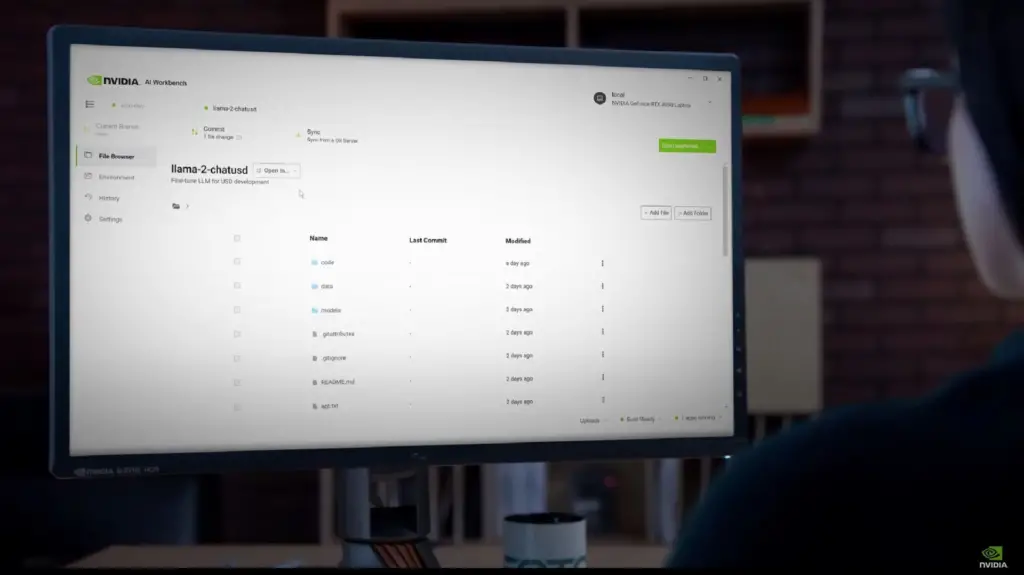

Nvidia anunció AI Workbench en la conferencia anual SIGGRAPH (Special Interest Group on Computer Graphics and Interactive Techniques) de Los Ángeles, presentando una plataforma fácil de usar diseñada para ejecutarse en la máquina local del desarrollador.

Nvidia AI Workbench, que se conecta a repositorios tan conocidos como HuggingFace, GitHub, el portal web empresarial de Nvidia denominado NVIDIA NGC y diversas fuentes de código de IA comercial o de código abierto, ofrece un espacio centralizado para los desarrolladores.

Pueden acceder a estos recursos sin necesidad de navegar por múltiples ventanas del navegador, simplificando el proceso de importación y personalización del código del modelo según sus preferencias y necesidades.

En un reciente anuncio, la compañía subrayó que Nvidia AI Workbench podría revolucionar la forma en que los desarrolladores interactúan con los cientos de miles de modelos de IA preentrenados que existen. Tradicionalmente, personalizar estos modelos ha sido una tarea complicada, pero Nvidia AI Workbench está diseñado para simplificar enormemente el proceso.

Con esta nueva herramienta, los desarrolladores pueden ajustar y ejecutar fácilmente la IA generativa, accediendo a todos los modelos esenciales de calidad empresarial. El soporte se extiende a varios frameworks, librerías y SDKs de la propia plataforma de IA de Nvidia, así como a destacados repositorios de código abierto como GitHub y Hugging Face.

Nvidia AI Workbench no se limita a la personalización, sino que también facilita el uso compartido en múltiples plataformas. Los desarrolladores que utilicen una tarjeta gráfica Nvidia RTX en sus PC o estaciones de trabajo podrán gestionar estos modelos generativos de forma local. Cuando es necesario, la escalabilidad a recursos de centros de datos y computación en la nube se convierte en una transición fluida.

«Nvidia AI Workbench ofrece un camino simplificado para que los equipos interorganizacionales creen las aplicaciones basadas en IA que se están volviendo cada vez más esenciales en los negocios modernos», dijo Manuvir Das, vicepresidente de informática empresarial de Nvidia.

También se ha lanzado Nvidia AI Enterprise 4.0

Junto con Nvidia AI Workbench, el gigante tecnológico ha lanzado la cuarta versión de su plataforma de software Nvidia AI Enterprise, diseñada específicamente para proporcionar herramientas esenciales para la adopción y personalización de la IA generativa en un entorno empresarial.

Nvidia AI Enterprise 4.0 tiene como objetivo facilitar la integración fluida y segura de modelos de IA generativa en diversas operaciones, con el respaldo de conexiones API estables.

La plataforma recién lanzada cuenta con una variedad de herramientas, incluyendo Nvidia NeMo para soporte nativo en la nube y soporte integral para aplicaciones de modelos de lenguaje a gran escala (LLM), y Nvidia Triton Management Service para automatizar y mejorar los despliegues de producción.

Además, se ha integrado Nvidia Base Command Manager Essentials, un software de gestión de clústeres, para ayudar a las empresas a optimizar el rendimiento en entornos de centros de datos, multicloud e híbridos.

El anuncio también destacó las colaboraciones con gigantes de la industria como ServiceNow, Snowflake y Dell Technologies, allanando el camino para una amplia gama de nuevos productos de IA, lo que demuestra aún más el compromiso de Nvidia de liderar la innovación en el dominio de la IA.

La entrada de Nvidia en el mercado de la IA parece estar bien sincronizada, ofreciendo no sólo Workbench, sino también otras herramientas como Nvidia ACE para aplicaciones de juegos. Con modelos de IA generativa como ChatGPT cada vez más populares, es probable que muchos desarrolladores se sientan atraídos por las soluciones completas y fáciles de usar de Nvidia.

Sin embargo, esta accesibilidad también conlleva cierto grado de incertidumbre, ya que el uso de la IA generativa a veces puede dar lugar a aplicaciones cuestionables. Las amplias implicaciones de las innovaciones de Nvidia en este espacio aún no se conocen del todo.