Todos os modelos de geração de imagens com IA atualmente usam modelos de difusão. OpenAI apresenta uma alternativa que é significativamente mais rápida e poderia alimentar novos modelos como DALL-E 3.

DALL-E 2, Stable Diffusion ou Midjourney usam modelos de difusão que sintetizam gradualmente uma imagem a partir do ruído durante a geração da imagem. O mesmo processo iterativo é usado em modelos de áudio ou vídeo.

Embora os modelos de difusão produzam ótimos resultados e possam ser controlados por meio de prompts de texto, eles são comparativamente lentos e exigem de 10 a 2.000 vezes mais poder de computação do que as GANs. Isso dificulta seu uso em aplicações em tempo real.

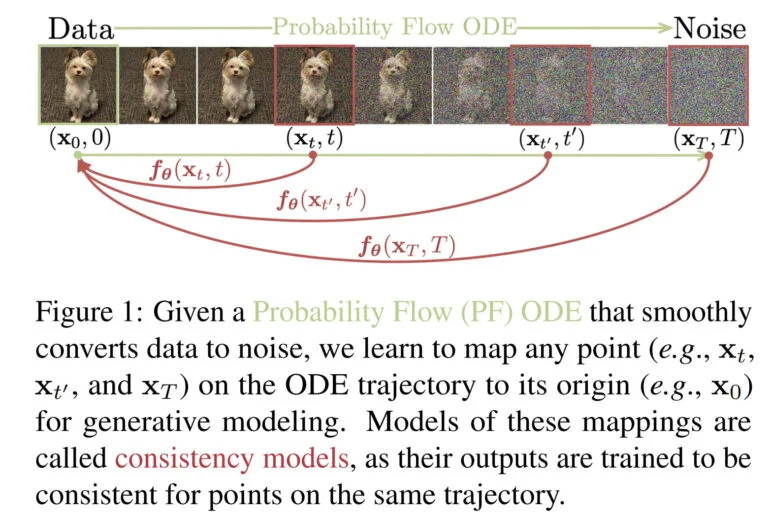

A OpenAI está, portanto, desenvolvendo uma nova variante de modelos de IA generativos chamados Modelos de Consistência.

Modelos de consistência são projetados para combinar as vantagens de modelos de difusão e GANs

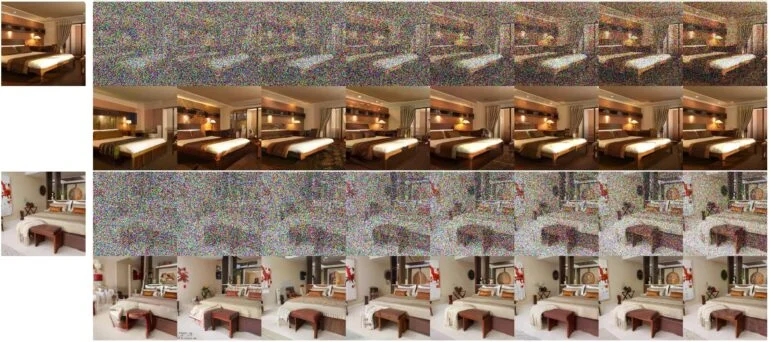

De acordo com a OpenAI, os modelos de consistência suportam a síntese rápida de imagens em uma etapa, mas também permitem a amostragem em algumas etapas, “para trocar a computação pela qualidade da amostra”.

Os modelos de consistência podem, portanto, produzir resultados úteis mesmo sem um processo iterativo e, em breve, poderão ser adequados para aplicações em tempo real.

Como os modelos de difusão, eles também suportam edição de dados de tiro zero, por exemplo, para tarefas de pintura, colorização ou super-resolução.

Os modelos de consistência podem ser destilados a partir de um modelo de difusão pré-treinado ou ser treinados isoladamente. De acordo com a OpenAI, os modelos de consistência são capazes de superar muitas GANs na geração de etapa única e todos os outros modelos geradores de etapa única não adversários.

A empresa realizou todos os testes em redes relativamente pequenas e conjuntos de dados de imagens, por exemplo, treinando uma rede neural para sintetizar imagens de gatos. Todos os modelos foram lançados pela empresa como código aberto para fins de pesquisa.

Uma nova arquitetura de IA generativa para DALL-E 3 e síntese de vídeo?

De acordo com os autores, também existem semelhanças impressionantes com outras técnicas de IA usadas em outros campos, como Q-learning profundo de aprendizado por reforço ou aprendizado contrastivo baseado em momento de aprendizado semi-supervisionado. “Isso oferece perspectivas empolgantes para a polinização cruzada de ideias e métodos entre esses diversos campos”, diz a equipe.

Nos meses que antecederam o lançamento do DALL-E 2, a OpenAI publicou vários artigos sobre modelos de difusão e finalmente apresentou o GLIDE, um modelo muito impressionante na época.

Portanto, a pesquisa sobre modelos de consistência pode ser uma indicação de que a OpenAI está procurando arquiteturas de IA geradoras novas e mais eficazes que possam, por exemplo, permitir um DALL-E 3 muito mais rápido e ser usado para geração de vídeo em tempo real.

O trabalho atual da OpenAI deve, portanto, ser visto como um estudo de viabilidade, com um modelo de IA maior sendo o próximo passo provável. A mesma arquitetura poderia eventualmente ser usada para outras modalidades ou para a síntese de conteúdo 3D.