Tous les modèles d’imagerie de l’IA utilisent actuellement des modèles de diffusion. OpenAI présente une alternative qui est significativement plus rapide et qui pourrait alimenter de nouveaux modèles tels que DALL-E 3.

DALL-E 2, Stable Diffusion ou Midjourney utilisent des modèles de diffusion qui synthétisent progressivement une image à partir du bruit lors de la génération de l’image. Le même processus itératif est utilisé dans les modèles audio ou vidéo.

Bien que les modèles de diffusion produisent d’excellents résultats et puissent être contrôlés par des invites textuelles, ils sont relativement lents et nécessitent une puissance de calcul de 10 à 2 000 fois supérieure à celle des GAN. Il est donc difficile de les utiliser dans des applications en temps réel.

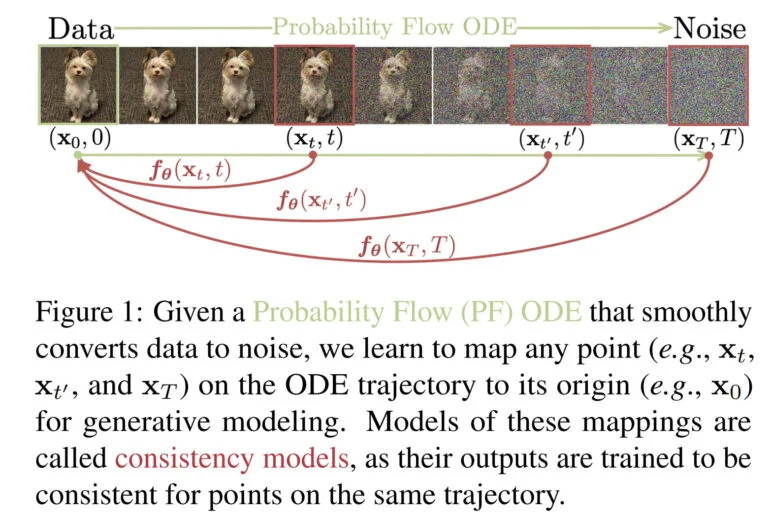

C’est pourquoi l’OpenAI développe une nouvelle variante des modèles d’IA générative, les modèles de cohérence.

Les modèles de cohérence sont conçus pour combiner les avantages des modèles de diffusion et des GANs

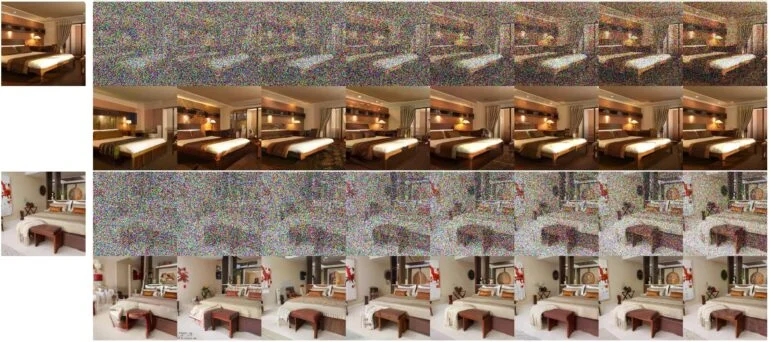

Selon OpenAI, les modèles de cohérence permettent la synthèse rapide d’images en une seule étape, mais aussi l’échantillonnage en quelques étapes, « pour compenser le calcul par la qualité de l’échantillon ».

Les modèles de cohérence peuvent donc produire des résultats utiles même sans processus itératif et pourraient bientôt convenir à des applications en temps réel.

À l’instar des modèles de diffusion, ils prennent également en charge l’édition de données sans prise de vue, par exemple pour les tâches de peinture, de colorisation ou de super-résolution.

Les modèles de cohérence peuvent être distillés à partir d’un modèle de diffusion pré-entraîné ou être entraînés seuls. Selon OpenAI, les modèles de cohérence sont capables de surpasser de nombreux GAN dans la génération en une seule étape et tous les autres modèles de génération en une seule étape non contradictoires.

L’entreprise a effectué tous les tests sur des réseaux et des ensembles de données d’images relativement petits, par exemple en entraînant un réseau neuronal à synthétiser des images de chats. Tous les modèles ont été publiés par l’entreprise en tant que source ouverte à des fins de recherche.

Une nouvelle architecture d’IA générative pour DALL-E 3 et la synthèse vidéo ?

Selon les auteurs, il existe également des similitudes frappantes avec d’autres techniques d’IA utilisées dans d’autres domaines, telles que l’apprentissage Q profond de l’apprentissage par renforcement ou l’apprentissage contrastif basé sur les moments de l’apprentissage semi-supervisé. « Cela offre des perspectives intéressantes pour la pollinisation croisée d’idées et de méthodes entre ces divers domaines », déclare l’équipe.

Dans les mois qui ont précédé le lancement de DALL-E 2, OpenAI a publié plusieurs articles sur les modèles de diffusion et a finalement présenté GLIDE, un modèle très impressionnant à l’époque.

La recherche de modèles de cohérence pourrait donc indiquer qu’OpenAI est à la recherche de nouvelles architectures de génération d’IA plus efficaces qui pourraient, par exemple, permettre d’utiliser un DALL-E 3 beaucoup plus rapide pour la génération de vidéos en temps réel.

Les travaux actuels de l’OpenAI doivent donc être considérés comme une étude de faisabilité, la prochaine étape probable étant un modèle d’IA plus grand. La même architecture pourrait éventuellement être utilisée pour d’autres modalités ou pour la synthèse de contenu en 3D.