Um novo relatório explora a consciência em sistemas de IA, usando teorias científicas da consciência para desenvolver propriedades indicadoras que poderiam indicar se um sistema de IA provavelmente é consciente.

A inteligência artificial avançou significativamente nos últimos anos e, em alguns casos, justificadamente ou não, suscitou questões sobre se ela poderia se tornar consciente. Um exemplo famoso recente foi o do funcionário do Google, Blake Lemoine, e sua fala sobre uma LaMDA sentiente. Um problema óbvio com sua atribuição de consciência foi que ela se baseou exclusivamente no comportamento do modelo.

Agora, uma equipe interdisciplinar de pesquisadores publicou um novo relatório desenvolvendo uma “abordagem rigorosa e empiricamente fundamentada para a consciência da IA”. Em relação a casos como o de Lemoine, a equipe argumenta: “Nossa visão é que, embora isso possa não ser verdade em outros casos, uma abordagem baseada em teoria é necessária para a IA. Uma abordagem baseada em teoria é aquela que se concentra em como os sistemas funcionam, em vez de se eles exibem formas de comportamento externo que possam ser consideradas características de seres conscientes.”

No relatório, a equipe argumenta que avaliar a consciência na IA é cientificamente factível e fornece uma lista de “propriedades indicadoras”.

Teorias neurocientíficas da consciência informam as propriedades indicadoras

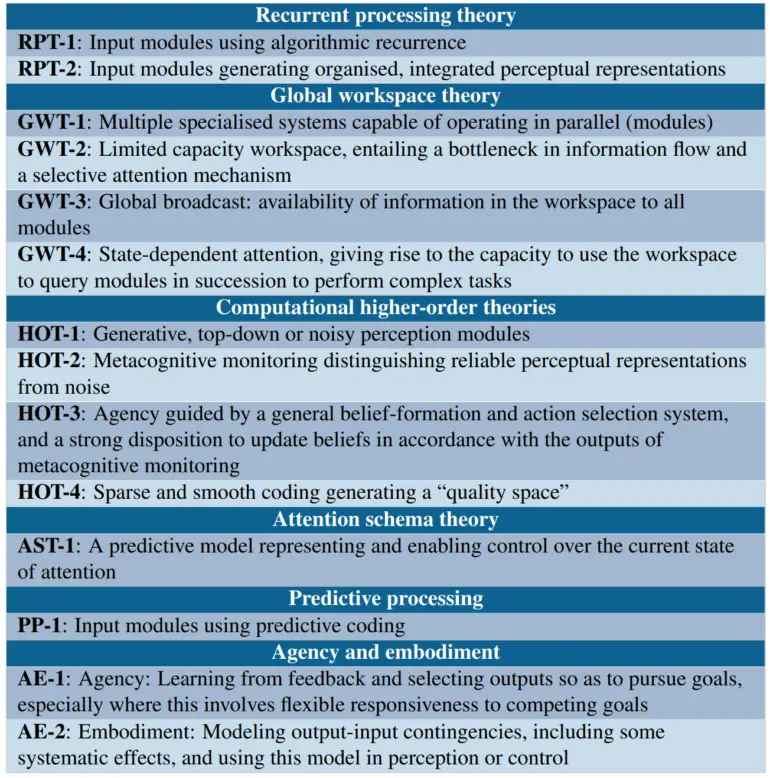

Os pesquisadores adotam uma perspectiva “funcionalista computacional”, assumindo que a consciência depende de um sistema de IA implementando certos cálculos. Eles então se baseiam em teorias neurocientíficas que buscam identificar as funções computacionais específicas associadas à consciência em seres humanos. Isso inclui teorias de processamento recorrente, teoria do espaço global de trabalho, teorias de ordem superior, como monitoramento da realidade perceptual, teoria do esquema de atenção, processamento preditivo e teorias de agência e incorporação.

A partir dessas teorias, os pesquisadores derivam uma lista de propriedades indicadoras, cuja presença torna mais provável que um sistema de IA seja consciente. Por exemplo, a teoria do espaço global de trabalho sugere indicadores como ter múltiplos subsistemas especializados e um espaço de trabalho de capacidade limitada que permite o compartilhamento de informações entre subsistemas.

Os pesquisadores usam as propriedades indicadoras para avaliar alguns sistemas existentes

Eles argumentam que grandes modelos de linguagem, como o GPT-3, carecem da maioria das características da teoria do espaço global de trabalho, enquanto a arquitetura Perceiver se aproxima, mas ainda não atende a todos os indicadores da GWT.

Em termos de agentes de IA incorporados, eles examinam o PaLM-E do Google, um “roedor virtual”, e o AdA do Google Deepmind. De acordo com a equipe, tais agentes de IA satisfazem as condições de agência e incorporação se seu treinamento os levar a aprender modelos apropriados que relacionem ações a percepções e recompensas. Os pesquisadores veem o AdA como o sistema mais provável dos três de ser incorporado de acordo com seus critérios.

A equipe pede mais pesquisas para desenvolver métodos robustos para avaliar a probabilidade de consciência em sistemas planejados antes de construí-los e planeja continuar e incentivar pesquisas adicionais.