Un nouveau rapport explore la conscience dans les systèmes d’IA, en utilisant des théories scientifiques de la conscience pour développer des propriétés indicatrices qui pourraient indiquer si un système d’IA est probablement conscient.

L’intelligence artificielle a considérablement progressé au cours des dernières années et, dans certains cas, qu’ils soient justifiés ou non, elle a soulevé des questions sur sa capacité à devenir consciente. Un exemple récent et célèbre en est la déclaration de Blake Lemoine, employé de Google, au sujet d’une LaMDA consciente. Un problème évident avec son attribution de conscience était qu’elle se basait exclusivement sur le comportement du modèle.

Maintenant, une équipe interdisciplinaire de chercheurs a publié un nouveau rapport développant une « approche rigoureuse et empiriquement fondée de la conscience de l’IA ». Par rapport à des cas comme celui de Lemoine, l’équipe soutient : « Notre point de vue est que, bien que cela puisse ne pas être vrai dans d’autres cas, une approche basée sur la théorie est nécessaire pour l’IA. Une approche basée sur la théorie se concentre sur le fonctionnement des systèmes, plutôt que sur la question de savoir s’ils présentent des comportements externes qui pourraient être considérés comme des caractéristiques de l’être conscient. »

Dans le rapport, l’équipe soutient que l’évaluation de la conscience dans l’IA est scientifiquement faisable et fournit une liste de « propriétés indicatrices ».

Les théories neuroscientifiques de la conscience informent les propriétés indicatrices

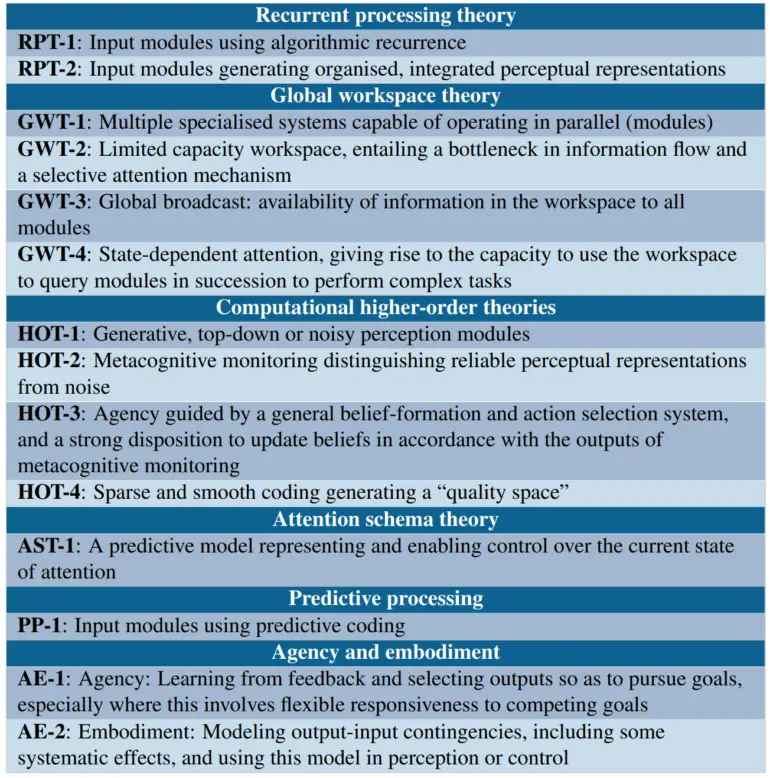

Les chercheurs adoptent une perspective « fonctionnaliste computationnelle », supposant que la conscience dépend d’un système d’IA mettant en œuvre certains calculs. Ils s’appuient ensuite sur des théories neuroscientifiques qui cherchent à identifier les fonctions computationnelles spécifiques associées à la conscience chez les êtres humains. Cela inclut des théories de traitement récurrent, de théorie de l’espace global de travail, de théories de haut niveau telles que la surveillance de la réalité perceptive, la théorie du schéma d’attention, le traitement prédictif et les théories d’agence et d’incorporation.

À partir de ces théories, les chercheurs dérivent une liste de propriétés indicatrices, dont la présence rend plus probable qu’un système d’IA soit conscient. Par exemple, la théorie de l’espace global de travail suggère des indicateurs tels que la présence de plusieurs sous-systèmes spécialisés et un espace de travail de capacité limitée permettant le partage d’informations entre les sous-systèmes.

Les chercheurs utilisent les propriétés indicatrices pour évaluer certains systèmes existants

Les chercheurs utilisent les propriétés indicatrices pour évaluer certains systèmes existants

Ils soutiennent que les grands modèles de langage tels que GPT-3 manquent de la plupart des caractéristiques de la théorie de l’espace global de travail, tandis que l’architecture Perceiver s’en rapproche, mais ne satisfait toujours pas à tous les indicateurs du GWT.

En ce qui concerne les agents d’IA incorporés, ils examinent le PaLM-E de Google, un « rat virtuel », et l’AdA de Google Deepmind. Selon l’équipe, de tels agents d’IA satisfont aux conditions d’agence et d’incorporation si leur formation les amène à apprendre des modèles appropriés qui relient les actions aux perceptions et aux récompenses. Les chercheurs considèrent que l’AdA est le système le plus susceptible des trois d’être incorporé selon leurs critères.

L’équipe appelle à davantage de recherches pour développer des méthodes robustes permettant d’évaluer la probabilité de conscience dans les systèmes planifiés avant de les construire, et prévoit de poursuivre et d’encourager les recherches supplémentaires.