A Wayve, startup britânica especializada em direção autônoma baseada em IA, apresenta seu novo modelo: o Lingo-1, que combina visão mecânica com lógica baseada em texto.

Os seres humanos têm que tomar decisões na estrada o tempo todo: quando pisamos no gás, quando tiramos o pé do acelerador, quando passamos ou quando nos seguramos?

Os carros autônomos têm que tomar as mesmas decisões. Mas, ao contrário dos humanos, eles não podem justificar suas decisões – ainda não. O Lingo-1 pretende mudar isso.

Lingo-1 combina modelos de linguagem com modelos visuais

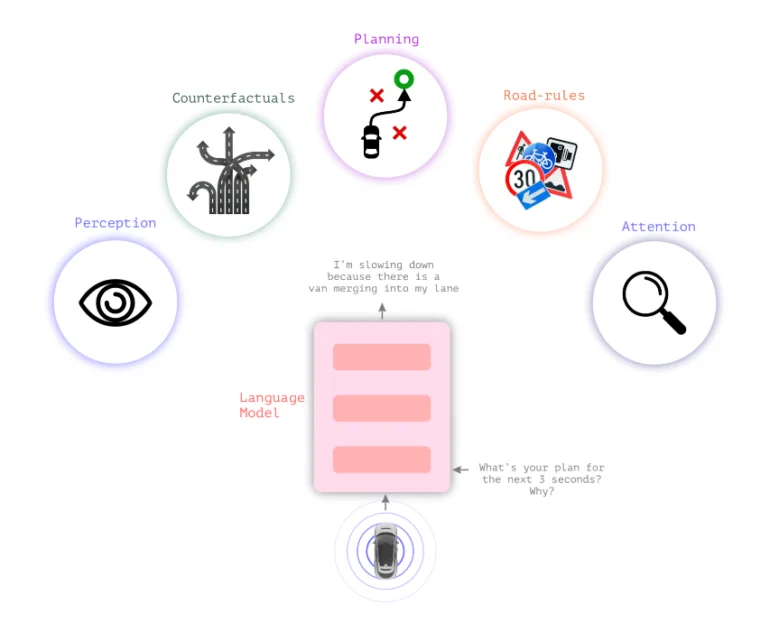

Os sistemas de condução autónoma típicos dependem da percepção visual para tomar decisões. O novo modelo de linguagem visual Lingo-1 da Wayve insere lógica textual entre percepção visual e ação, permitindo que o carro explique suas ações.

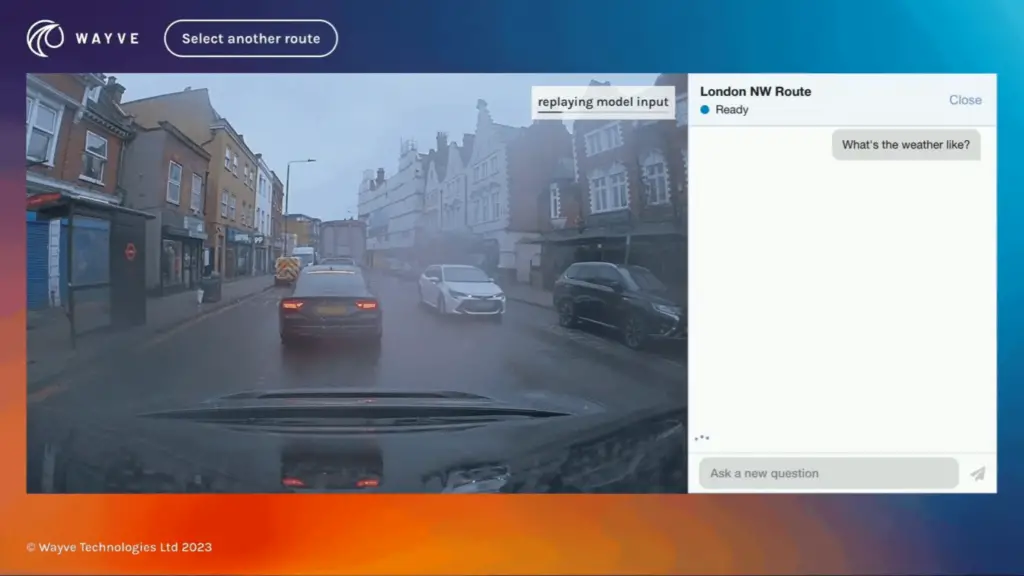

Para uma decisão de condução e para a situação geral do trânsito, o carro fornece continuamente declarações textuais descrevendo a situação atual e justificando decisões, semelhante a um motorista pensando em voz alta ou um instrutor de direção querendo apoiar a atenção do aluno.

Essa lógica textual poderia aumentar a sensação de segurança nos carros, fazendo com que suas decisões parecessem menos uma “caixa preta”. Também poderia contribuir para a segurança dos veículos autônomos, permitindo que o sistema raciocinasse textualmente por meio de cenários de tráfego que não estão incluídos nos dados de treinamento.

Além disso, o comportamento do Lingo-1 pode ser ajustado de forma flexível por meio de prompts de texto simples, e pode ser treinado com exemplos adicionais escritos por humanos sem a necessidade de extensa e dispendiosa coleta de dados visuais.

“O raciocínio causal é vital na direção autônoma, permitindo que o sistema compreenda as relações entre elementos e ações dentro de uma cena”, escreve Wayve.

Em vez de coletar milhares de exemplos visuais de um carro freando para um pedestre, alguns exemplos da cena com breves descrições de texto de como o carro deve se comportar na situação e quais fatores considerar seriam suficientes, escreve Wayve.

Carros autônomos podem se beneficiar de conhecimentos gerais em modelos de linguagem de grande porte

O conhecimento geral de grandes modelos linguísticos também poderia melhorar os modelos de condução, especialmente em situações anteriormente desconhecidas.

“Os LLMs já possuem vasto conhecimento do comportamento humano a partir de conjuntos de dados em escala de internet, tornando-os capazes de entender conceitos como identificação de objetos, regulamentos de trânsito e manobras de direção. Por exemplo, os modelos de linguagem sabem a diferença entre uma árvore, uma loja, uma casa, um cachorro perseguindo uma bola e um ônibus que está parado em frente a uma escola”, escreve Wayve.

Vídeo: Wayve

O Lingo-1 foi treinado usando dados de imagem, voz e ação coletados de motoristas da Wayve enquanto eles dirigiam por Londres. De acordo com a Wayve, o Lingo-1 atualmente atinge 60% da precisão dos motoristas humanos. O sistema mais do que dobrou seu desempenho desde os testes iniciais em agosto e setembro por meio de melhorias em sua arquitetura e conjunto de dados de treinamento.

O Lingo-1 é limitado na medida em que só foi treinado em dados de Londres e do Reino Unido. Ele também pode gerar respostas incorretas, um problema comum com LLMs, mas o Lingo-1 tem a vantagem de ser baseado em dados visuais do mundo real, escreve a empresa.

Os desafios técnicos incluem os longos comprimentos de contexto muito necessários para descrições de vídeo em modelos multimodais e a integração do Lingo-1 na arquitetura de circuito fechado diretamente no veículo autônomo.

Em junho, a Wayve apresentou o GAIA-1, um modelo de IA generativa que pode ajudar a aliviar o gargalo causado pelo fornecimento limitado de dados de vídeo para treinar modelos de IA em diferentes situações de tráfego. O GAIA-1 aprende conceitos de direção prevendo os próximos quadros em uma sequência de vídeo, tornando-se uma ferramenta valiosa para treinar sistemas autônomos para navegar em cenários complexos do mundo real.