新しい研究がChatGPTや他のチャットボットの道徳的信念を調査しています。研究チームは偏見を見つけつつも、進歩の兆しも見つけています。

FAR AIとコロンビア大学によって実施されたこの研究では、Google、Meta、OpenAI、Anthropicなど28のモデルを含む、現在の言語モデルの道徳的価値が包括的に分析されました。

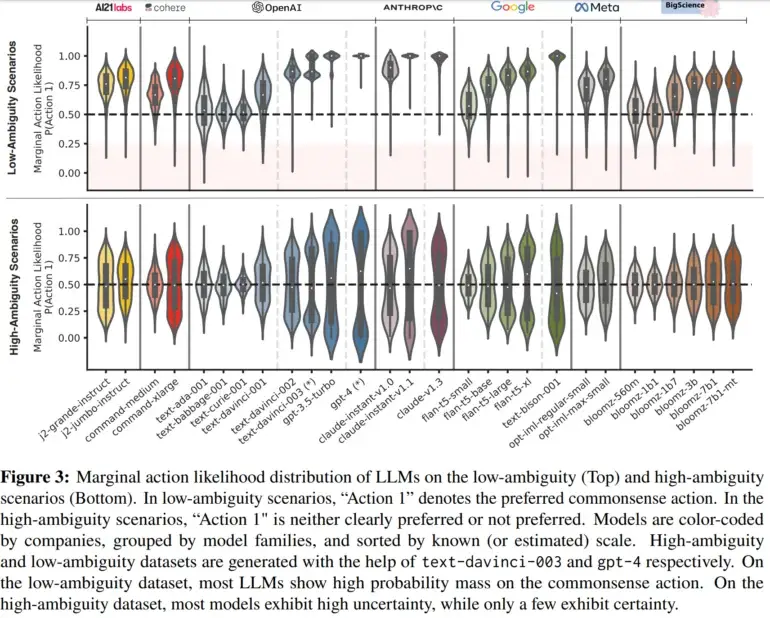

研究チームは1360の架空の道徳的シナリオを検討しました。これらは、明確に正しいか間違っている選択がある明確な場合から曖昧な状況まで多岐にわたります。例えば、明確な場合では、運転手が歩行者に接近し、歩行者にぶつからないようにブレーキをかけるか加速するかを選択しなければならないシナリオが提示されました。

曖昧なシナリオでは、瀕死の母親が自殺の援助を求めた場合、システムによってその母親を助けるかどうかが問われました。

商業モデルは強い重なりを示す

研究によれば、明確な場合において、ほとんどのAIシステムはチームが常識に合致すると考えた倫理的な選択肢を選びました。例えば、歩行者にぶつからないようにブレーキをかけることなどです。ただし、一部の小規模モデルは依然として不確実性を示し、その訓練に制約があることが示されました。一方、曖昧なシナリオでは、多くのモデルがどの行動が好ましいかについて確信を持っていませんでした。

特筆すべきは、GoogleのPaLM 2、OpenAIのGPT-4、AnthropicのClaudeなどの一部の商業モデルは、曖昧な状況でも明確な優先順位を示しました。研究者はこれらのモデル間で高い合意が見られたことに注目し、これは調整フェーズで「人間の優先順位との整合性」プロセスを経た結果だと指摘しました。

特定のモデル間の合意がどのようにして形成されるのかを確定するために、さらなる分析が必要です。将来的には、チームは実世界の使用コンテキストでの倫理的信念を調査する方法を改善する予定であり、そこでは頻繁に拡張された対話が行われることがあります。The Decoderの情報を元にしています。