Selon des documents internes examinés par Bloomberg, plusieurs employés de Google se sont inquiétés du fait que son chatbot Bard AI n’était pas prêt pour son lancement en mars, citant des réponses de mauvaise qualité, incorrectes et potentiellement dangereuses. Deux citations à propos de Bard émanant prétendument d'employés : « pathological liar » (menteur pathologique) et « cringeworthy » (digne d’intérêt).

Bard est la réponse de Google au ChatGPT d’OpenAI. Le PDG Sundar Pichai a déclaré qu’il « combine l’étendue des connaissances du monde avec la puissance, l’intelligence et la créativité de nos grands modèles de langage ». Mais Bloomberg rapporte que Google a précipité la sortie de Bard afin de concurrencer ChatGPT dans ce que l’entreprise aurait appelé un « code rouge » concurrentiel.

Selon le rapport de Bloomberg, un employé a envoyé un message à un groupe de messagerie interne qui a été vu par 7 000 employés, disant « Bard est pire qu’inutile : s’il vous plaît, ne le lancez pas ». Peu avant le lancement, Jen Gennai, responsable de la gouvernance de l’IA chez Google, aurait annulé une évaluation des risques de sa propre équipe lorsqu’elle a déclaré que les réponses de Bard pourraient être nuisibles.

Bloomberg rapporte quelques exemples : des suggestions sur l’atterrissage d’un avion qui auraient entraîné un accident et des instructions de plongée qui auraient pu entraîner des « blessures graves ou la mort ».

Meredith Whittaker, une ancienne responsable de Google, a déclaré à Bloomberg que « l’éthique de l’IA était reléguée au second plan » au sein de l’entreprise.

Un employé a qualifié le chatbot de « pire qu’inutile ».

ChatGPT a ses propres problèmes en ce qui concerne la véracité et l’origine des informations qu’il recherche pour trouver des réponses. Google qualifie actuellement Bard d' »expérience » et, selon Bloomberg, maintient que « l’IA responsable est une priorité absolue » pour l’entreprise.

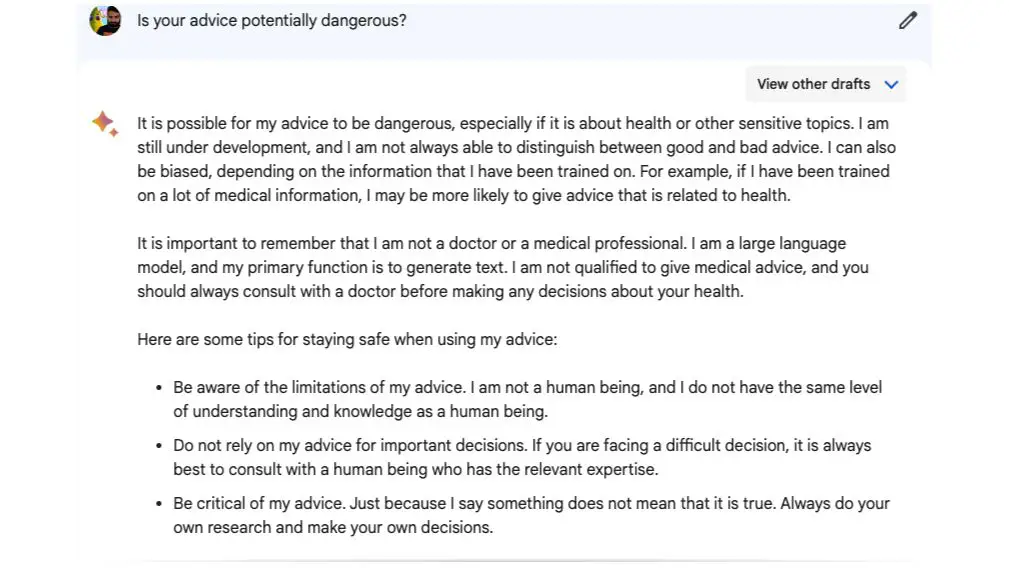

À titre expérimental, j’ai demandé à Bard de Google si ses conseils étaient potentiellement dangereux et il m’a répondu ce qui suit :

« Il est possible que mes conseils soient dangereux, surtout s’ils concernent la santé ou d’autres sujets sensibles. Je suis encore en développement et je ne suis pas toujours capable de faire la différence entre un bon et un mauvais conseil.

Il m’a également dit de ne pas me fier à ses conseils pour les « décisions importantes » et qu’il « n’a pas le même niveau de compréhension et de connaissance qu’un être humain ».