Le dernier modèle d’image de Meta, CM3leon, est capable de comprendre et de générer à la fois du texte et des images. Il peut créer des images à partir de descriptions textuelles et composer du texte à partir d’images, ce qui le rend utile pour de multiples tâches.

CM3leon (prononcé « caméléon ») est un modèle de base unique capable de générer à la fois du texte vers l’image et de l’image vers le texte. Il s’agit du premier modèle multimodal formé à l’aide d’une approche adaptée des modèles de langage textuels, qui peuvent recevoir et générer à la fois du texte et des images.

L’architecture de CM3leon utilise un réseau de transformation basé sur un tokeniseur pour le décodage uniquement, comme pour les modèles basés sur le texte. Il s’appuie sur des travaux antérieurs (RA-CM3) en utilisant une base de données externe pendant l’apprentissage, avec ce que l’on appelle l' »augmentation de la recherche ». Alors que d’autres modèles ne peuvent apprendre qu’à partir des données brutes qui leur sont fournies, les modèles à augmentation de recherche recherchent activement les données les plus pertinentes et les plus diverses pour le processus d’apprentissage pendant la formation, ce qui rend la phase de formation plus robuste et plus efficace.

Meta affirme que ce modèle nécessite cinq fois moins de puissance de calcul que les méthodes précédentes basées sur la transformation et moins de données d’apprentissage, ce qui le rend aussi efficace à former que les modèles existants basés sur la diffusion.

Un caméléon multitâche

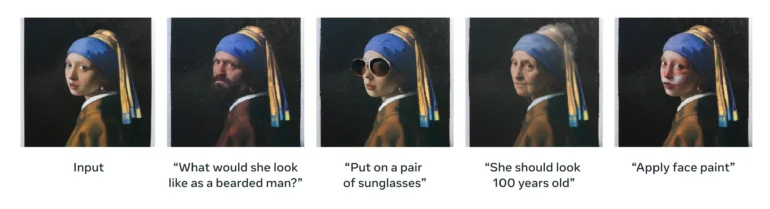

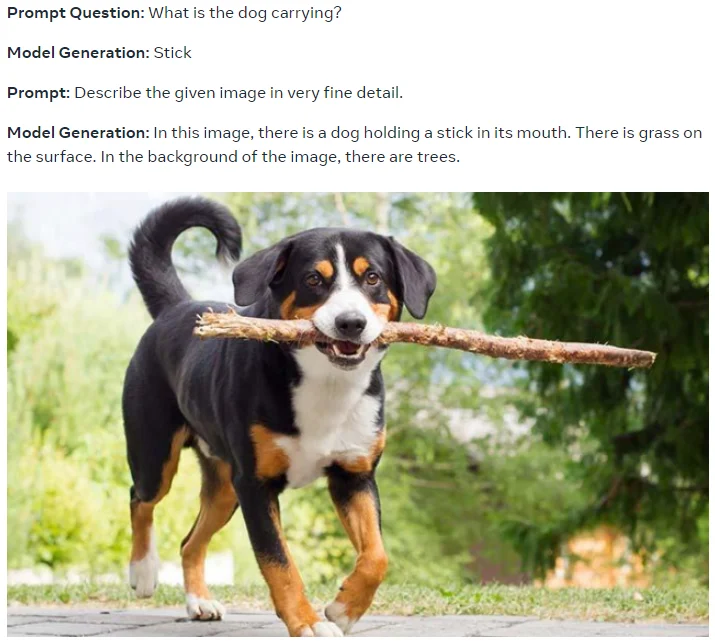

Grâce à l’ajustement des instructions multitâches à grande échelle, CM3leon est capable d’effectuer une variété de tâches, y compris la génération et l’édition d’images à partir de texte, la génération de texte à partir d’images, l’édition d’images à partir de texte, la génération de légendes, la réponse à des questions visuelles et l’édition d’images à partir de la structure.

l’expression « instruction adaptée » signifie que le modèle est formé pour suivre des instructions fournies sous forme de texte. Par exemple, vous pouvez fournir une instruction telle que « décrivez une image d’un coucher de soleil sur l’océan » et le modèle d’IA générera une description basée sur cette instruction. Le modèle a été entraîné sur plusieurs exemples des tâches mentionnées ci-dessus.

(2) Une photo en gros plan de la main humaine, modèle de main. Haute qualité.

(3) Un raton laveur, personnage principal d’un anime, se préparant à une bataille épique avec un sabre de samouraï. Posture de combat. Fantaisie, illustration.

(4) Un panneau d’arrêt de style fantastique avec le texte « 1991 »

Meta affirme également que la mise à l’échelle des recettes développées pour les modèles de texte uniquement se généralise directement aux modèles de génération d’images basés sur la tokenisation, ce qui implique des résultats encore meilleurs avec des modèles plus grands, entraînés plus longtemps et sur davantage de données. L’entraînement de CM3leon a comporté une phase de pré-entraînement à grande échelle avec récupération par stimulation sur une énorme quantité de données, puis une phase de réglage fin supervisé (SFT) avec des instructions pour obtenir ses capacités multitâches.

Sur le benchmark d’imagerie (MS-COCO sans entraînement préalable), CM3leon atteint un score de Fréchet Inception Distance (FID) de 4,88, ce qui constitue un nouveau résultat de pointe et surpasse le modèle d’imagerie Parti de Google.

Plus de cohérence, plus de licences, plus de métavers

Selon Meta, CM3leon excelle dans la production d’images cohérentes qui suivent mieux les instructions d’entrée, même complexes. Il peut mieux récupérer les formes globales et les détails locaux, générer du texte ou des nombres tels qu’ils apparaissent dans le stimulus, et résoudre des tâches telles que l’édition d’images à partir de texte qui nécessitaient auparavant des modèles spécialisés tels que Instruct Pix2Pix.

Il peut également rédiger des légendes détaillées pour les images, à l’inverse des instructions, pour ainsi dire, qui peuvent être utilisées ultérieurement pour la création ou l’édition d’images, ou pour la création d’ensembles de données d’entraînement synthétiques. Meta affirme que CM3leon égale ou surpasse Flamingo et OpenFlamingo sur les tâches textuelles, même s’il a été entraîné avec moins de texte (3 milliards de jetons de texte).

Meta précise que le modèle a été entraîné sur un « nouveau grand ensemble de données de Shutterstock qui ne comprend que des images et des textes sous licence », mais qu’il reste très compétitif par rapport à d’autres modèles.

« Par conséquent, nous pouvons éviter les problèmes liés à la propriété et à l’attribution des images sans sacrifier les performances », écrivent-ils.

Selon Meta, CM3leon est un pas en avant vers la génération et la compréhension d’images de haute fidélité, ouvrant la voie à des modèles de langage multimodaux. Et Meta croit toujours au métavers, affirmant que des modèles comme CM3leon « pourraient en fin de compte favoriser la créativité et de meilleures applications dans le métavers » Avec l’aide de The Decoder.