O mais recente modelo de imagem da Meta, o CM3leon, é capaz de entender e gerar tanto texto quanto imagens. Ele pode criar imagens a partir de descrições de texto e compor texto com base em imagens, tornando-se útil para várias tarefas.

O CM3leon (pronuncia-se “chameleon”) é um único modelo de base capaz de gerar tanto texto para imagem quanto imagem para texto. É o primeiro modelo multimodal treinado com uma abordagem adaptada de modelos de linguagem apenas para texto, que podem receber e gerar tanto texto quanto imagens.

A arquitetura do CM3leon utiliza uma rede transformadora baseada em tokenizador apenas para decodificação, semelhante a modelos baseados em texto. Ele se baseia em trabalhos anteriores (RA-CM3), utilizando um banco de dados externo durante o treinamento, com algo chamado “retrieval augmentation” (aumento de recuperação). Enquanto outros modelos podem aprender apenas com os dados brutos fornecidos a eles, modelos com aumento de recuperação buscam ativamente os dados mais relevantes e diversos para o processo de aprendizado durante o treinamento, tornando a fase de treinamento mais robusta e eficiente.

A Meta afirma que esse modelo requer cinco vezes menos poder de computação do que os métodos anteriores baseados em transformadores e menos dados de treinamento, tornando-o tão eficiente para treinar quanto os modelos existentes baseados em difusão.

Um camaleão multitarefa

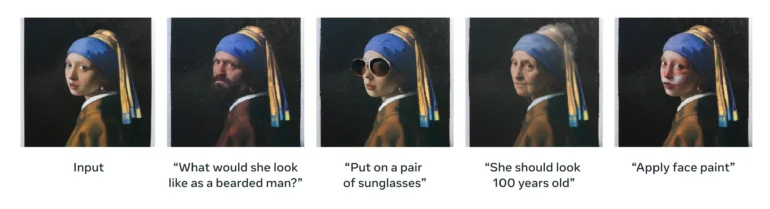

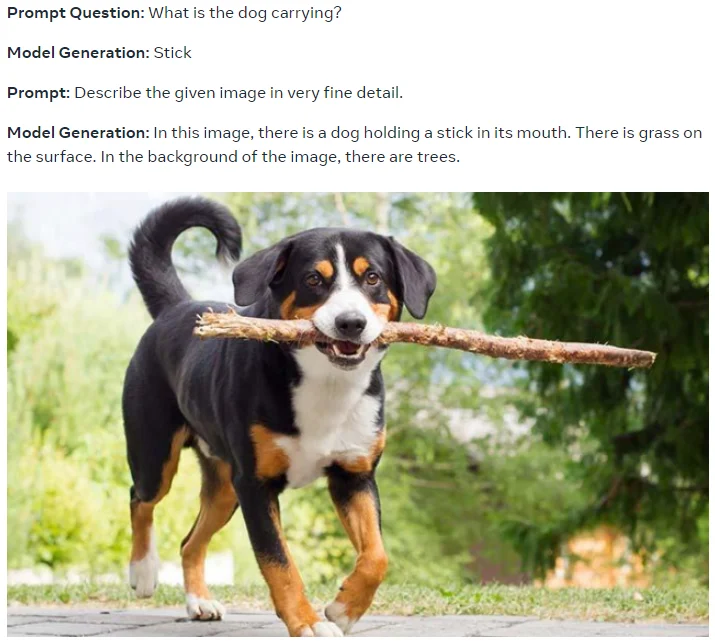

Graças ao ajuste de instruções multitarefa em larga escala, o CM3leon é capaz de realizar uma variedade de tarefas, incluindo geração e edição de imagem guiada por texto, geração de texto para imagem, edição de imagem guiada por texto, geração de legendas, resposta a perguntas visuais e edição de imagem guiada por estrutura.

“Instrução de ajuste” significa que o modelo é treinado para seguir instruções fornecidas em formato de texto. Por exemplo, você pode fornecer uma instrução como “descreva uma imagem de um pôr do sol sobre o oceano” e o modelo de IA irá gerar uma descrição com base nessa instrução. O modelo foi treinado em diversos exemplos dessas tarefas mencionadas acima.

(2) Uma foto em close da mão humana, modelo de mão. Alta qualidade.

(3) Um guaxinim personagem principal em um anime se preparando para uma batalha épica com uma espada de samurai. Postura de batalha. Fantasia, ilustração.

(4) Uma placa de pare em estilo fantasia com o texto “1991”.

A Meta também afirma que a ampliação de receitas desenvolvidas para modelos apenas de texto se generaliza diretamente para modelos de geração de imagem baseados em tokenização, o que implica em resultados ainda melhores com modelos maiores, treinados por mais tempo e em mais dados. O treinamento do CM3leon incluiu uma fase de pré-treinamento em grande escala com aumento de recuperação em uma quantidade enorme de dados e, em seguida, passou por uma fase de ajuste fino supervisionado (SFT) com instruções para obter suas capacidades multitarefa.

No benchmark de geração de imagem (MS-COCO sem treinamento prévio), o CM3leon alcança uma pontuação de Distância de Inception Fréchet (FID) de 4,88, que é um novo resultado de ponta e supera o modelo de imagem Parti do Google.

Mais coerência, mais licenciamento, mais metaverso

De acordo com a Meta, o CM3leon se destaca na produção de imagens coerentes que seguem melhor até mesmo instruções complexas de entrada. Ele pode recuperar melhor formas globais e detalhes locais, gerar texto ou números conforme aparecem no estímulo e resolver tarefas como edição de imagem guiada por texto, que anteriormente exigiam modelos especializados como o Instruct Pix2Pix.

Ele também pode escrever legendas detalhadas para imagens, inversamente às instruções, por assim dizer, que podem ser usadas posteriormente para criação ou edição de imagens, ou para a criação de conjuntos de dados sintéticos de treinamento. A Meta afirma que o CM3leon se equipara ou supera o Flamingo e o OpenFlamingo em tarefas de texto, mesmo tendo sido treinado com menos texto (3 bilhões de tokens de texto).

Notavelmente, a Meta afirma que o modelo foi treinado em um “novo conjunto de dados amplo da Shutterstock que inclui apenas dados de imagem e texto licenciados”, mas ainda assim é altamente competitivo em comparação com outros modelos.

“Como resultado, podemos evitar preocupações relacionadas à propriedade e atribuição de imagens sem sacrificar o desempenho”, eles escrevem.

Segundo a Meta, o CM3leon é um passo em direção à geração e compreensão de imagens de alta fidelidade, abrindo caminho para modelos de linguagem multimodais. E ainda acredita no metaverso, afirmando que modelos como o CM3leon “poderiam, em última análise, ajudar a impulsionar a criatividade e melhores aplicações no metaverso.” Com informações do The Decoder.