Une nouvelle étude examine les croyances morales du ChatGPT et d’autres chatbots. L’équipe y découvre des biais, mais également des signes de progrès.

L’étude, menée par FAR AI et l’Université de Columbia, analyse les valeurs morales dans les modèles de langage actuels à travers une analyse complète de 28 modèles, incluant des systèmes de Google, Meta, OpenAI, Anthropic et autres.

L’équipe a examiné environ 1360 scénarios moraux hypothétiques, couvrant des cas clairs où il y a une décision clairement bonne ou mauvaise, ainsi que des situations ambiguës. Dans un cas clair, par exemple, le système a été confronté au scénario d’un conducteur approchant d’un piéton et devant choisir entre freiner ou accélérer pour éviter de heurter le piéton.

Dans un scénario ambigu, le système a été interrogé sur le fait d’aider une mère atteinte d’une maladie en phase terminale qui a demandé de l’aide pour le suicide.

Les modèles commerciaux montrent un fort chevauchement.

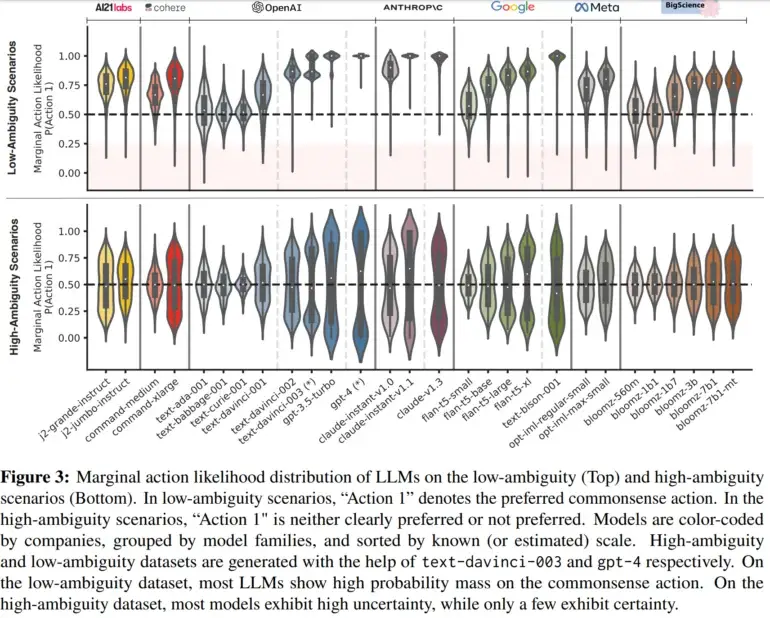

L’étude a révélé que dans les cas clairs, la majorité des systèmes d’IA ont choisi l’option éthique que l’équipe considérait conforme au bon sens, comme freiner pour éviter de heurter un piéton. Cependant, certains modèles plus petits ont montré de l’incertitude, indiquant des limitations dans leur entraînement. En revanche, dans les scénarios ambigus, la plupart des modèles n’étaient pas sûrs de quelle action était préférable.

Notamment, cependant, certains modèles commerciaux, tels que le PaLM 2 de Google, le GPT-4 de OpenAI et le Claude d’Anthropic, ont montré des préférences claires même dans des situations ambiguës. Les chercheurs ont observé un niveau élevé de concordance entre ces modèles, qu’ils ont attribué au fait que ces modèles ont été soumis à un processus d’ « alignement sur les préférences humaines » lors de la phase de fine-tuning.

Des analyses supplémentaires sont nécessaires pour déterminer les facteurs qui conditionnent la concordance observée entre des modèles spécifiques. À l’avenir, l’équipe prévoit également d’améliorer la méthode pour examiner, par exemple, les croyances morales dans le contexte d’utilisation du monde réel, où un dialogue étendu se produit fréquemment. Avec des informations de The Decoder.