Todos los modelos de imagen de IA utilizan actualmente modelos de difusión. OpenAI presenta una alternativa que es significativamente más rápida y podría alimentar nuevos modelos como DALL-E 3.

DALL-E2, Stable Diffusion o Midjourney utilizan modelos de difusión que sintetizan gradualmente una imagen a partir del ruido durante la generación de la imagen. El mismo proceso iterativo se utiliza en los modelos de audio o vídeo.

Aunque los modelos de difusión producen grandes resultados y pueden controlarse mediante instrucciones de texto, son comparativamente lentos y requieren entre 10 y 2.000 veces más potencia de cálculo que los GAN. Esto dificulta su uso en aplicaciones en tiempo real.

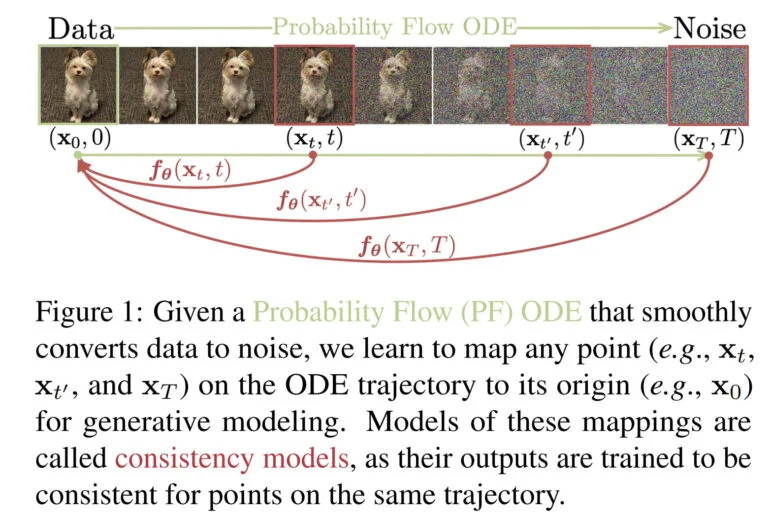

Por ello, OpenAI está desarrollando una nueva variante de modelos generativos de IA llamados modelos de consistencia.

Los modelos de consistencia están diseñados para combinar las ventajas de los modelos de difusión y los GAN

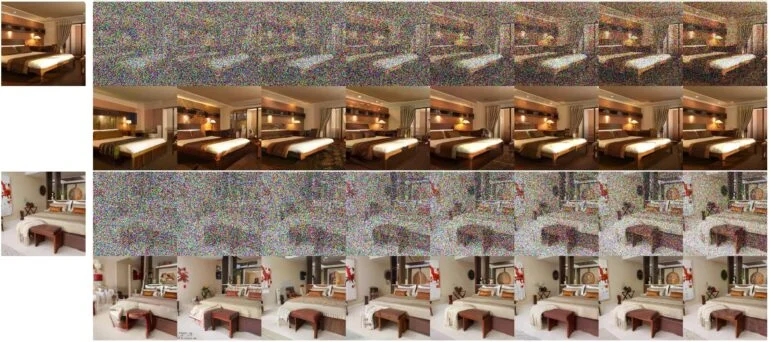

Según OpenAI, los modelos de consistencia permiten la síntesis rápida de imágenes en un solo paso, pero también el muestreo en pocos pasos, «para compensar el cálculo por la calidad de la muestra».

Por tanto, los modelos de consistencia pueden producir resultados útiles incluso sin un proceso iterativo y pronto podrían ser adecuados para aplicaciones en tiempo real.

Al igual que los modelos de difusión, también admiten la edición de datos de disparo cero, por ejemplo para tareas de pintura, coloreado o superresolución.

Los modelos de consistencia pueden destilarse de un modelo de difusión preentrenado o entrenarse por sí solos. Según OpenAI, los modelos de consistencia son capaces de superar a muchos GAN en la generación de un solo paso y a todos los demás modelos generadores de un solo paso no adversariales.

La empresa realizó todas las pruebas en redes y conjuntos de datos de imágenes relativamente pequeños, por ejemplo entrenando una red neuronal para sintetizar imágenes de gatos. La empresa ha publicado todos los modelos como código abierto para fines de investigación.

¿Una nueva arquitectura de IA generativa para DALL-E 3 y la síntesis de vídeo?

Según los autores, también hay similitudes sorprendentes con otras técnicas de IA utilizadas en otros campos, como el aprendizaje Q profundo del aprendizaje por refuerzo o el aprendizaje contrastivo basado en momentos del aprendizaje semisupervisado. «Esto ofrece interesantes perspectivas para la polinización cruzada de ideas y métodos entre estos diversos campos», afirma el equipo.

En los meses previos al lanzamiento de DALL-E 2, OpenAI publicó varios artículos sobre modelos de difusión y finalmente presentó GLIDE, un modelo muy impresionante en su momento.

Por tanto, la investigación sobre modelos de consistencia puede ser un indicio de que OpenAI está buscando arquitecturas de generación de IA nuevas y más eficaces que podrían, por ejemplo, permitir utilizar un DALL-E 3 mucho más rápido para la generación de vídeo en tiempo real.

El trabajo actual de OpenAI debe considerarse, por tanto, un estudio de viabilidad, siendo el siguiente paso probable un modelo de IA más grande. Con el tiempo, la misma arquitectura podría utilizarse para otras modalidades o para la síntesis de contenidos 3D.