Un nuevo informe explora la conciencia en sistemas de IA, utilizando teorías científicas de la conciencia para desarrollar propiedades indicativas que podrían señalar si un sistema de IA probablemente es consciente.

La inteligencia artificial ha avanzado significativamente en los últimos años y, en algunos casos, justificadamente o no, ha suscitado preguntas sobre si podría llegar a ser consciente. Un ejemplo reciente y famoso fue el del empleado de Google, Blake Lemoine, y sus comentarios sobre una LaMDA con conciencia. Un problema evidente con su atribución de conciencia fue que se basó exclusivamente en el comportamiento del modelo.

Ahora, un equipo interdisciplinario de investigadores ha publicado un nuevo informe desarrollando un «enfoque riguroso y empíricamente fundamentado para la conciencia de la IA». En relación con casos como el de Lemoine, el equipo argumenta: «Nuestra opinión es que, si bien esto puede no ser cierto en otros casos, un enfoque basado en teoría es necesario para la IA. Un enfoque basado en teoría es aquel que se centra en cómo funcionan los sistemas, en lugar de si exhiben formas de comportamiento externo que puedan considerarse características de seres conscientes».

En el informe, el equipo argumenta que evaluar la conciencia en la IA es científicamente factible y proporciona una lista de «propiedades indicativas».

Las teorías neurocientíficas de la conciencia informan las propiedades indicativas

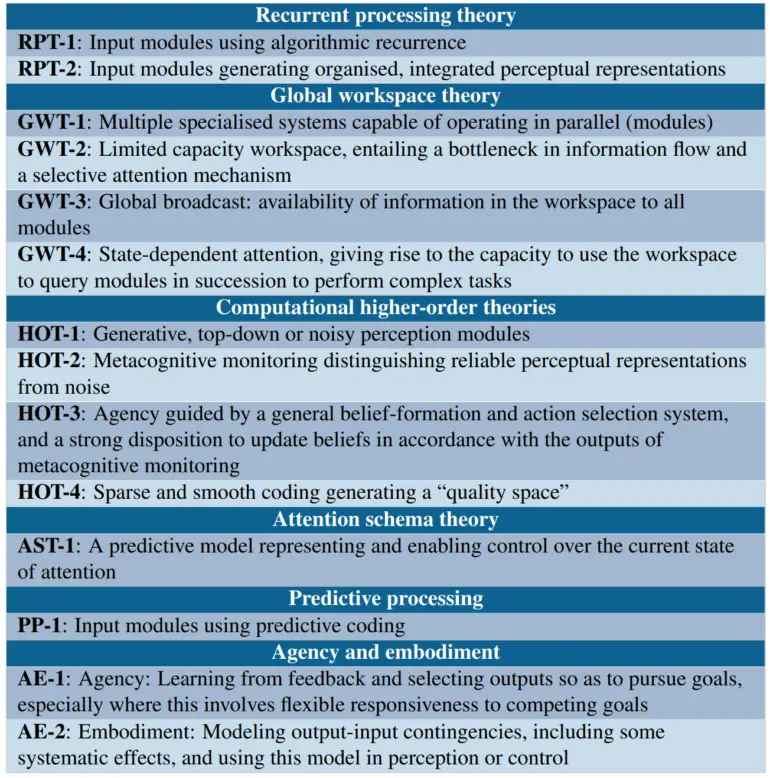

Los investigadores adoptan una perspectiva «funcionalista computacional», asumiendo que la conciencia depende de un sistema de IA que implementa ciertos cálculos. Luego, se basan en teorías neurocientíficas que buscan identificar las funciones computacionales específicas asociadas a la conciencia en los seres humanos. Esto incluye teorías de procesamiento recurrente, la teoría del espacio global de trabajo, teorías de orden superior como el monitoreo de la realidad perceptual, la teoría del esquema de atención, el procesamiento predictivo y teorías de agencia e incorporación.

A partir de estas teorías, los investigadores derivan una lista de propiedades indicativas cuya presencia hace más probable que un sistema de IA sea consciente. Por ejemplo, la teoría del espacio global de trabajo sugiere indicadores como tener múltiples subsistemas especializados y un espacio de trabajo de capacidad limitada que permite compartir información entre subsistemas.

Los investigadores utilizan las propiedades indicativas para evaluar algunos sistemas existentes

Argumentan que los grandes modelos de lenguaje, como GPT-3, carecen de la mayoría de las características de la teoría del espacio global de trabajo, mientras que la arquitectura Perceiver se acerca, pero aún no cumple con todos los indicadores del GWT.

En términos de agentes de IA incorporados, examinan el PaLM-E de Google, un «roedor virtual», y el AdA de Google Deepmind. Según el equipo, tales agentes de IA cumplen las condiciones de agencia e incorporación si su entrenamiento los lleva a aprender modelos apropiados que relacionen acciones con percepciones y recompensas. Los investigadores ven el AdA como el sistema más probable de los tres para ser incorporado según sus criterios.

El equipo pide más investigaciones para desarrollar métodos robustos para evaluar la probabilidad de conciencia en sistemas planeados antes de construirlos y planea seguir adelante y fomentar investigaciones adicionales.