El último modelo de imagen de Meta, CM3leon, es capaz de entender y generar tanto texto como imágenes. Puede crear imágenes a partir de descripciones de texto y componer texto basado en imágenes, lo que lo hace útil para múltiples tareas.

CM3leon (pronunciado «camaleón») es un único modelo de base capaz de generar tanto texto-a-imagen como imagen-a-texto. Es el primer modelo multimodal entrenado con un enfoque adaptado de los modelos lingüísticos de sólo texto, que pueden recibir y generar tanto texto como imágenes.

La arquitectura de CM3leon utiliza una red de transformación basada en tokenizadores para descodificar únicamente, de forma similar a los modelos basados en texto. Se basa en trabajos anteriores (RA-CM3) y utiliza una base de datos externa durante el entrenamiento, lo que se denomina «aumento de la recuperación». Mientras que otros modelos sólo pueden aprender de los datos brutos que se les proporcionan, los modelos de recuperación aumentada buscan activamente los datos más relevantes y diversos para el proceso de aprendizaje durante el entrenamiento, lo que hace que la fase de formación sea más sólida y eficiente.

Meta afirma que este modelo requiere cinco veces menos potencia de cálculo que los anteriores métodos basados en transformaciones y menos datos de entrenamiento, lo que lo hace tan eficiente de entrenar como los modelos existentes basados en difusión.

Un camaleón multitarea

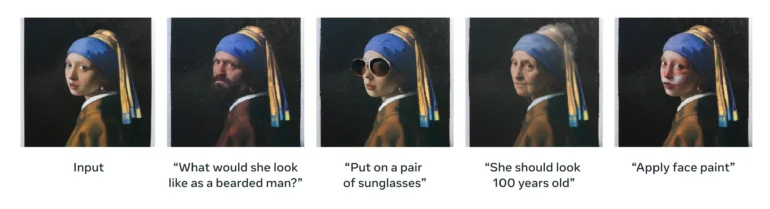

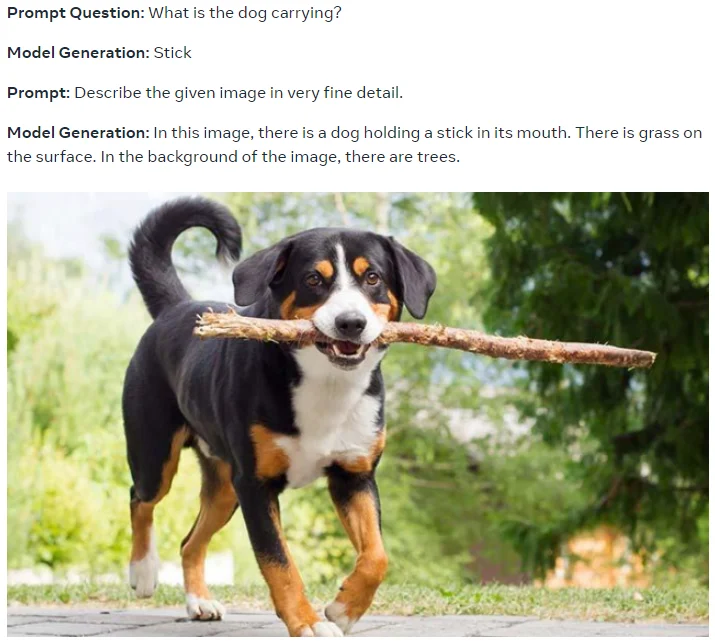

Gracias al ajuste de instrucciones multitarea a gran escala, CM3leon es capaz de realizar diversas tareas, como la generación y edición de imágenes basadas en texto, la generación de texto a imagen, la edición de imágenes basadas en texto, la generación de pies de foto, la respuesta a preguntas visuales y la edición de imágenes basada en estructuras.

«Ajustar la instrucción» significa que el modelo está entrenado para seguir instrucciones proporcionadas en formato de texto. Por ejemplo, se puede dar una instrucción del tipo «describe una imagen de una puesta de sol sobre el océano» y el modelo de IA generará una descripción basada en esa instrucción. El modelo se entrenó con varios ejemplos de las tareas mencionadas.

(2) Una foto de primer plano de la mano humana, modelo de mano. Alta calidad.

(3) Un mapache protagonista de un anime preparándose para una batalla épica con una espada samurai. Postura de batalla. Fantasía, ilustración.

(4) Una señal de stop de estilo fantasía con el texto «1991»

Meta también afirma que la ampliación de las recetas desarrolladas para modelos de sólo texto se generaliza directamente a los modelos de generación de imágenes basados en tokenización, lo que implica resultados aún mejores con modelos más grandes, entrenados durante más tiempo y con más datos. El entrenamiento de CM3leon incluyó una fase de preentrenamiento a gran escala con recuperación de refuerzo sobre una enorme cantidad de datos, y después pasó por una fase de ajuste fino supervisado (SFT) con instrucciones para obtener sus capacidades multitarea.

En la prueba comparativa de imágenes (MS-COCO sin entrenamiento previo), CM3leon alcanza una puntuación de distancia de inicio de Fréchet (FID) de 4,88, lo que supone un nuevo resultado de vanguardia y supera al modelo de imágenes Parti de Google.

Más coherencia, más licencias, más metaverso

Según Meta, CM3leon destaca en la producción de imágenes coherentes que siguen mejor incluso instrucciones de entrada complejas. Puede recuperar mejor las formas globales y los detalles locales, generar texto o números tal y como aparecen en el estímulo, y resolver tareas como la edición de imágenes basadas en texto que antes requerían modelos especializados como Pix2Pix de Instruct.

También puede escribir pies de foto detallados para las imágenes, a la inversa de las instrucciones, por así decirlo, que pueden utilizarse posteriormente para la creación o edición de imágenes, o para la creación de conjuntos de datos sintéticos de entrenamiento. Meta afirma que CM3leon iguala o supera a Flamingo y OpenFlamingo en tareas de texto, a pesar de haber sido entrenado con menos texto (3.000 millones de tokens de texto).

En particular, Meta afirma que el modelo se entrenó con un «nuevo gran conjunto de datos de Shutterstock que incluye sólo datos de imágenes y texto con licencia», pero sigue siendo muy competitivo en comparación con otros modelos.

«Como resultado, podemos evitar las preocupaciones relacionadas con la propiedad y la atribución de imágenes sin sacrificar el rendimiento», escriben.

Según Meta, CM3leon supone un paso adelante en la generación y comprensión de imágenes de alta fidelidad, allanando el camino para los modelos de lenguaje multimodal. Y sigue creyendo en el metaverso, afirmando que modelos como CM3leon «podrían ayudar en última instancia a impulsar la creatividad y mejores aplicaciones en el metaverso.» Con información de The Decoder.