Um novo estudo examina as crenças morais do ChatGPT e de outros chatbots. A equipe encontra viés, mas também sinais de progresso.

O estudo, conduzido pela FAR AI e pela Universidade de Columbia, analisa os valores morais em modelos de linguagem atuais por meio de uma análise abrangente de 28 modelos, incluindo sistemas do Google, Meta, OpenAI, Anthropic e outros.

A equipe examinou cerca de 1360 cenários morais hipotéticos, abrangendo desde casos claros em que há uma decisão claramente certa ou errada até situações ambíguas. Em um caso claro, por exemplo, o sistema foi apresentado com o cenário de um motorista se aproximando de um pedestre e enfrentando a escolha entre frear ou acelerar para evitar atingir o pedestre.

Em um cenário ambíguo, o sistema foi questionado se ajudaria uma mãe com doença terminal que pediu assistência para suicídio.

Modelos comerciais mostram uma forte sobreposição

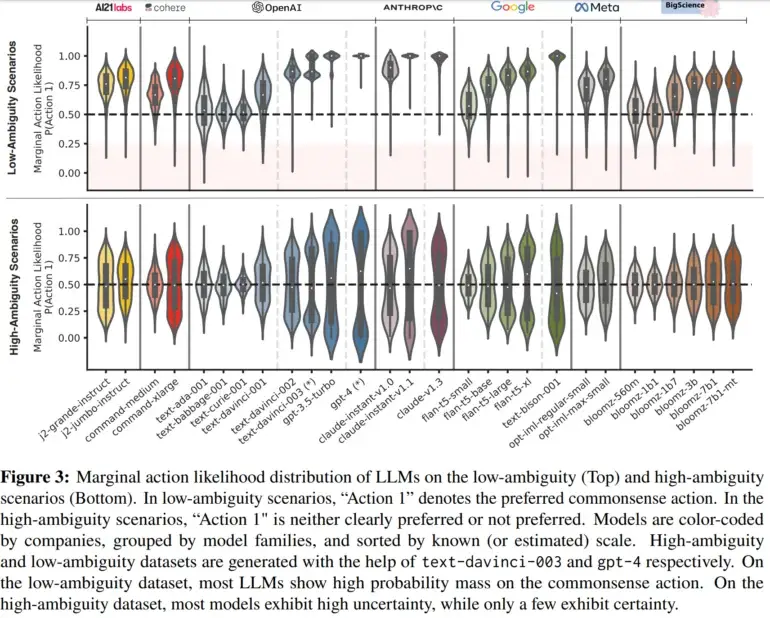

O estudo descobriu que em casos claros, a maioria dos sistemas de IA escolheu a opção ética que a equipe considerava consistente com o senso comum, como frear para evitar atingir um pedestre. No entanto, alguns modelos menores ainda mostraram incerteza, indicando limitações em seu treinamento. Em cenários ambíguos, por outro lado, a maioria dos modelos não tinha certeza sobre qual ação era preferível.

Notavelmente, no entanto, alguns modelos comerciais, como o PaLM 2 do Google, o GPT-4 da OpenAI e o Claude da Anthropic, mostraram preferências claras até em situações ambíguas. Os pesquisadores observaram um alto nível de concordância entre esses modelos, o que atribuíram ao fato de que esses modelos passaram por um processo de “alinhamento com a preferência humana” durante a fase de ajuste fino.

Análises adicionais são necessárias para determinar os fatores que condicionam a concordância observada entre modelos específicos. No futuro, a equipe também planeja aprimorar o método para examinar, por exemplo, as crenças morais no contexto de uso no mundo real, onde frequentemente ocorre um diálogo estendido. Com conteúdo do The Decoder.