Difusão Estável e DALL· O E 2 são dois dos melhores modelos de geração de imagens de IA disponíveis no momento — e funcionam da mesma maneira. Ambos os modelos foram treinados em milhões ou bilhões de pares texto-imagem. Isso permite que eles compreendam conceitos como cães, chapéus de cervo e iluminação escura, e é como eles podem entender o que um aviso como “uma pintura a óleo impressionista de um homem canadense montando um alce através de uma floresta de árvores de bordo” está realmente perguntando a eles.

Além de serem modelos de IA, Difusão Estável e DALL· E 2 ambos têm aplicativos que são capazes de pegar um prompt de texto e gerar uma série de imagens correspondentes. Então, qual desses aplicativos você deve usar? Vamos mergulhar.

Como fazer Stable Diffusion e DALL· E 2 trabalho?

Para geração de imagens, Difusão Estável e DALL· E 2 ambos dependem de um processo chamado difusão. O gerador de imagens começa com um campo aleatório de ruído e, em seguida, edita-o em uma série de etapas para corresponder à sua interpretação do prompt. Ao começar com um conjunto diferente de ruído aleatório a cada vez, eles podem criar resultados diferentes a partir do mesmo prompt. É como olhar para um céu nublado, encontrar uma nuvem que se parece com um cachorro e, em seguida, ser capaz de estalar os dedos para continuar a torná-lo cada vez mais parecido com um cachorro.

Uma nuvem em forma de cachorro flutuando em um céu azul claro – do alto à esquerda, indo no sentido horário, a 10 passos, 20 passos, 40 passos e 120 passos.

Embora ambos os modelos tenham bases técnicas semelhantes, há muitas diferenças entre eles.

Stability AI (os criadores do Stable Diffusion) e OpenAI (os criadores do DALL· E 2) têm diferentes abordagens filosóficas sobre como esses tipos de ferramentas de IA devem funcionar. Eles também foram treinados em diferentes conjuntos de dados, com diferentes decisões de design e implementação tomadas ao longo do caminho. Então, embora você possa usar ambos para fazer a mesma coisa, eles podem lhe dar resultados totalmente diferentes.

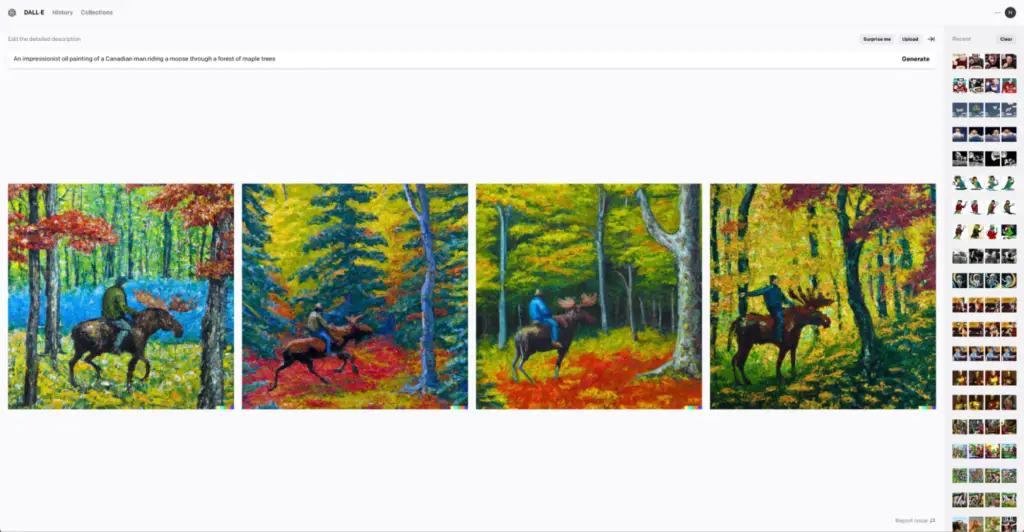

Aqui está o prompt que mencionei acima no DreamStudio (Stable Diffusion):

E aqui está em DALL· E 2:

Outra coisa a ter em mente: DALL· E 2 só está disponível através do OpenAI (ou outros serviços que usam sua API). Stable Diffusion é, na verdade, uma série de modelos de código aberto. Você pode acessá-lo através do aplicativo DreamStudio da Stability AI, mas também pode baixar a versão mais recente do Stable Diffusion, instalá-lo em seu próprio computador e até treiná-lo em seus próprios dados. (É assim que muitos serviços como os avatares de IA da Lensa funcionam.)

Vou me aprofundar no que tudo isso significa um pouco mais tarde, mas para facilitar a comparação, estarei principalmente comparando os modelos à medida que eles são acessados por meio de seus aplicativos web oficiais.

Stable Diffusion vs. DALL· E 2 em resumo

Difusão Estável e DALL· E 2 são construídos usando tecnologias semelhantes, mas diferem em alguns aspectos importantes. Aqui está um pequeno resumo das coisas, mas continue lendo para obter detalhes.

| Stable Diffusion | DALL· E 2 | |

|---|---|---|

| Qualidade | ⭐⭐⭐⭐⭐ Imagens excepcionais geradas por IA | ⭐⭐⭐⭐⭐ Imagens excepcionais geradas por IA |

| Facilidade de uso | ⭐⭐⭐ Muitas opções, mas pode ficar complicado | ⭐⭐⭐⭐⭐ Digite um prompt, clique em um botão |

| Potência e controle | ⭐⭐⭐⭐⭐ Você ainda precisa escrever um prompt, mas tem muito controle sobre o processo generativo | ⭐⭐ Opções muito limitadas além da pintura interna e externa |

Ambos fazem ótimas imagens geradas por IA

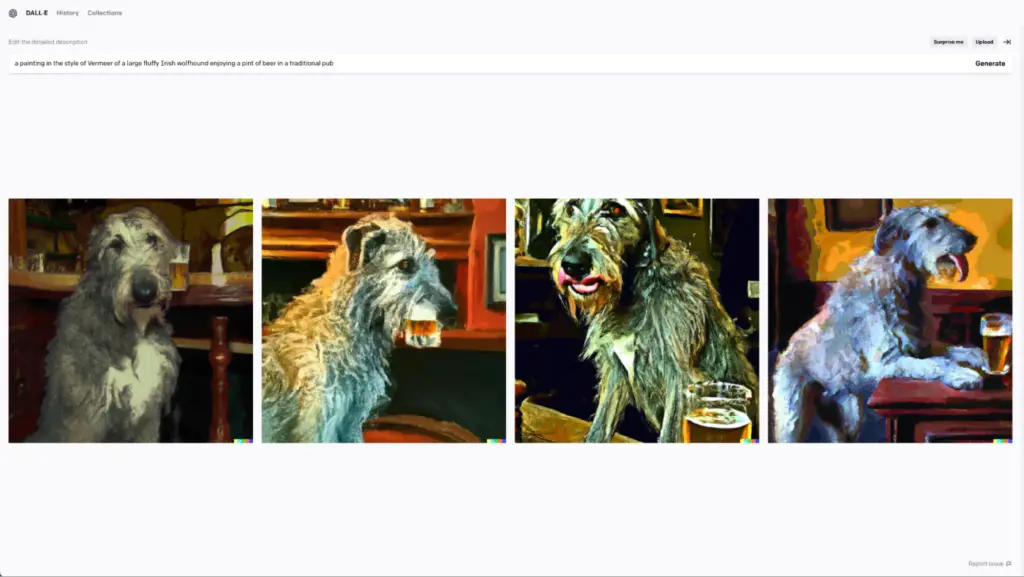

Vamos tirar a grande coisa do caminho: Difusão Estável e DALL· E 2 são capazes de produzir imagens incríveis geradas por IA. Eu me diverti muito brincando com os dois modelos, e fiquei chocado com a forma como eles acertaram certos prompts. Eu também ri bastante das duas trapalhadas. Realmente, nenhum modelo é objetivamente – ou mesmo subjetivamente – melhor do que o outro. Pelo menos não de forma consistente.

Se eu fosse forçado a destacar onde os modelos podem diferir, eu diria que:

- Por padrão, o Stable Diffusion tende para imagens mais realistas, enquanto DALL· E 2 pode ser mais abstrato.

- DALL· E 2 às vezes pode produzir melhores resultados a partir de prompts mais curtos do que a Difusão Estável.

Embora, novamente, os resultados que você obtém realmente dependam do que você pede – e de quanta “engenharia imediata” você está preparado para fazer.

Stable diffusion

DALL· E 2

DALL· E 2 é mais fácil de usar

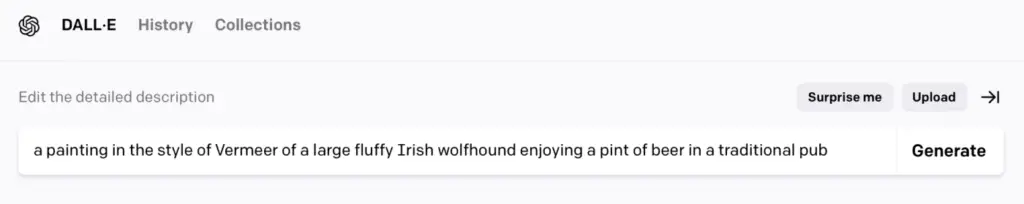

DALL· E 2 é incrivelmente simples de usar. Digite um prompt, pressione Gerar e você obterá quatro resultados. É como um brinquedo divertido.

Isso não quer dizer que você não possa mergulhar mais fundo com DALL· E 2º. Você pode carregar suas próprias imagens para usar como um prompt para criar mais variações, ou usar o editor para inpaint (substituir pedaços da imagem por elementos gerados por IA) ou outpaint (expandir a imagem com elementos gerados por IA). Só que muitas das porcas e parafusos estão escondidos.

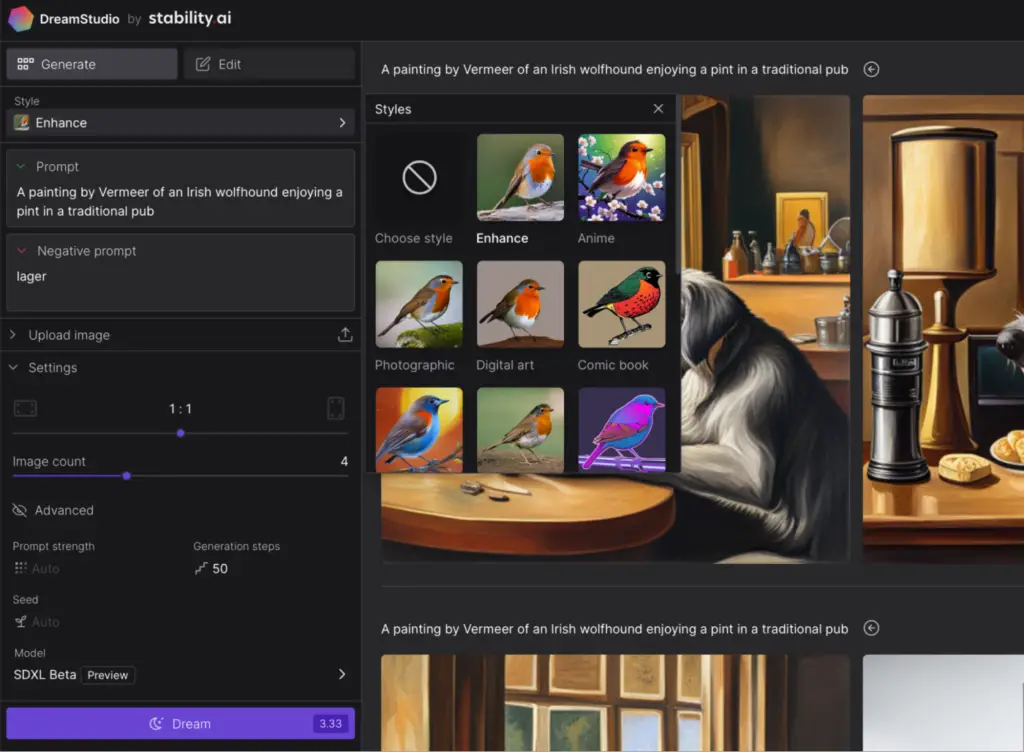

Fora da caixa, Stable Diffusion é um pouco menos fácil de usar. Embora você possa digitar um prompt, clicar em Dream e fazer tudo o mesmo inpainting e outpainting, há mais opções aqui que você não pode deixar de se perguntar.

Por exemplo: você pode selecionar um estilo (Enhance, Anime, Photographic, Digital Art, Comic Book, Fantasy Art, Analog Film ou Neon Punk). Há também duas caixas de prompt: uma para prompts regulares e outra para prompts negativos, as coisas que você não quer ver em suas imagens. E isso tudo antes de considerar as opções avançadas que permitem definir a força imediata, o número de passos de geração que o modelo dá, qual modelo é usado e até mesmo a semente que ele usa.

Claro, instalar e treinar sua própria instância de Difusão Estável é uma história totalmente diferente.

Stable diffusion é mais poderosa

Apesar de toda a sua facilidade de uso, DALL· E 2 não lhe dá muitas opções. Você pode gerar imagens a partir de um prompt e… é mais ou menos isso. Se você não gostar dos resultados, você tem que ajustar o prompt e tentar novamente. Alguns dos outros serviços que usam DALL· A API do E 2, como o NightCafé, oferece opções de estilo e um editor de prompt avançado com termos sugeridos para usar, mas você ainda está apenas moldando a saída com o prompt de texto.

A Difusão Estável (em cada iteração) oferece mais opções e controle. Como mencionei acima, você pode definir o número de etapas, a semente inicial e a força do prompt, e pode fazer um prompt negativo, tudo dentro do aplicativo Web DreamStudio.

E mesmo no NightCafé, que também suporta Difusão Estável, você tem mais opções do que com DALL· E 2º. Além de poder definir estilos e usar o editor de prompt avançado, você pode controlar qual semente é usada e qual método de amostragem é usado pelo algoritmo, entre outras coisas.

Finalmente, se você quiser criar uma IA generativa treinada sob medida em dados específicos, como seu próprio rosto, logotipos ou qualquer outra coisa, você pode fazer isso com a Difusão Estável. Isso permite que você crie um gerador de imagens que produza consistentemente um determinado tipo ou estilo de imagem. Os detalhes de como você faz isso estão muito além do escopo desta comparação, mas a questão é que isso é algo que a Difusão Estável foi projetada para fazer que não é remotamente possível com DALL· E 2º.

Stable diffusion ganha em preços

DALL· O preço do E 2 é super simples. Cada prompt de texto gera um conjunto de quatro imagens e custa um crédito. Os créditos custam US$ 15 para 115, então isso é ~US$ 0,13/prompt ou ~US$ 0,0325/imagem. Cada rodada de outpainting ou inpainting também gera quatro opções e custa um crédito. (Se você se inscreveu no DALL· E 2 antes de 6 de abril de 2023, houve um teste gratuito, e você recebeu 40 créditos gratuitos todos os meses. Infelizmente, essa opção desapareceu.)

O preço da Stable Diffusion é muito mais complicado.

Vamos supor que você esteja acessando-o através do DreamStudio, não baixando o Stable Diffusion e executando-o em seu computador ou acessando-o através de algum outro serviço que use um modelo personalizado treinado. Nesse caso, o Stable Diffusion também usa um sistema de créditos, mas não é nem de longe tão legal quanto um crédito, um prompt. Como você tem muitas opções, o preço muda de acordo com o tamanho, o número de etapas e o número de imagens que você deseja gerar. Digamos que você queira gerar quatro imagens de 512×512 pixels com o modelo mais recente usando 50 etapas. Isso custaria 3,32 créditos. Se você quisesse usar apenas 30 passos, custaria apenas 2 créditos. (Você sempre pode ver o custo antes de pressionar Dream.)

Você recebe 25 créditos gratuitos quando se inscreve no Dream Studio, o que é suficiente para ~30 imagens (ou sete prompts de texto) com as configurações padrão. Depois disso, custa US$ 10 para 1.000 créditos. Isso é suficiente para mais de 1.000 imagens ou ~300 prompts de texto nas configurações padrão.

Então, se você ignorar toda a confusão e se concentrar no número de imagens padrão que você pode gerar por dólar, a Difusão Estável leva isso. E tem um teste gratuito.

O uso comercial é complicado para ambos

Se você está planejando usar Difusão Estável ou DALL· E 2 para uso comercial, as coisas ficam um pouco complicadas.

O uso comercial é atualmente permitido por ambos, mas as implicações não foram totalmente exploradas. Em uma decisão em fevereiro de 2023, o Escritório de Direitos Autorais dos EUA decidiu que imagens criadas pela Midjourney, outra IA generativa, não podem ser protegidas por direitos autorais. Isso significa que qualquer pessoa pode ser capaz de pegar livremente qualquer imagem que você criar e usá-la para fazer o que quiser, embora isso não tenha sido realmente testado.

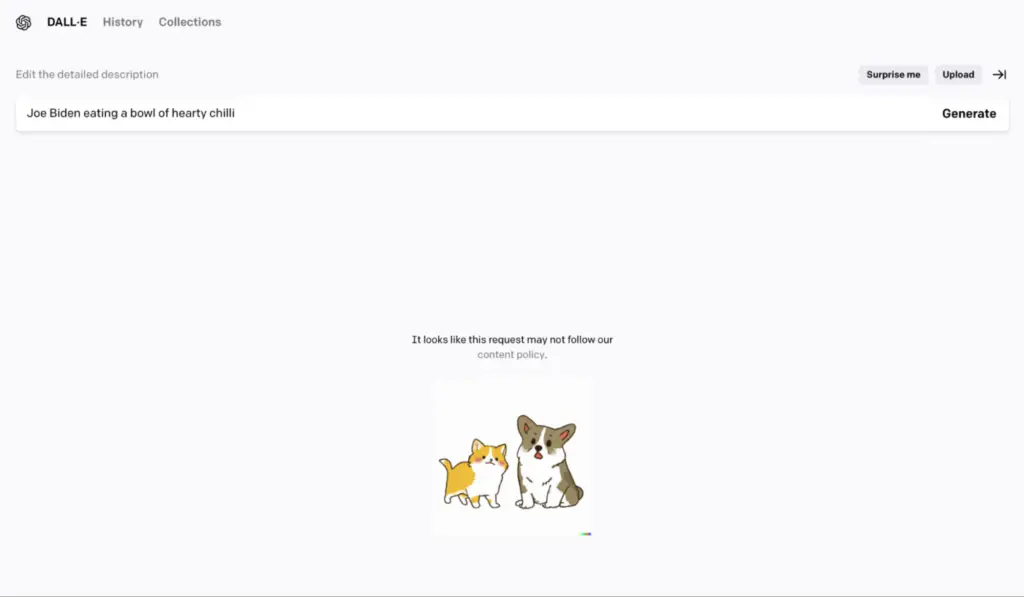

Puramente do ponto de vista da licença, a Difusão Estável tem uma ligeira vantagem. Seu modelo tem menos grades de proteção — e menos ainda se você mesmo treinar um — para que você possa criar mais tipos de conteúdo. DALL· E 2 não permitirá que você crie uma enorme quantidade de conteúdo, incluindo imagens de figuras públicas.

DALL· E 2 também adiciona uma marca d'água multicolorida ao canto inferior direito de suas imagens, embora você tenha permissão para removê-la.

DALL· E 2 vs. Stable Diffusion: Qual você deve usar?

Enquanto DALL· E 2 é o maior nome na geração de imagens de IA, pode fazer sentido experimentar o Stable Diffusion primeiro: ele tem um teste gratuito, é mais barato, é mais poderoso e tem direitos de uso mais permissivos. Se você sair totalmente do fundo do poço, você também pode usá-lo para desenvolver sua própria IA generativa personalizada.

Quando DALL· E 2 teve um ótimo teste gratuito, havia muito para amar sobre sua simplicidade. Se a OpenAI traz isso de volta, então faz sentido para quem está apenas curioso para ver o que os geradores de imagem de IA podem fazer.

De qualquer forma, a decisão não se resume à qualidade da saída gerada, mas sim à experiência geral do usuário. Ambos os aplicativos podem criar imagens incríveis, hilárias e absolutamente bizarras a partir do prompt certo. E, no final, você pode acabar usando um aplicativo de terceiros construído em um desses dois modelos, nesse caso, você pode nem notar a diferença.