Até agora, a IA tem enfrentado dificuldades para controlar as interfaces de smartphones. Mas os pesquisadores do Google parecem ter encontrado uma solução.

Para melhorar a interação baseada em voz com as interfaces de usuário móveis, pesquisadores do Google Research têm investigado o uso de grandes modelos de linguagem (LLM, na sigla em inglês). Os assistentes inteligentes móveis atuais têm limitações nas interações conversacionais, pois não conseguem responder a perguntas sobre informações específicas na tela.

Os pesquisadores desenvolveram um conjunto de técnicas para aplicar os LLMs às interfaces de usuário móveis, incluindo um algoritmo que converte a interface do usuário em texto. Essas técnicas permitem que os desenvolvedores prototipem e testem rapidamente novas interações baseadas em voz. Os LLMs são adequados para o aprendizado de prompts contextuais, nos quais o modelo recebe alguns exemplos da tarefa em questão.

Grandes modelos de linguagem como interface para smartphones

Foram estudadas quatro tarefas-chave em experimentos extensivos. De acordo com os pesquisadores, os resultados mostram que os LLMs são competitivos nessas tarefas, exigindo apenas dois exemplos por tarefa.

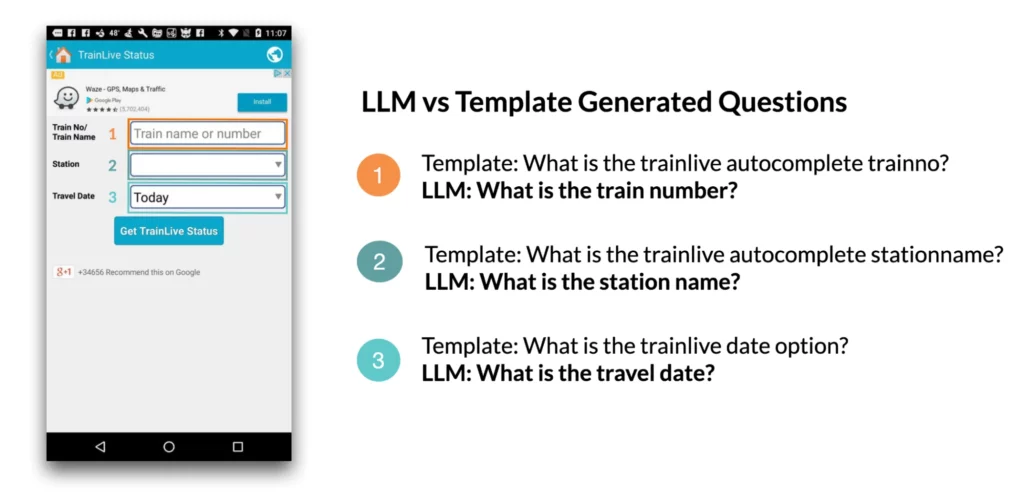

1. Gerar perguntas na tela: Por exemplo, ao ser apresentado com uma interface de usuário móvel (UI), o modelo de linguagem pode gerar perguntas relevantes sobre os elementos da UI que requerem entrada do usuário. De acordo com o estudo, os modelos de linguagem foram capazes de gerar perguntas com uma gramática quase perfeita (4,98/5) que eram 92,8% relevantes para os campos de entrada exibidos na tela.

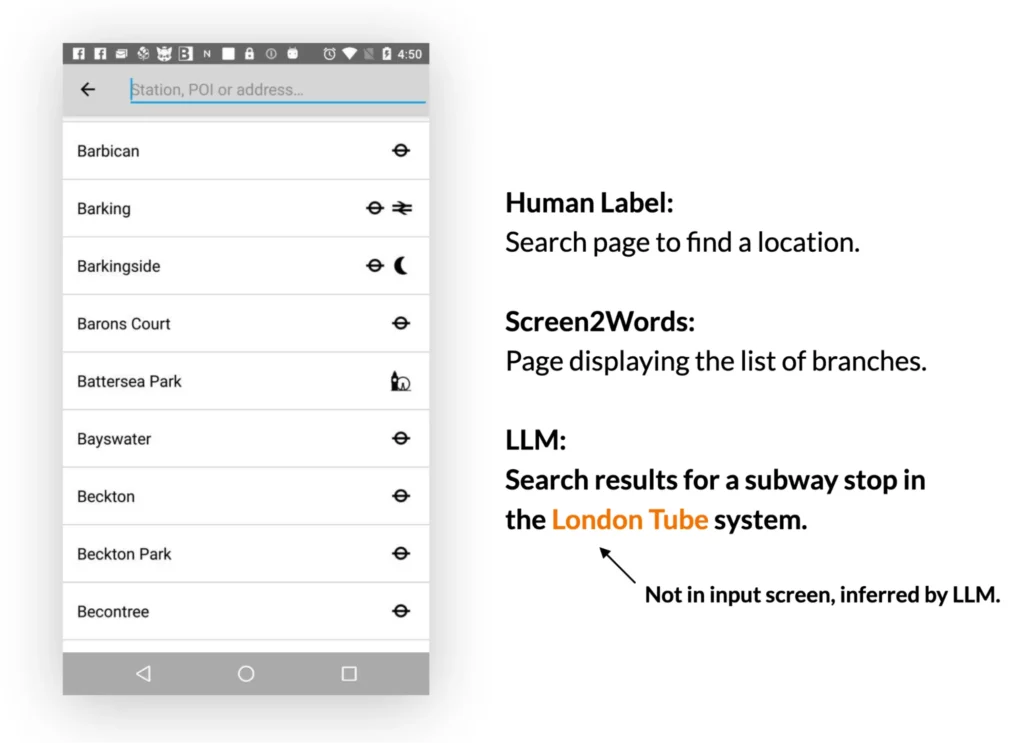

2. Resumo da tela: Os LLMs podem resumir efetivamente as principais características de uma interface de usuário móvel. Eles geram resumos mais precisos do que o modelo Screen2Words introduzido anteriormente e até mesmo podem inferir informações que não são diretamente apresentadas na UI.

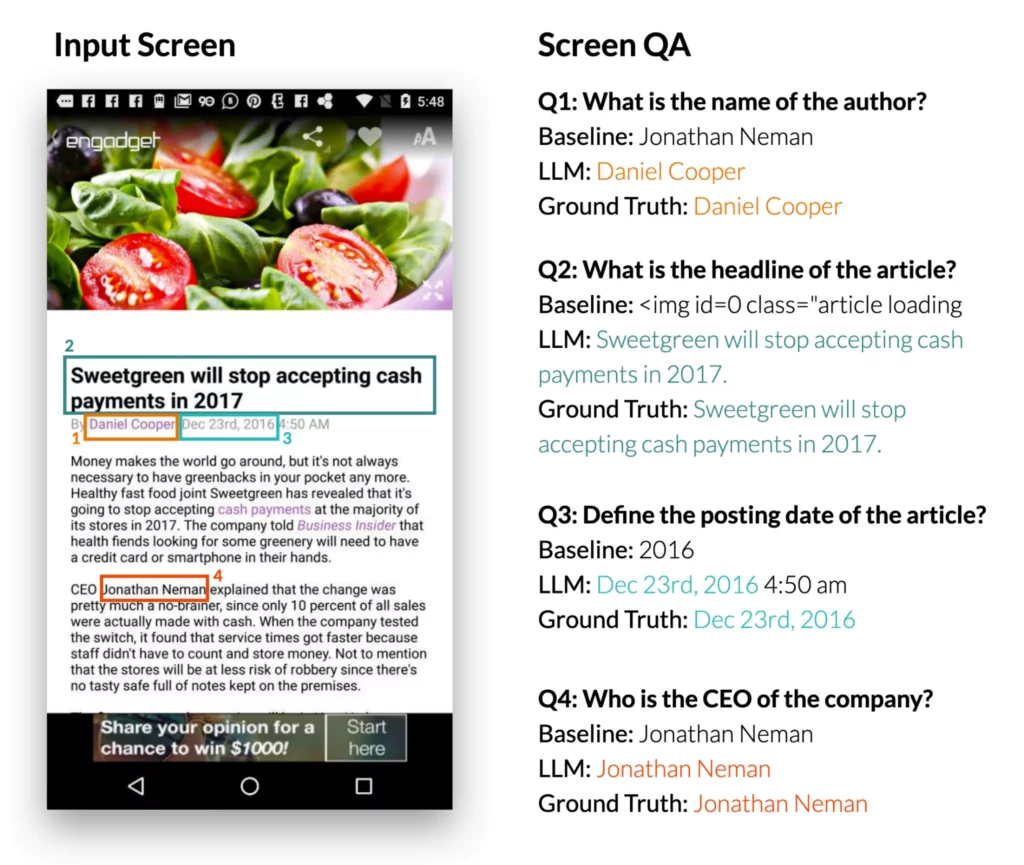

3. Responder perguntas na tela: Ao ser apresentado com uma interface de usuário móvel e uma pergunta aberta que requer informações sobre a UI, os LLMs podem fornecer a resposta correta. O estudo mostra que os LLMs podem responder a perguntas como “Qual é a manchete?” O LLM teve um desempenho significativamente melhor do que o modelo DistilBERT QA de referência.

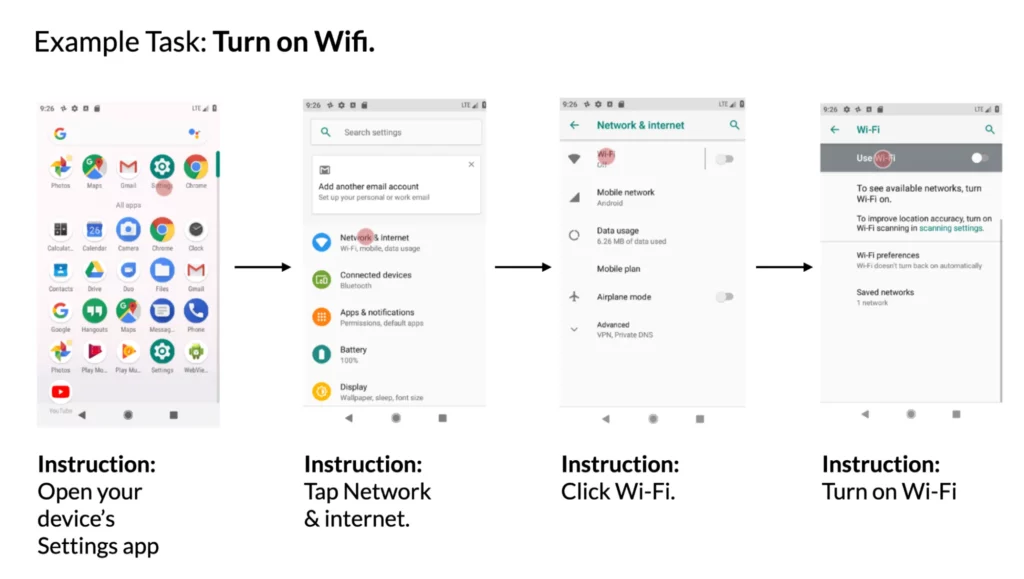

4. Mapear instruções para ações na UI: Ao ser fornecida uma interface de usuário móvel e uma instrução em linguagem natural para controlá-la, o modelo pode prever o ID do objeto para o qual a ação fornecida deve ser executada. Por exemplo, ao receber a instrução “Abrir o Gmail”, o modelo foi capaz de identificar corretamente o ícone do Gmail na tela inicial.

Os pesquisadores do Google concluem que a prototipagem de novas interações baseadas em voz nas UIs móveis pode ser simplificada ao utilizar os LLMs. Isso abre novas possibilidades para designers, desenvolvedores e pesquisadores antes de investirem no desenvolvimento de novos bancos de dados e modelos.