As imagens geradas por IA estão se tornando cada vez mais realistas, e até o momento não há uma maneira confiável de detectá-las. Os pesquisadores do MIT podem não conseguir mudar isso, mas pelo menos podem proteger imagens existentes contra a manipulação de IA.

Em vez de tentar detectar a manipulação, os pesquisadores desejam tornar as imagens originais mais resistentes, de modo que a manipulação seja impossível ou muito difícil.

“PhotoGuard” é o nome do sistema que introduz perturbações mínimas nos pixels de uma imagem original que são invisíveis para os humanos, mas podem ser detectadas por sistemas de IA.

Essas perturbações são projetadas para tornar a manipulação de imagens muito mais difícil. O sistema foi desenvolvido pelo Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do Instituto de Tecnologia de Massachusetts (MIT).

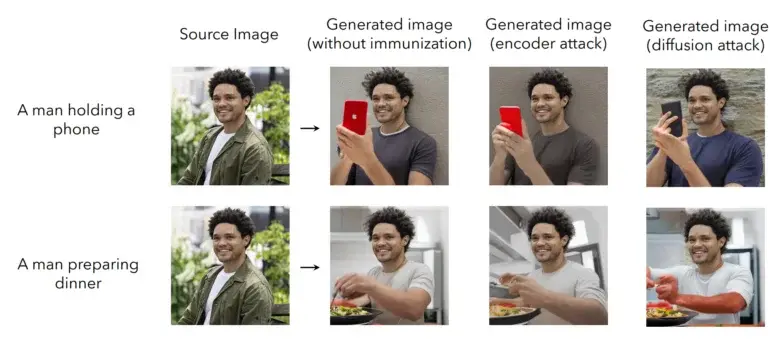

O PhotoGuard utiliza dois métodos para “imunizar” uma imagem contra a manipulação de IA. O primeiro método, chamado de “ataque do codificador”, visa a abstração existente da imagem pelo modelo de IA no espaço latente e manipula os dados de tal forma que o modelo não reconheça claramente mais a imagem original, introduzindo falhas. A mudança é análoga a uma frase gramaticalmente incorreta, cujo significado ainda é claro para os humanos, mas que pode confundir um modelo de linguagem.

O segundo método, chamado de “ataque de difusão”, é mais sofisticado: para uma imagem original, é definida uma imagem de destino específica que é determinada por mudanças mínimas de pixels na imagem original durante a inferência. Quando o modelo de IA tenta modificar a imagem original, ele é redirecionado automaticamente para a imagem de destino definida pelos pesquisadores, e o resultado não faz mais sentido. Assista ao vídeo abaixo para ver o sistema em ação.

Integrando a proteção contra manipulação diretamente nos modelos

Os pesquisadores sugerem que suas proteções, ou proteções similares, poderiam ser oferecidas diretamente pelos desenvolvedores de modelos. Por exemplo, eles poderiam disponibilizar um serviço por meio de uma API que permita que as imagens sejam imunizadas contra as capacidades de manipulação de seu modelo específico. Essa imunização também precisaria ser compatível com modelos futuros e poderia ser incorporada como uma porta dos fundos durante o treinamento do modelo.

Uma proteção ampla contra a manipulação de IA exigirá uma abordagem colaborativa entre desenvolvedores, plataformas de mídia social e formuladores de políticas, que poderiam, por exemplo, exigir que os desenvolvedores de modelos também ofereçam proteção, afirmam os pesquisadores.

Eles também apontam que o PhotoGuard não fornece proteção completa. Atacantes poderiam tentar manipular a imagem protegida, por exemplo, cortando-a, adicionando ruído ou girando-a. No entanto, em geral, os pesquisadores veem potencial para desenvolver modificações robustas que possam resistir a tais manipulações.