AIによって生成される画像はますますリアルになっており、それらを信頼性のある方法で検出する手段は現在まで存在しません。MITの研究者たちは、この点を変えることはできないかもしれませんが、少なくとも既存の画像をAIによる操作から保護することは可能です。

操作を検出しようとする代わりに、研究者たちは元の画像をより耐性のあるものにしたいと考えています。これにより、操作が不可能または非常に困難になるような仕組みを構築したいというのが彼らの願いです。

“PhotoGuard”は、元の画像のピクセルに微小な摂動を導入するシステムで、人間には見えないがAIシステムによって検知されることができます。

これらの摂動は、画像の操作を非常に困難にするように設計されています。このシステムは、マサチューセッツ工科大学(MIT)のコンピュータ科学および人工知能研究所(CSAIL)によって開発されました。

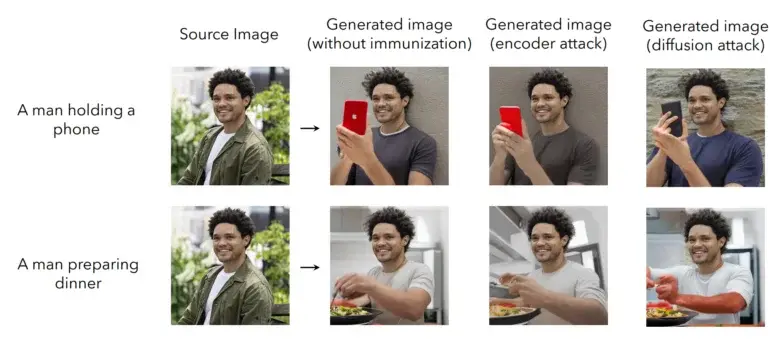

PhotoGuardは、画像をAIによる操作から「免疫」するために2つの方法を使用しています。最初の方法は「エンコーダの攻撃」と呼ばれ、AIモデルによる画像の潜在空間内での既存の抽象化を対象とし、データを操作してモデルが元の画像を明確に認識しないようにし、欠陥を導入します。この変化は、意味は人間にはまだ理解できるが、言語モデルを混乱させる文法的に間違っている文に類似しています。

2つ目の方法は「拡散攻撃」と呼ばれ、より洗練されています。元の画像に対して、推論中に元の画像のピクセルに対して最小限の変更を加えた特定の目標画像が定義されます。AIモデルが元の画像を変更しようとすると、自動的に研究者によって定義された目標画像にリダイレクトされ、結果はもはや意味を成さなくなります。以下の動画で、このシステムの動作を見ることができます。

保護機能をモデルに直接統合する

研究者たちは、自らの保護機能、または類似の保護機能を、モデルの開発者自身によって提供できると提案しています。例えば、彼らはAPIを介してサービスを提供することができます。このAPIにより、画像が特定のモデルの操作能力から「免疫」されることが可能になります。また、この免疫機能は将来のモデルにも対応し、モデルのトレーニング中にバックドアとして組み込むことができる必要があります。

AI操作に対する広範な保護は、開発者、ソーシャルメディアプラットフォーム、および政策立案者の協力的なアプローチを必要とします。例えば、政策立案者は、モデルの開発者に保護機能を提供することを要求することが考えられます。

研究者はまた、PhotoGuardが完全な保護を提供しているわけではないと指摘しています。攻撃者は保護された画像を操作しようとする可能性があります。例えば、画像を切り取ったり、ノイズを追加したり、回転させたりすることが考えられます。ただし、一般的に、研究者はこれらの操作に耐える堅牢な変更を開発する可能性があると考えています。