Atualizado em 07 de setembro de 2023:

O Instituto de Inovação Tecnológica lança o Falcon-180B, o maior modelo da série Falcon. Ele é baseado no Falcon 40B e foi treinado com 3,5 trilhões de tokens em até 4096 GPUs simultaneamente via Amazon SageMaker para um total de ~7.000.000 horas de GPU.

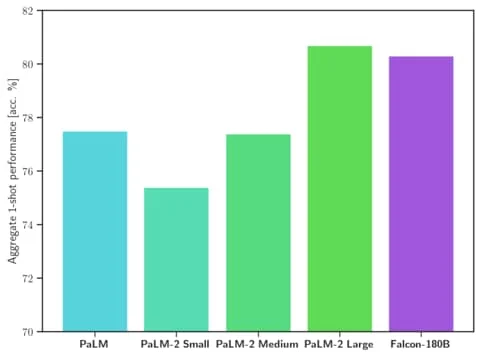

Diz-se que o Falcon 180B supera o Llama 2 70B, bem como o GPT-3.5 da OpenAI. Dependendo da tarefa, estima-se que o desempenho esteja entre GPT-3.5 e GPT-4, e no mesmo nível do modelo de linguagem PaLM 2 do Google em vários benchmarks.

No ranking Hugging Face Open Source LLM, o Falcon 180B está atualmente à frente do Llama 2 da Meta. Mas em comparação com o Llama 2, o Falcon180B exigiu quatro vezes mais computação para treinar, e o modelo é 2,5 vezes maior. Um modelo de bate-papo ajustado está disponível.

Você pode encontrar uma demonstração do Falcon-180B e mais informações em Hugging Face. O uso comercial é possível, mas muito restritivo. Você deve dar uma olhada na licença.

Artigo original de 29 de maio de 2023:

Modelo de linguagem de código aberto FalconLM supera LLaMA da Meta

O modelo de linguagem de código aberto FalconLM oferece melhor desempenho do que o LLaMA da Meta e também pode ser usado comercialmente. Mas o uso comercial está sujeito a royalties se as receitas excederem US$ 1 milhão.

O FalconLM está sendo desenvolvido pelo Instituto de Inovação Tecnológica (TII) em Abu Dhabi, Emirados Árabes Unidos. A organização afirma que o FalconLM é o modelo de linguagem de código aberto mais poderoso até o momento, embora a maior variante, com 40 bilhões de parâmetros, seja significativamente menor do que o LLaMA da Meta, com 65 bilhões de parâmetros.

No Hugging Face OpenLLM Leaderboard, que resume os resultados de vários benchmarks, os dois maiores modelos FalconLM, um dos quais foi refinado com instruções, atualmente ocupam as duas primeiras posições por uma margem significativa. A TII também oferece um modelo de 7 bilhões.

ChatGPT x Google: quem ganha em 500 buscas?

FalconLM treina com mais eficiência que GPT-3

Um aspecto importante da vantagem competitiva do FalconLM, de acordo com a equipe de desenvolvimento, é a seleção de dados para treinamento. Os modelos de linguagem são sensíveis à qualidade dos dados durante o treinamento.

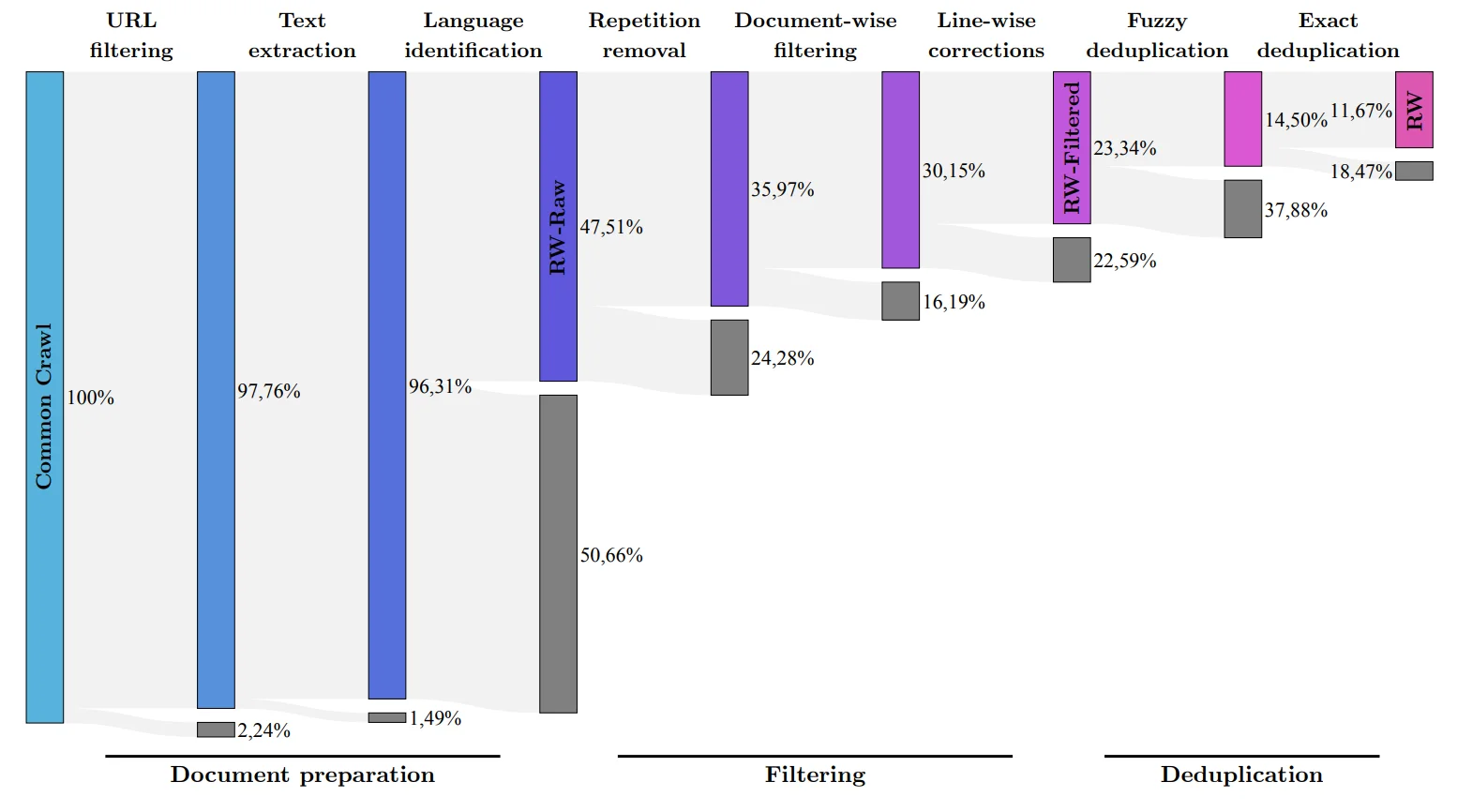

A equipe de pesquisa desenvolveu um processo para extrair dados de alta qualidade do conhecido conjunto de dados de rastreamento comum e remover duplicatas. Apesar dessa limpeza completa, cinco trilhões de pedaços de texto (tokens) permaneceram – o suficiente para treinar modelos de linguagem poderosos. A janela de contexto está em 2048 tokens, um pouco abaixo do nível do ChatGPT.

FalconLM com 40 bilhões de parâmetros foi treinado com um trilhão de tokens, o modelo com 7 bilhões de parâmetros com 1,5 trilhão. Os dados do conjunto de dados RefinedWeb foram enriquecidos com “alguns” conjuntos de dados selecionados de artigos científicos e discussões nas redes sociais. A versão instrucional de melhor desempenho, a versão do chatbot, foi ajustada usando o conjunto de dados Baize.

O TII também menciona uma arquitetura otimizada para desempenho e eficiência, mas não fornece detalhes. O documento ainda não está disponível.

De acordo com a equipe, a arquitetura otimizada combinada com o conjunto de dados de alta qualidade resultou no FalconLM exigindo apenas 75% do esforço computacional do GPT-3 durante o treinamento, mas superando significativamente o modelo OpenAI mais antigo. Diz-se que os custos de inferência são um quinto do GPT-3.

Disponível como código aberto, mas o uso comercial pode ficar caro

Os casos de uso da TII para o FalconLM incluem geração de texto, resolução de problemas complexos, uso do modelo como chatbot pessoal ou em áreas comerciais, como atendimento ao cliente ou tradução.

Em aplicações comerciais, no entanto, a TII quer lucrar com um milhão de dólares em receita que pode ser atribuída ao modelo de linguagem: dez por cento das receitas são devidas como royalties. Qualquer pessoa interessada em uso comercial deve entrar em contato com o departamento de vendas da TII. Para uso pessoal e pesquisa, o FalconLM é gratuito.

Todas as versões dos modelos FalconLM estão disponíveis para download gratuito no Huggingface. Junto com os modelos, a equipe também está lançando uma parte do conjunto de dados “RefinedWeb” de 600 bilhões de tokens de texto como código aberto sob uma licença Apache 2.0. O conjunto de dados também é dito estar pronto para extensão multimodal, como os exemplos já incluem links e texto alternativo para imagens.