OpenAIはGPT-4を画像理解機能を持つマルチモーダルモデルとして紹介しているが、画像部分についてはまだ公開していない。MiniGPT-4はオープンソースモデルとして、本日より利用可能となります。

MiniGPT-4は画像理解機能を持つチャットボットです。これはOpenAIがGPT-4の発表時に紹介した機能ですが、Be my Eyesアプリ以外ではまだリリースされていません。

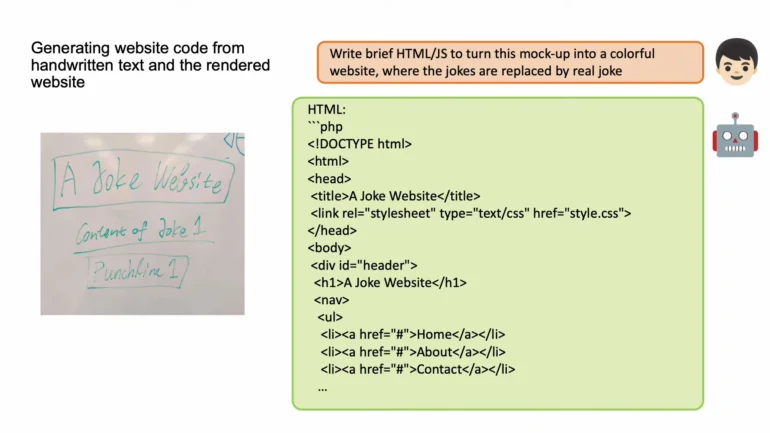

MiniGPT-4は、大型のGPT-4と同様に、画像を説明したり、画像の内容に関する質問に答えたりすることができます。例えば、調理された料理の画像が与えられると、モデルは(おそらく)対応するレシピを生成したり(特集画像を参照)、視覚障害者のために適切な画像説明を生成したりすることができます。Midjourneyの新機能”/describe “と同様に、MiniGPT-4は画像からプロンプト、または少なくともいくつかのアイデアを抽出することができます。研究者によれば、GPT-4の発表時に紹介されたOpenAIの評判の高い画像からウェブサイトへの変換機能も、MiniGPT-4で可能だという。

“我々の発見は、MiniGPT-4が、詳細な画像説明の生成や手書きスケッチからのウェブサイト作成など、GPT-4が示すものと類似した多くの機能を処理することを明らかにした “と論文は述べている。

開発チームは、MiniGPT-4のコード、デモ、トレーニング方法をGithubで公開している。また、Nvidia 3090グラフィックカード1枚で動作する小型バージョンも発表している。以下のビデオでいくつかの例を見ることができる。

オープンソースAIが台頭

MiniGPT-4の注目すべき点は、Vicuna-13B LLMとBLIP-2ビジョン言語モデルをベースにしていることである。このオープンソースソフトウェアは、比較的少ない資金で、膨大なデータや計算オーバーヘッドなしに訓練とチューニングが可能である。

研究チームはまず、4枚のNvidia A100カードで10時間かけて、約500万の画像とテキストのペアでMiniGPT-4を訓練した。第二段階として、MiniGPT-4とChatGPTの相互作用によって生成された3,500の高品質テキスト-画像ペアでモデルを改良した。ChatGPTは、MiniGPT-4によって生成された間違った、あるいは不正確な画像説明を修正した。

与えられた段落の誤りを修正する。繰り返される文章、無意味な文字、英語以外の文章などを削除する。不必要な繰り返しを削除してください。不完全な文章を書き直す。説明なしで結果を直接返す。入力された段落がすでに正しい場合、説明なしで直接返します。

MiniGPT-4のChatGPTプロンプト

この第二段階は、モデルの信頼性と使いやすさを大幅に向上させ、Nvidia A100一台でわずか7分のトレーニングを必要とした。研究者自身、自分たちのアプローチの効率性に驚いたと語っている。

MiniGPT-4 Vicuna言語モデルは「アルパカ式」に従い、ChatGPTの出力を使ってLLaMAファミリーのMeta言語モデルを微調整する。VicunaはGoogle BardやChatGPTに匹敵すると言われており、これも比較的少ないトレーニング労力で実現できる。

MiniGPT-4は、オープンソースコミュニティが短期間で急速な進歩を遂げたもう一つの例である。昨日、オープンソースのチャットボットOpenAssistantが発表され、ボランティアから収集した指導データで訓練され、いずれはChatGPTのオープンな代替になる運命にある。

この展開を考えると、オープンAIがGPT-5を今トレーニングするよりも、GPT-4用のChatGPTプラグインを使用するパートナーのエコシステムを構築することにまず注力するのは理にかなっている。OpenAIにとって、競合他社やオープンソースコミュニティに対して得られる優位性よりも、新しいモデルの研究やトレーニングの労力の方が大きいかもしれません。それに比べ、チャットのエコシステムを構築することは、より困難であり、経済的にも持続不可能である。また、ユーザーに強いロックイン効果を与える可能性もある。