大規模言語モデルにおける新たな能力は、興奮と懸念の両方を生み出してきた。現在、スタンフォード大学の研究者たちは、これらの能力は実際の現象というよりも、メトリックによって誘発された蜃気楼である可能性があることを示唆している。

OpenAIのGPT-3は、あるパラメータ数以上の単純な数学的タスクを解くことができ、Googleの研究者は、BIG-BenchのようなNLPベンチマークで137以上の創発的能力を数えた。

一般に、創発的能力(またはケイパビリティ)とは、特定のサイズ以上のモデルで突然現れ、より小さなモデルには存在しないものを指す。このような瞬間的で予測不可能な飛躍の出現は、このような能力の起源と、さらに重要なのはその予測可能性に関する広範な研究を刺激してきた。というのも、AIアライメント研究の分野では、AI能力の予期せぬ出現は、大規模なAIネットワークが何の前触れもなく予期せぬ、あるいは危険な能力を開発する可能性があるという先制的な指標と考えられているからである。

今回、スタンフォード大学の研究者たちは新しい研究論文の中で、GPT-3のようなモデルは初歩的な数学的能力を発達させるが、その測定方法を変えると、それは創発的能力ではなくなることを示した。

創発的スキルは特定の尺度の結果である

“我々は、LLMが創発的な能力を持っているという主張に疑問を投げかける。”創発的な能力とは、具体的には、特定のタスクにおけるモデル規模の関数として、モデル出力が明確かつ予測不可能に変化することを意味する。

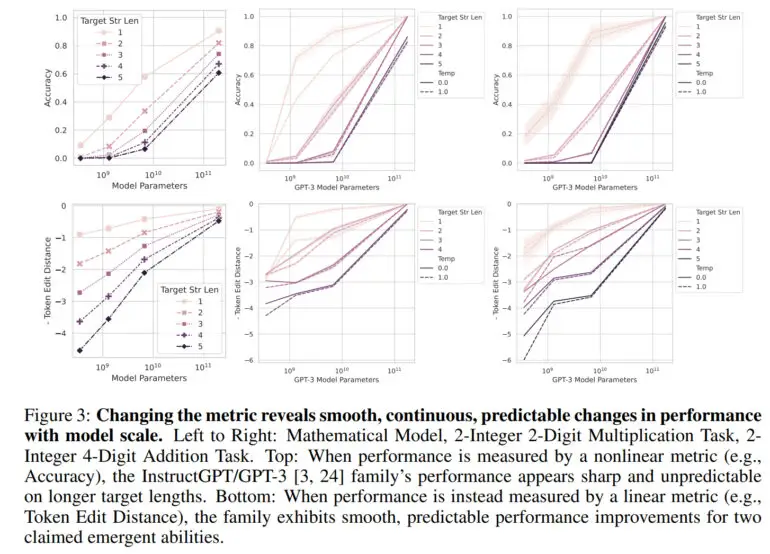

通常、大規模言語モデルの能力は、予測総数のうち正しい予測の割合である精度で測定される。この指標は線形ではないため、精度の変化はジャンプとみなされる、と研究チームは述べている。

「われわれの別の説明では、出現したスキルは、主に研究者がトークンごとのエラー率を非線形または不連続に変形させるような測定基準を選択したこと、部分的には、小規模なモデルの性能を正確に推定するにはテストデータが少なすぎること(小規模なモデルはタスクを実行する能力がまったくないように見える)、部分的には大規模なモデルを評価する数が少なすぎることによって引き起こされる蜃気楼である、と仮定している」と論文は述べている。

トークン編集距離のような線形メトリックを使用すると、目に見えるジャンプはなくなり、代わりに、パラメータの数が増えるにつれて、スムーズで連続的な予測可能な改善が観察される。

研究チームはこの研究で、GPT-3や他のモデルの能力が向上しているのは、こうした非線形メトリクスによるものであり、線形メトリクスでは劇的な飛躍は見られないことを示している。さらに研究チームは、これまで出現能力が測定されていなかったコンピューター視覚モデルでも、この効果を再現している。

創発的能力は “おそらく蜃気楼”

研究チームは、「主な結論は、固定されたタスクと固定されたモデル群に対して、研究者は、創発的スキルを生み出すためのメトリックを選択することも、創発的スキルを排除するためのメトリックを選択することもできるということです」と述べている。「このように、創発的スキルは、特定のタスクにおけるモデルファミリーの基本的な特性ではなく、研究者の選択によって生み出される可能性がある」。

しかし研究チームは、この研究が、GPT-4のような大規模言語モデルが創発的スキルを持つことはあり得ないという意味に解釈されるべきではないと強調している。”むしろ、これまで主張されてきた創発的能力は、研究者の分析によって誘発された幻影である可能性が高いというのが、われわれのメッセージである。”

アライメント研究にとって、この研究は、大規模言語モデルにおけるスキルの予測可能性を実証しているようで、良いニュースかもしれない。OpenAIもGPT-4に関する報告書で、多くのベンチマークでGPT-4の性能を正確に予測できることを示している。

しかし、チームはそれ自体が創発的なスキルである可能性を排除していないため、問題はそのようなスキルがすでに存在するかどうかだ。その候補のひとつが、「数発学習」や「文脈学習」かもしれない。この能力はGPT-3で初めて詳細に実証され、今日のラピッドエンジニアリングの基礎となっている。