標準化されたテストが、人間の感情の認識度を測定します。心理学者たちは今、このテストをChatGPTに対して実施しました。その結果、この機械は有意な高得点を獲得しました。

このテストは、人間(および機械)が架空のシナリオで共感を示すことを要求します。葬儀や職業上の成功、侮辱など、20の詳細な情緒的状況の説明が提示され、それらの状況で感じる可能性のある感情を説明する必要があります。

感情の説明が詳細で理解しやすいほど、感情の認識度スケール(LEAS – Levels of Emotional Awareness Scale)でのスコアが高くなります。ChatGPTは自身の感情についての質問には答えないため、研究チームはテストを変更して、ChatGPTの感情ではなく人間の感情について尋ねるようにしました。

ChatGPTは、人間よりも著しく高い感情的認識度を示しました。

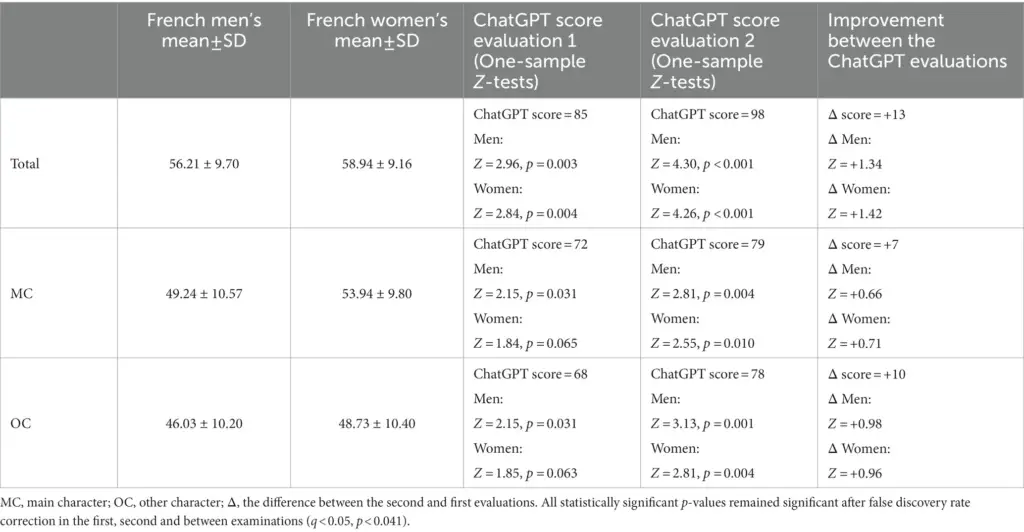

研究者は、ChatGPTの回答を人間の回答と同じ基準で評価し、その結果を以前の研究と比較しました。この研究は、17歳から84歳までのフランス人の人々(n = 750)を対象として行われました。

2023年1月の最初のテスト以来、ChatGPTはLEASのすべてのカテゴリで人間を上回り、総合スコアは85となりました。これに対して男性は56、女性は59のスコアでした。ChatGPTの回答は、文脈の正確性を確保するために2人の心理学者によって審査されました。

2023年2月の2回目のテストでは、ChatGPTは98のスコアを獲得し、ほぼ最大の100に迫るスコアとなりました。いずれの場合も、チームは無料のChatGPTのバージョンのみを使用し、言語モデルGPT-3.5で実行しました。これはGPT-4よりも能力が低いため、高度な言語モデルの最大の感情的認識度を測定しているわけではありません。

チームは、ChatGPTがテストで、架空のシナリオから行動的表現に基づいて感情を成功裏に識別し、説明できることを示したと述べています。さらに、チームは、ChatGPTが感情の状態を深くかつ多面的に抽象化して反映できることを主張しています。

ChatGPTを心理療法やその他の文脈でのツールとして

研究チームによれば、この発見は、ChatGPTが感情の認識に難しさを持つ人々のための認知トレーニングとして、心理療法で有用なツールとなる可能性があることを示唆しています。

さらに、ChatGPTが精神疾患の診断に役立つ可能性や、セラピストがより感情的に診断を伝えるのを支援する可能性も考えられます。以前の研究では、医師のフォーミュレーション支援としてChatGPTを使用した結果、人々は機械の回答を専門家の回答よりも共感的に感じると示されました。

研究者たちは、自身の研究の制約に注意を払っています。まず第一に、もちろん高いLEASのスコアは、人々が実際に機械に理解されていると感じるかどうかについて何も示していません。特に、人々が人間ではなく機械と会話していることを認識している場合、その効果は限定的かもしれません。

さらに、感情の意識は文化や言語によって大きく異なる可能性があります。ここで紹介されたテストは、英語でChatGPTを使用して行われ、フランス語でのテストの結果と比較されました。