Project Ringは言語モデルと画像モデルを組み合わせたAIウェアラブルデバイスで、カメラを通して世界を観察し、AIが生成した音声でコメントする。

Project Ringを最も簡単に説明すると、音声コントロールを備えたウェアラブル版Google Lensということになる。開発者のミナ・ファフミによると、このプロジェクトの目的は「人間とAIの間で、物理的情報とデジタル情報をミックスした摩擦の少ないインタラクションを実証する」ことだという。

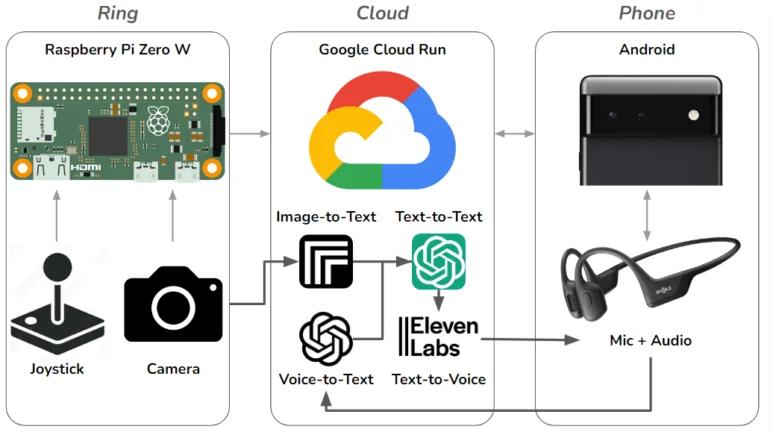

これを実現するために、ファーミはカメラとジョイスティックを備えたミニ手首コンピュータを作り、Replicateと呼ばれる画像からテキストへのモデルを使用してリアルタイムで環境を視覚的に分析し、テキストで説明し、ChatGPTを介してコメントすることができる。

テキストはイレブンラボの音声合成サービスを使って音声に変換され、Androidスマートフォンを介して骨伝導ヘッドフォンに送信される。ヘッドフォンにはマイクが内蔵されており、ユーザーは環境について質問するなど、ウェアラブルデバイスに話し返すことができる。ユーザーの声はOpenAIのWhisperを使ってテキストに変換され、ChatGPTは多かれ少なかれインテリジェントな発言で応答することができる。すべてのデータはグーグル・クラウドで処理される。

「Project Ringは、好奇心旺盛な友人を肩に乗せているような感覚を与えてくれます – あなたと同じように世界を見ていて、控えめにあなたの耳元で考えをささやく人です」とファーミは書いている。

GPT-4はウェアラブル・デバイスのコードを書いたが、「簡単ではなかった」。

ファーミは、GPT-4を使ってProject Ringのすべてのコードを生成したと主張している。言語モデルによって生成されたコードは全部で750行ほど。これには、Raspberry Pi用のPythonスクリプト、クラウドアプリケーション、ウェブサイト、Androidアプリケーションが含まれる。

ファーミはプログラミングの経験はあるが、ここ何年もコードを書いていないという。彼のプロジェクトは、GPT-4を使って完全なソフトウェア・プロトタイプをプログラムすることが、簡単ではないが可能であることを示していると信じている。

彼のプログラミング経験は、GPT-4が正しい場所に修正を加えたり、コピー&ペーストでコードを正しく組み立てたりするのに役立った。ファーミによれば、GPT-4は時々コンテキストを失い、再調整する必要があったという。また、コードも不安定で、効率的でもなく、生産に耐えうるものでもなかったという。

こうした限界にもかかわらず、AIは「比較的短期間でプログラミング作業の大部分を自動化できるかもしれない」とファーミは推測している。

ファーミはメタ社でAIとヒューマン・コンピューター・インターフェースを担当しており、以前は2019年にメタ社が買収した新興企業CTRL-Labsで働いていた。メタはCTRL-Labsの技術をベースに、脳波をリアルタイムでコンピューターへの正確なコマンドに変換できるリストバンドを開発している。