O modelo Gen-1 da Runway permite que você edite visualmente o vídeo existente usando prompts de texto.

No ano passado, a startup de edição de vídeo de IA Runway, sediada em Nova York, ajudou a lançar o Stable Diffusion, uma IA de imagem de código aberto, em parceria com a Stability AI, LMU Munich, Eleuther AI e Laion.

Agora está introduzindo um novo modelo: “Gen-1” pode transformar visualmente os vídeos existentes em novos. Uma porta de trem filmada de forma realista pode ser transformada em uma porta de trem semelhante a um desenho animado com um simples aviso de texto.

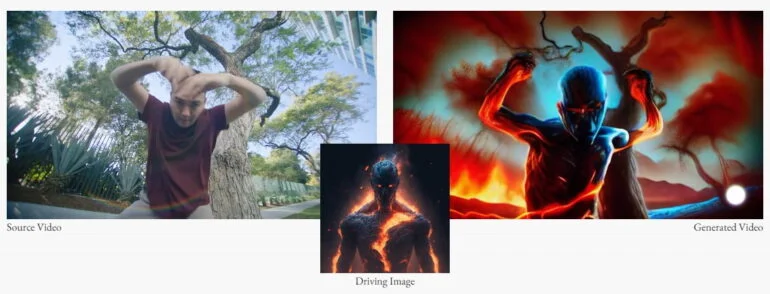

Um ator em um vídeo se torna um super-herói de desenhos animados. Sua transformação é baseada em uma imagem de entrada. O modelo pode ser refinado com suas próprias imagens para transformações melhoradas.

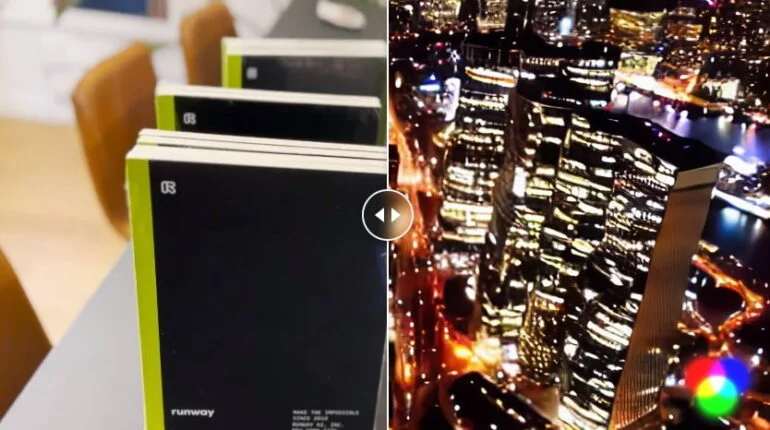

Níveis ainda mais altos de abstração são possíveis: a partir de alguns cadernos vagamente montados, a Geração 1 pode renderizar um grande cenário de arranha-céus via comando de texto. “É como filmar algo novo, sem filmar nada”, escreve Runway.

Gen-1 também pode isolar e modificar objetos em vídeo, transformando um golden retriever em um dálmata, e aplicar texturas a objetos 3D não texturizados. As texturas também são criadas usando um prompt de texto.

A Runway está esperando um desenvolvimento rápido da Gen-1

Os vídeos editados por IA ainda não podem competir com vídeos editados profissionalmente. Eles contêm erros de imagem, geometrias distorcidas ou simplesmente parecem falsos e irreais.

Mas o projeto ainda está em sua infância. “Os sistemas de IA para síntese de imagens e vídeos estão rapidamente se tornando mais precisos, realistas e controláveis”, escreve a startup.

Dado o tremendo progresso que os sistemas de IA geradores de imagens fizeram nos últimos anos, é preciso pouca imaginação para imaginar que sistemas como o Gen-1 possam desempenhar um papel importante no processamento de vídeo em alguns anos.

Não está definida a questão do código aberto

Stable Diffusion tornou-se famoso especialmente porque é de código aberto e livremente disponível na web. Para quem conhece um pouco de computadores e gosta de configurar softwares, é uma alternativa gratuita e sem censura ao DALL-E 2 ou Midjourney que também pode ser usada para aplicativos.

De acordo com Ian Sansavera, arquiteto de fluxo de trabalho de vídeo da Runway, a startup ainda não tomou uma decisão sobre a questão de código aberto para a Gen-1.

O software ainda está no “dia zero”, disse ele. As partes interessadas podem se inscrever para uma lista de espera, e o artigo científico será publicado em breve.

Mais informações podem ser encontradas na página do projeto. É provável que a Runway desenvolva o modelo principalmente para seu próprio software de vídeo.

A startup é especializada em um editor de vídeo alimentado por IA que visa simplificar e automatizar a edição de vídeo por meio de ferramentas de IA.

No outono de 2022, a startup mostrou uma integração do Stable Diffusion em seu kit de ferramentas. A Runway foi fundada no início de 2018 e, desde então, arrecadou cerca de US $ 100 milhões de investidores.

Além do Runway, o Google está trabalhando em sistemas de IA de texto para vídeo que podem editar e gerar vídeo a partir do zero. O Dreamix é especializado em edição de vídeo por meio de prompts de texto. A Meta também introduziu um modelo de texto para vídeo com Make-a-Video.