Selon une étude récente, ChatGPT surpasse la qualité et l'empathie des médecins lorsqu’ils répondent à des questions en ligne. Il y a toutefois des réserves à formuler.

Une étude récente publiée dans JAMA Internal Medicine révèle que ChatGPT surpasse les médecins en termes de qualité et d'empathie lorsqu’il s’agit de répondre à des questions en ligne. L’étude a évalué les performances de ChatGPT par rapport à celles des médecins en répondant aux questions des patients sur le forum r/AskDocs de Reddit.

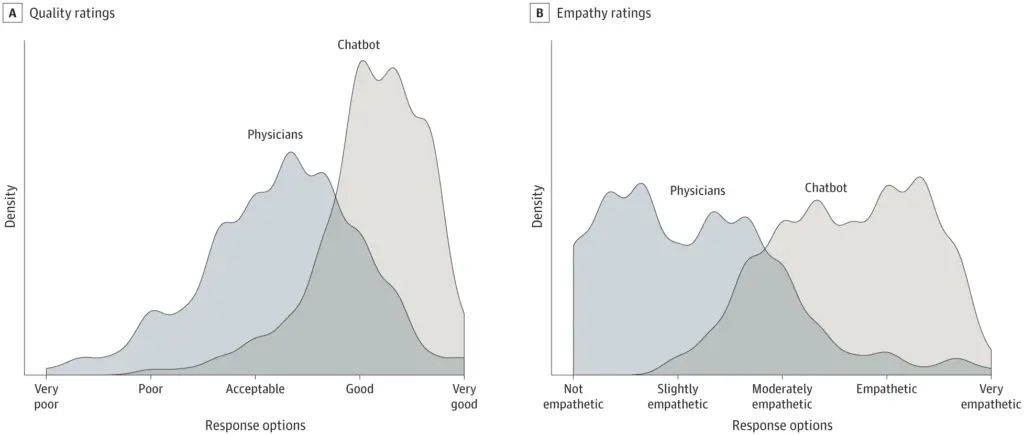

L’étude transversale a porté sur 195 questions sélectionnées au hasard et a révélé que les réponses des chatbots étaient préférées à celles des médecins. Les ChatGPT ont reçu des notes nettement plus élevées en termes de qualité et d'empathie.

L’étude a notamment utilisé GPT 3.5, une version plus ancienne, ce qui laisse penser que la mise à jour GPT-4, plus récente, pourrait donner des résultats encore meilleurs.

Des médecins assistés par des chatbots

Les chercheurs écrivent que les assistants d’IA pourraient aider à trouver des réponses aux questions des patients, ce qui pourrait être bénéfique à la fois pour les médecins et les patients. Il convient d’explorer plus avant cette technologie en milieu clinique, notamment en utilisant des robots de conversation pour rédiger des réponses que les médecins pourraient modifier. Des essais randomisés permettraient d’évaluer le potentiel des assistants d’IA pour améliorer les réponses, réduire l’épuisement des médecins et améliorer les résultats pour les patients.

Des réponses rapides et empathiques aux questions des patients peuvent réduire les visites inutiles dans les cliniques et libérer des ressources. La messagerie est également une ressource essentielle pour promouvoir l’équité entre les patients, au bénéfice des personnes dont la mobilité est limitée, qui ont des horaires de travail irréguliers ou qui craignent les factures médicales.

Malgré ces résultats prometteurs, l’étude présente des limites. L’utilisation de questions de forum en ligne peut ne pas refléter les interactions typiques entre les patients et les médecins, et la capacité du chatbot à fournir des détails personnalisés à partir des dossiers médicaux électroniques n’a pas été évaluée.

En outre, l’étude n’a pas évalué les réponses du chatbot en termes d’exactitude ou d’informations fabriquées, ce qui constitue une préoccupation majeure pour les conseils médicaux générés par l’IA. Il est parfois plus difficile de déceler une erreur que d’éviter d’en commettre une, même lorsque des humains sont présents pour l’examen final. Mais il est important de se rappeler que les humains font aussi des erreurs.

Les auteurs concluent que des recherches supplémentaires sont nécessaires pour déterminer l’impact potentiel des assistants d’IA dans les environnements cliniques. Ils insistent sur les questions éthiques, notamment la nécessité d’un examen humain du contenu généré par l’IA pour en vérifier l’exactitude et détecter d’éventuelles informations fausses ou fabriquées.

Il convient de noter que ChatGPT n’est pas spécifiquement optimisé pour les tâches médicales. Google développe Med-PaLM 2, un modèle de langage étendu amélioré à des fins médicales. Google affirme qu’il peut passer l’examen médical et prévoit de commencer les tests avec des professionnels.