Según un estudio reciente, ChatGPT supera la calidad y empatía de los médicos a la hora de responder consultas en línea. Sin embargo, hay algunas salvedades.

Un estudio reciente publicado en JAMA Internal Medicine revela que ChatGPT supera a los médicos en calidad y empatía al responder consultas en línea. El estudio evaluó el rendimiento de ChatGPT en comparación con los médicos a la hora de responder a las preguntas de los pacientes en el foro r/AskDocs de Reddit.

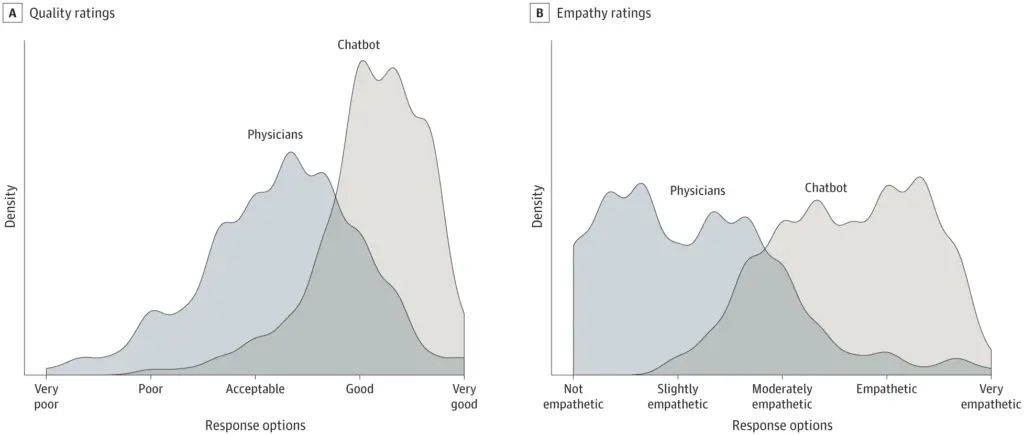

El estudio transversal incluyó 195 preguntas seleccionadas al azar y descubrió que las respuestas de los chatbots eran preferibles a las de los médicos. ChatGPT recibió puntuaciones significativamente más altas en cuanto a calidad y empatía.

Cabe destacar que el estudio utilizó GPT 3.5, que es una versión antigua, lo que sugiere que la actualización más reciente GPT-4 podría proporcionar resultados aún mejores.

Médicos asistidos por chatbots

Los investigadores escriben que los asistentes de IA podrían ayudar a idear respuestas a las preguntas de los pacientes, lo que podría beneficiar tanto a los médicos como a los pacientes. Es necesario seguir explorando esta tecnología en entornos clínicos, incluido el uso de chatbots para redactar respuestas que los médicos puedan editar. Los ensayos aleatorios podrían evaluar el potencial de los asistentes de IA para mejorar las respuestas, reducir el agotamiento de los médicos y mejorar los resultados de los pacientes.

Las respuestas rápidas y empáticas a las consultas de los pacientes pueden reducir las visitas innecesarias a las clínicas y liberar recursos. La mensajería también es un recurso fundamental para promover la equidad del paciente, beneficiando a las personas con limitaciones de movilidad, horarios de trabajo irregulares o miedo a las facturas médicas.

A pesar de los prometedores resultados, el estudio tiene limitaciones. El uso de preguntas de foros en línea puede no reflejar las interacciones típicas entre pacientes y médicos, y no se evaluó la capacidad del chatbot para proporcionar detalles personalizados a partir de historiales médicos electrónicos.

Además, el estudio no evaluó la exactitud de las respuestas del chatbot ni la falsedad de la información, que es uno de los principales problemas del asesoramiento médico generado por IA. A veces es más difícil detectar un error que evitar cometerlo, incluso cuando hay humanos en el bucle para la revisión final. Pero es importante recordar que los humanos también cometen errores».

Los autores concluyen que se necesita más investigación para determinar el impacto potencial de los asistentes de IA en entornos clínicos. Hacen hincapié en las cuestiones éticas, como la necesidad de que los contenidos generados por IA sean revisados por humanos para comprobar su exactitud y la posible existencia de información falsa o inventada.

Cabe señalar que ChatGPT no está optimizado específicamente para tareas médicas. Google está desarrollando Med-PaLM 2, un gran modelo lingüístico mejorado para fines médicos. Google afirma que puede superar el escrutinio médico y tiene previsto iniciar pruebas con profesionales.