Jusqu’à présent, l’IA avait du mal à contrôler les interfaces des smartphones. Mais les chercheurs de Google semblent avoir trouvé une solution.

Pour améliorer l’interaction vocale avec les interfaces utilisateur mobiles, les chercheurs de Google Research ont étudié l’utilisation de grands modèles de langage (LLM). Les assistants intelligents mobiles actuels ont des limites dans les interactions conversationnelles, car ils sont incapables de répondre à des questions concernant des informations spécifiques sur l’écran.

Les chercheurs ont mis au point un ensemble de techniques pour appliquer les LLM aux interfaces utilisateur mobiles, y compris un algorithme qui convertit l’interface utilisateur en texte. Ces techniques permettent aux développeurs de prototyper et de tester rapidement de nouvelles interactions basées sur la voix. Les LLM conviennent à l’apprentissage d’invites contextuelles, dans lesquelles le modèle reçoit des exemples de la tâche en question.

Les grands modèles de langage comme interface pour les smartphones

Quatre tâches clés ont été étudiées dans le cadre d’expériences approfondies. Selon les chercheurs, les résultats montrent que les LLM sont compétitifs dans ces tâches, ne nécessitant que deux exemples par tâche.

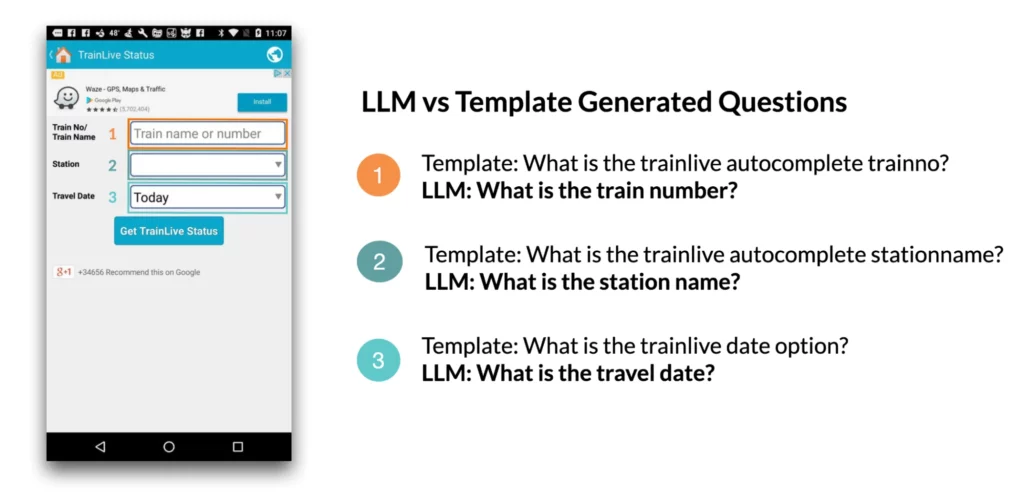

1. Générer des questions à l’écran: par exemple, lorsqu’une interface utilisateur mobile est présentée, le modèle linguistique peut générer des questions pertinentes sur les éléments de l’interface utilisateur qui requièrent une saisie de la part de l’utilisateur. Selon l’étude, les modèles de langage ont pu générer des questions avec une grammaire presque parfaite (4,98/5) qui correspondaient à 92,8 % aux champs de saisie affichés à l’écran.

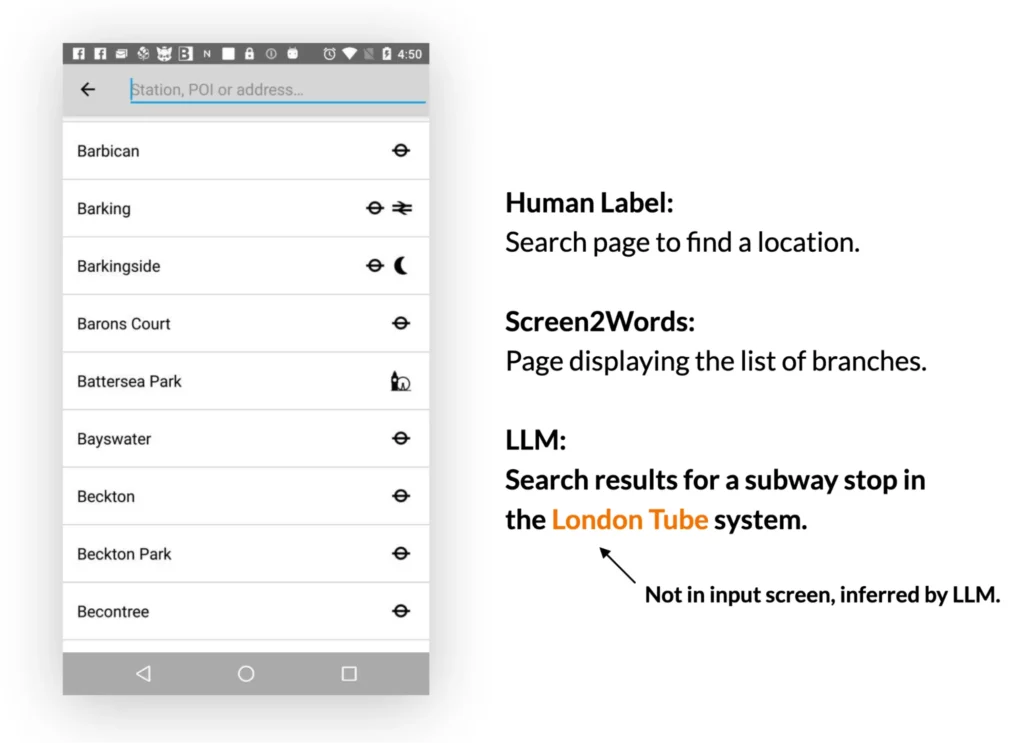

2. Résumé d’écran: les modèles linguistiques peuvent résumer efficacement les principales caractéristiques d’une interface utilisateur mobile. Ils génèrent des résumés plus précis que le modèle Screen2Words précédemment introduit et peuvent même déduire des informations qui ne sont pas directement présentées dans l’interface utilisateur.

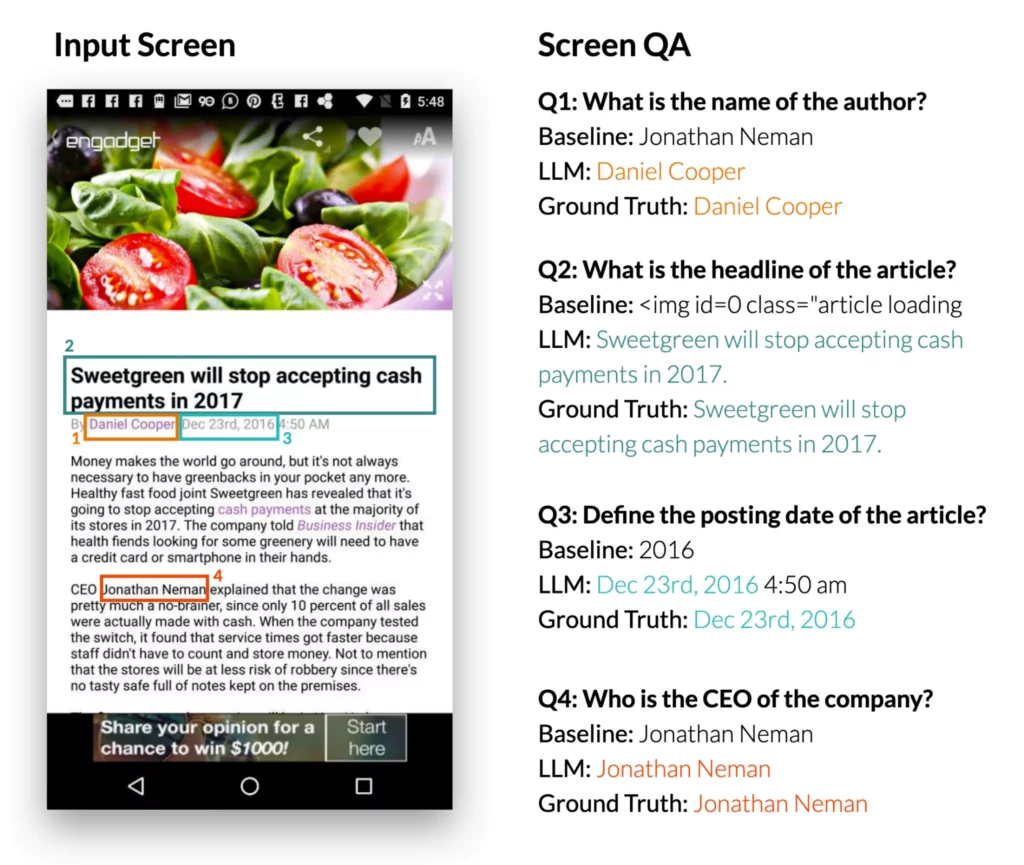

3. Réponse à des questions à l’écran: lorsqu’on leur présente une interface utilisateur mobile et une question ouverte nécessitant des informations sur l’interface, les LLM peuvent fournir la bonne réponse. L’étude montre que les LLM peuvent répondre à des questions telles que « Quel est le titre ? » Le LLM est nettement plus performant que le modèle d’assurance qualité de référence DistilBERT.

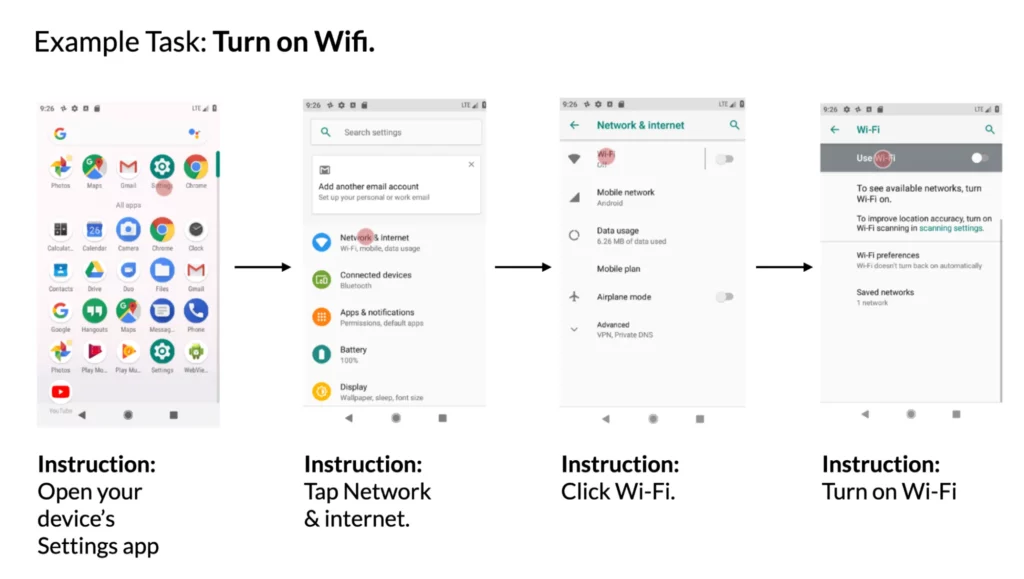

4. Associer des instructions à des actions dans l’interface utilisateur : lorsqu’on lui donne une interface utilisateur mobile et une instruction en langage naturel pour la contrôler, le modèle peut prédire l’ID de l’objet pour lequel l’action donnée doit être exécutée. Par exemple, lorsqu’on lui donne l’instruction « Ouvrir Gmail », le modèle est capable d’identifier correctement l’icône Gmail sur l’écran d’accueil.

Les chercheurs de Google concluent que le prototypage de nouvelles interactions vocales dans les interfaces utilisateur mobiles peut être simplifié par l’utilisation de LLM. Cela ouvre de nouvelles possibilités aux concepteurs, développeurs et chercheurs avant d’investir dans le développement de nouvelles bases de données et de nouveaux modèles.