Les images générées par l’IA deviennent de plus en plus réalistes, et jusqu’à présent, il n’existe pas de moyen fiable de les détecter. Les chercheurs du MIT pourraient ne pas être en mesure de changer cela, mais ils peuvent au moins protéger les images existantes contre la manipulation de l’IA.

Au lieu de tenter de détecter la manipulation, les chercheurs souhaitent rendre les images originales plus résistantes, de sorte que la manipulation soit impossible ou très difficile.

« PhotoGuard » est le nom du système qui introduit des perturbations minimales dans les pixels d’une image originale qui sont invisibles pour les humains, mais qui peuvent être détectées par les systèmes d’IA.

Ces perturbations sont conçues pour rendre la manipulation d’images beaucoup plus difficile. Le système a été développé par le Laboratoire d’informatique et d’intelligence artificielle (CSAIL) du Massachusetts Institute of Technology (MIT).

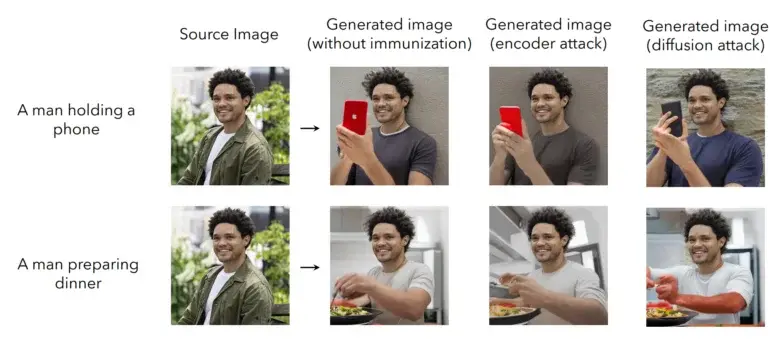

Le PhotoGuard utilise deux méthodes pour « immuniser » une image contre la manipulation par l’IA. La première méthode, appelée « attaque de l’encodeur », vise l’abstraction existante de l’image par le modèle IA dans l’espace latent et manipule les données de manière à ce que le modèle ne reconnaisse plus clairement l’image originale, introduisant ainsi des défauts. Le changement est similaire à une phrase grammaticalement incorrecte, dont le sens est toujours clair pour les humains, mais qui peut dérouter un modèle de langage.

La deuxième méthode, appelée « attaque de diffusion », est plus sophistiquée : pour une image originale, une image de destination spécifique est définie, qui est déterminée par de minuscules changements de pixels dans l’image originale pendant l’inférence. Lorsque le modèle IA tente de modifier l’image originale, il est automatiquement redirigé vers l’image de destination définie par les chercheurs, et le résultat n’a plus de sens. Regardez la vidéo ci-dessous pour voir le système en action.

Intégration de la protection contre la manipulation directement dans les modèles

Les chercheurs suggèrent que leurs protections, ou des protections similaires, pourraient être proposées directement par les développeurs de modèles. Par exemple, ils pourraient mettre à disposition un service via une API permettant d’immuniser les images contre les capacités de manipulation de leur modèle spécifique. Cette immunisation devrait également être compatible avec les modèles futurs et pourrait être incorporée en tant que porte dérobée lors de l’entraînement du modèle.

Une protection étendue contre la manipulation de l’IA exigera une approche collaborative entre les développeurs, les plateformes de médias sociaux et les décideurs politiques, qui pourraient, par exemple, exiger que les développeurs de modèles proposent également une protection, affirment les chercheurs.

Ils soulignent également que le PhotoGuard ne fournit pas une protection complète. Des attaquants pourraient essayer de manipuler l’image protégée, par exemple, en la recadrant, en ajoutant du bruit ou en la faisant pivoter. Cependant, dans l’ensemble, les chercheurs voient un potentiel pour développer des modifications robustes qui pourraient résister à de telles manipulations.