Hasta ahora, la IA ha tenido dificultades para controlar las interfaces de los smartphones. Pero los investigadores de Google parecen haber encontrado una solución.

Para mejorar la interacción por voz con las interfaces de usuario de los móviles, los investigadores de Google Research han estado investigando el uso de grandes modelos de lenguaje (LLM). Los actuales asistentes inteligentes para móviles tienen limitaciones en las interacciones conversacionales, ya que son incapaces de responder a preguntas sobre información específica de la pantalla.

Los investigadores han desarrollado un conjunto de técnicas para aplicar los LLM a las interfaces de usuario de los móviles, incluido un algoritmo que convierte la interfaz de usuario en texto. Estas técnicas permiten a los desarrolladores crear rápidamente prototipos y probar nuevas interacciones basadas en la voz. Los LLM son adecuados para el aprendizaje de indicaciones contextuales, en las que el modelo recibe algunos ejemplos de la tarea en cuestión.

Grandes modelos lingüísticos como interfaz para smartphones

Se estudiaron cuatro tareas clave en experimentos exhaustivos. Según los investigadores, los resultados muestran que los LLM son competitivos en estas tareas, ya que sólo requieren dos ejemplos por tarea.

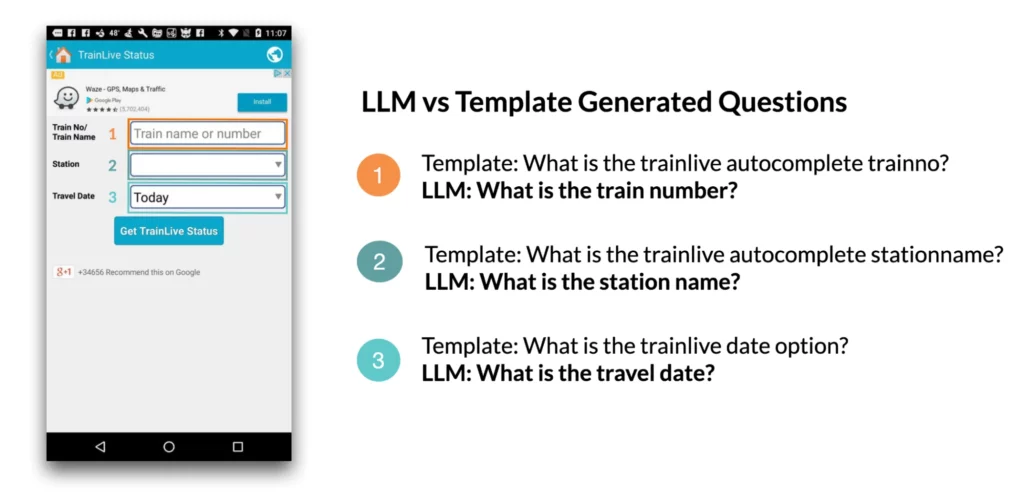

1. Generación de preguntas en pantalla: por ejemplo, cuando se presenta una interfaz de usuario (IU) de móvil, el modelo lingüístico puede generar preguntas relevantes sobre los elementos de la IU que requieren la entrada del usuario. Según el estudio, los modelos lingüísticos fueron capaces de generar preguntas con una gramática casi perfecta (4,98/5) que eran pertinentes en un 92,8 por ciento para los campos de entrada que aparecían en la pantalla.

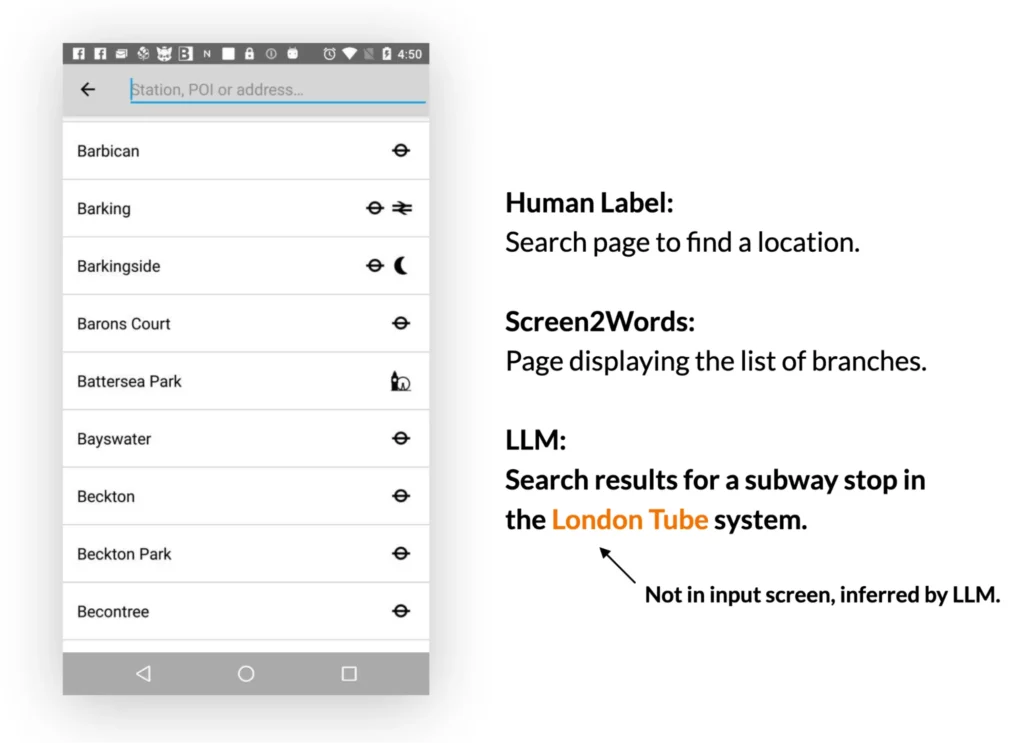

2. Resumen de pantalla: los LLM pueden resumir eficazmente las principales características de la interfaz de usuario de un móvil. Generan resúmenes más precisos que el modelo Screen2Words presentado anteriormente y pueden incluso deducir información que no se presenta directamente en la interfaz de usuario.

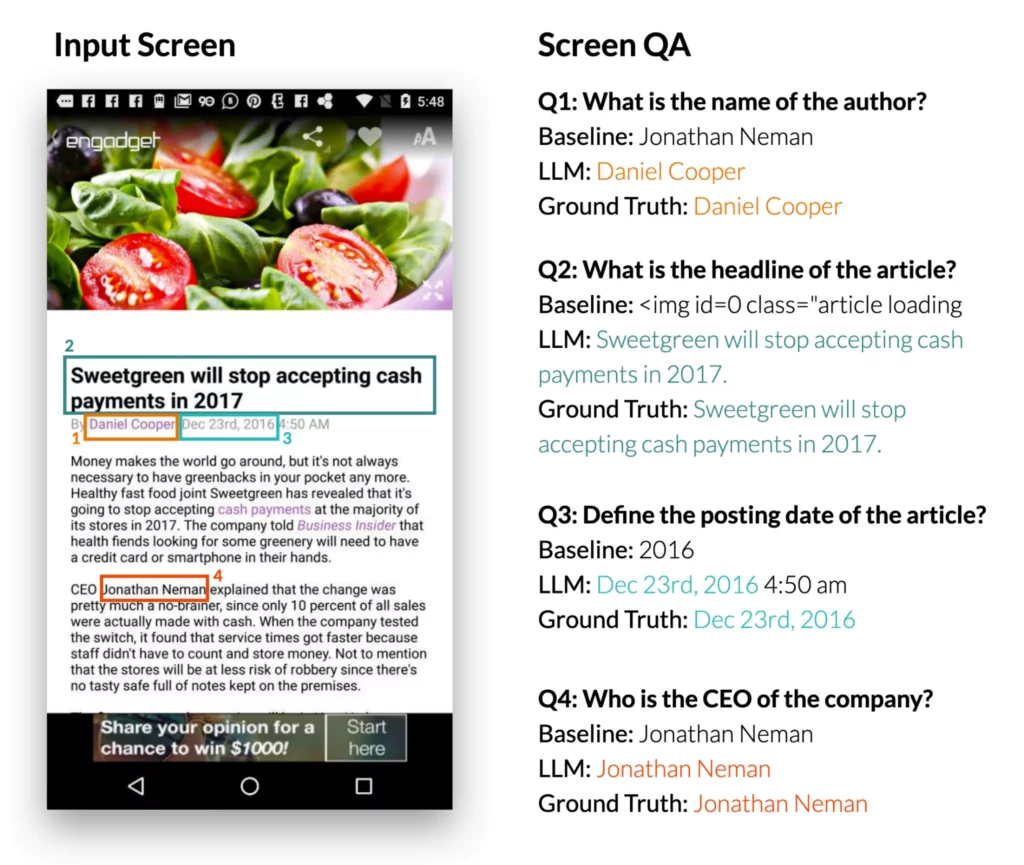

3. Respuesta a preguntas en pantalla: cuando se les presenta una interfaz de usuario de móvil y una pregunta abierta que requiere información sobre la interfaz, los LLM pueden dar la respuesta correcta. El estudio muestra que los LLM pueden responder a preguntas como «¿Cuál es el titular?» El LLM obtuvo resultados significativamente mejores que el modelo de GC de referencia DistilBERT.

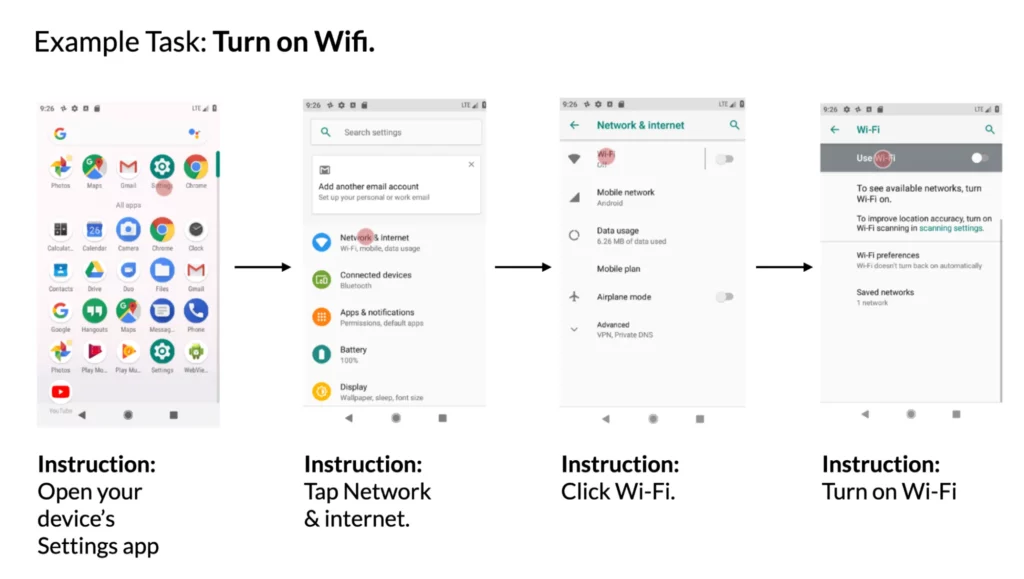

4. Asignar instrucciones a acciones en la interfaz de usuario: cuando se da una interfaz de usuario móvil y una instrucción en lenguaje natural para controlarla, el modelo puede predecir el ID del objeto para el que debe realizarse la acción dada. Por ejemplo, cuando se le da la instrucción «Abrir Gmail», el modelo es capaz de identificar correctamente el icono de Gmail en la pantalla de inicio.

Los investigadores de Google concluyen que la creación de prototipos de nuevas interacciones basadas en la voz en interfaces de usuario para móviles puede simplificarse utilizando LLM. Esto abre nuevas posibilidades a diseñadores, desarrolladores e investigadores antes de invertir en el desarrollo de nuevas bases de datos y modelos.