Con un nuevo conjunto de datos, Deepmind se ha asociado con muchas otras instituciones para colmar la laguna de datos en el entrenamiento de robots y permitir la generalización de sus capacidades en todos los tipos de robots. Los primeros resultados son prometedores.

Google Deepmind, en colaboración con 33 laboratorios académicos, ha lanzado un nuevo conjunto de datos y modelos diseñados para promover el aprendizaje generalizado en robótica a través de diferentes tipos de robots.

Los datos proceden de 22 tipos diferentes de robots. El objetivo es desarrollar modelos de robots que puedan generalizar mejor sus capacidades entre distintos tipos de robots.

Hacia un robot de uso general

Hasta ahora había que entrenar un modelo de robot distinto para cada tarea, cada robot y cada entorno. Esto requiere mucha recopilación de datos. Además, según Deepmind, el más mínimo cambio en una variable obligaba a volver a empezar el proceso.

El objetivo de la iniciativa Open-X es encontrar una forma de reunir conocimientos sobre distintos robots (corporaciones) y entrenar a un robot universal. Esta idea condujo al desarrollo del conjunto de datos Open-X embodiment y de RT-1-X, un modelo de robot transformador derivado de RT-1 (Robotic Transformer-1) y entrenado con el nuevo conjunto de datos.

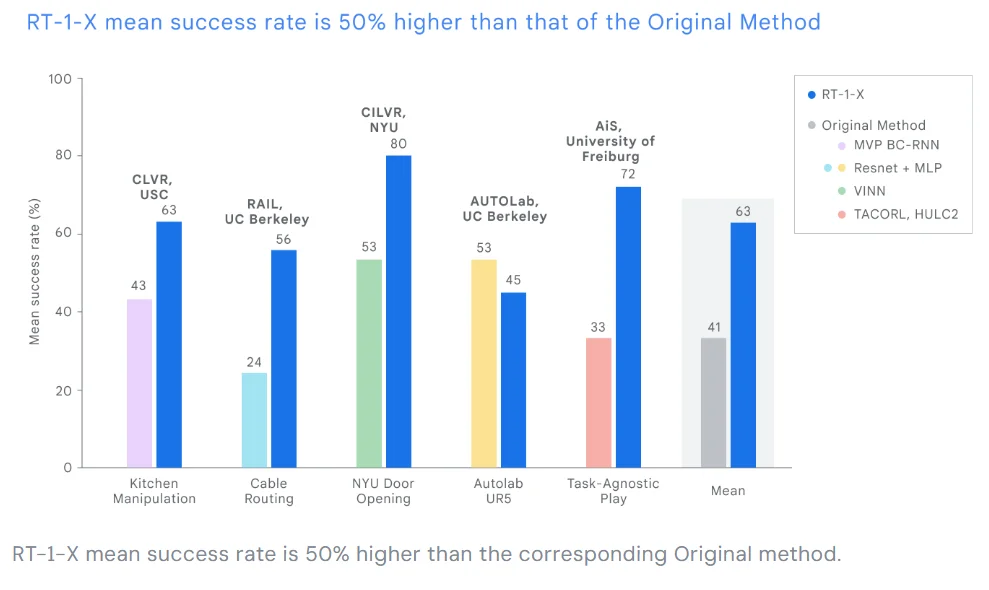

Las pruebas realizadas en cinco laboratorios de investigación diferentes mostraron un aumento medio del 50% en el éxito de la finalización de tareas cuando el RT-1-X tomó el control de cinco robots comunes en comparación con los modelos de control específicos para cada robot.

Un conjunto de datos para entrenar robots de uso general

El conjunto de datos Open X Embodiment se desarrolló en colaboración con laboratorios de investigación académica de más de 20 instituciones. Agrega datos de 22 robots que representan más de 500 capacidades y 150.000 tareas en más de un millón de flujos de trabajo.

Según Deepmind, el conjunto de datos es una herramienta importante para entrenar un modelo generalista capaz de controlar muchos tipos de robots, interpretar distintas instrucciones, hacer inferencias básicas sobre tareas complejas y generalizar con eficacia.

Capacidades emergentes en el modelo de robot

La versión RT-2 del modelo de acción de lenguaje visual RT-2-X, presentada este verano, triplicó sus capacidades como posible robot del mundo real tras ser entrenada con el conjunto de datos Open-X. Los experimentos demostraron que el coentrenamiento con datos de otras plataformas proporcionaba al RT-2-X capacidades adicionales no presentes en el conjunto de datos RT-2 original.

El modelo RT-2 utiliza grandes modelos lingüísticos para razonar y como base de sus acciones. Por ejemplo, puede razonar por qué una piedra es mejor martillo improvisado que un trozo de papel, y aplicar esta capacidad a distintos escenarios de aplicación.

Tras entrenarse con el conjunto de datos X, fue capaz de mejorar estas capacidades. Por ejemplo, RT-2-X mostró una mejor comprensión de las relaciones espaciales entre objetos, siendo capaz de distinguir gradaciones finas como «pon la manzana sobre la tela» o «pon la manzana cerca de la tela».

El RT-2-X demuestra que el entrenamiento con datos de otros robots también puede mejorar robots ya capaces que han sido entrenados con muchos datos, escribe Deepmind.

La conclusión del equipo de investigación es similar: el aumento de las capacidades de los robots utilizando datos de distintos tipos de robots funciona, afirman, y produce «mejoras espectaculares en el rendimiento». Futuras investigaciones podrían analizar cómo los modelos robóticos pueden aprender mejor de la experiencia para mejorarse a sí mismos.