La cronología de la inteligencia artificial nos lleva en un fascinante viaje a través de la evolución de este campo extraordinario. Desde sus humildes comienzos hasta nuestros días, la IA ha cautivado la mente de los científicos y ha despertado posibilidades infinitas.

Todo comenzó a mediados del siglo XX, cuando visionarios pioneros se sumergieron en el concepto de crear máquinas capaces de simular la inteligencia humana. Su trabajo innovador preparó el escenario para el nacimiento de la inteligencia artificial.

En los últimos años, la IA se ha convertido en parte integral de nuestras vidas. Ahora tiene la capacidad de comprender el lenguaje humano, reconocer objetos y hacer predicciones. Sus aplicaciones abarcan diversos campos, desde la salud hasta el transporte, transformando la forma en que vivimos y trabajamos.

Acompáñanos en este emocionante viaje a través de la línea de tiempo de la inteligencia artificial.

Comprender la línea de tiempo de la inteligencia artificial implica abrazar la tecnología de hoy y del mañana.

¿Dónde comienza la línea de tiempo de la inteligencia artificial?

La línea de tiempo de la inteligencia artificial comienza desde la década de 1940. Sin embargo, algunos expertos argumentan que el propio término puede ser engañoso, ya que la tecnología de IA aún está lejos de alcanzar una verdadera inteligencia similar a la humana. No ha llegado a un punto en el que pueda igualar los notables logros de la humanidad. Para desarrollar una IA «fuerte», que hasta ahora solo existe en la ficción científica, se requeriría un progreso significativo en la ciencia fundamental para crear un modelo completo del mundo.

Sin embargo, a partir de aproximadamente 2010, ha habido un renovado interés en este campo. Esto se debe principalmente a los notables avances en el poder de procesamiento de las computadoras y la disponibilidad de vastas cantidades de datos. En medio de toda esta emoción, es importante abordar el tema con una perspectiva objetiva, ya que han surgido promesas exageradas y preocupaciones infundadas que ocasionalmente se infiltran en las discusiones.

En nuestra opinión, sería útil revisar brevemente la línea de tiempo de la inteligencia artificial como forma de proporcionar contexto para los debates en curso. Comencemos con las ideas que son la base de la IA, que se remontan a tiempos antiguos.

Tiempos antiguos

La base de la IA actual se puede rastrear hasta los tiempos antiguos, cuando pensadores y filósofos establecieron los fundamentos de los conceptos que sustentan este campo. Aunque los avances tecnológicos que vemos hoy no estaban presentes en aquellas épocas, las semillas de la IA fueron sembradas a través de reflexiones filosóficas y exploraciones teóricas.

Es posible encontrar indicios de ideas relacionadas con la IA en civilizaciones antiguas, como Grecia, Egipto y China. Por ejemplo, en la antigua mitología griega, existen historias sobre autómatas, que eran seres mecánicos capaces de realizar tareas e incluso mostrar inteligencia. Estas historias reflejaban las primeras nociones de creación de vida artificial, aunque en un contexto mítico.

La línea del tiempo de la inteligencia artificial puede rastrearse hasta los tiempos antiguos

En la antigua China, el concepto del «autómata de Yan Shi» se cita con frecuencia como un precursor temprano del desarrollo de la inteligencia artificial. Se dice que Yan Shi, un ingeniero e inventor del siglo III a.C., creó una figura mecánica capaz de imitar movimientos humanos y responder a estímulos externos. Esto puede verse como un intento inicial de replicar comportamientos similares a los humanos mediante medios artificiales.

Además, antiguos filósofos como Aristóteles reflexionaron sobre la naturaleza del pensamiento y el razonamiento, sentando las bases para el estudio de la cognición, que es un aspecto crucial de la investigación en inteligencia artificial en la actualidad. Las ideas de Aristóteles sobre lógica y racionalidad han influido en el desarrollo de algoritmos y sistemas de razonamiento en la IA moderna, creando los fundamentos de la línea del tiempo de la inteligencia artificial.

El nacimiento de la IA

Entre 1940 y 1960, una convergencia de avances tecnológicos y la exploración de la combinación de funciones mecánicas y orgánicas tuvieron un impacto profundo en el desarrollo de la inteligencia artificial (IA).

Norbert Wiener, una figura pionera en la cibernética, reconoció la importancia de integrar la teoría matemática, la electrónica y la automatización para crear una teoría integral de control y comunicación tanto en animales como en máquinas. Basándose en estos fundamentos, Warren McCulloch y Walter Pitts formularon el primer modelo matemático y computacional de la neurona biológica en 1943. Aunque inicialmente no acuñaron el término «inteligencia artificial», John Von Neumann y Alan Turing desempeñaron roles cruciales en las tecnologías subyacentes. Facilitaron la transición de las computadoras de la lógica decimal del siglo XIX a la lógica binaria, codificando la arquitectura de las computadoras modernas y demostrando sus capacidades universales para ejecutar tareas programadas.

Turing, en particular, introdujo el concepto de un «juego de imitación» en su renombrado artículo de 1950 «Computing Machinery and Intelligence», en el que exploró si una persona podría distinguir entre conversar con un humano o una máquina a través de comunicación por teletipo, dejando una marca significativa en la línea de tiempo de la inteligencia artificial. Este trabajo seminal generó discusiones sobre la definición de los límites entre humanos y máquinas.

John McCarthy del MIT recibe el crédito por acuñar el término «IA».

El crédito por acuñar el término «IA» se atribuye a John McCarthy del MIT. Marvin Minsky ofrece una definición de IA como el desarrollo de programas de computadora que realizan tareas que actualmente dependen de procesos mentales de alto nivel, como el aprendizaje perceptual, la organización de la memoria y el razonamiento crítico. La disciplina comenzó a tomar forma oficialmente en un simposio celebrado en el Dartmouth College en el verano de 1956, en el cual un taller desempeñó un papel central y contó con las contribuciones continuas de McCarthy, Minsky y otros cuatro participantes.

A principios de la década de 1960, hubo un declive en el entusiasmo en torno a la IA, a pesar de sus promesas y la emoción continua. La capacidad de memoria limitada de las computadoras presentaba desafíos para el uso efectivo de lenguajes de programación. Sin embargo, incluso durante ese período, se establecieron fundamentos significativos.

Por ejemplo, surgió el lenguaje de procesamiento de información (IPL), lo que permitió el desarrollo de programas como la Máquina Teórica de Lógica (LTM) en 1956. La LTM tenía como objetivo demostrar teoremas matemáticos e introdujo conceptos como árboles de solución que siguen siendo relevantes en la IA actualmente.

La era de oro de la IA

La película «2001: Una odisea del espacio», dirigida por Stanley Kubrick y estrenada en 1968, presentó al público un ordenador llamado HAL 9000, que encapsulaba las preocupaciones éticas en torno a la inteligencia artificial. La película planteó cuestiones sobre si la IA sería altamente sofisticada y beneficiosa para la humanidad o representaría un peligro potencial.

Aunque la influencia de la película no está arraigada en la precisión científica, contribuyó a aumentar la conciencia sobre estos temas, al igual que el autor de ciencia ficción Philip K. Dick, quien reflexionaba constantemente sobre si las máquinas podrían experimentar emociones.

A finales de la década de 1970, se introdujeron los primeros microprocesadores, coincidiendo con un resurgimiento del interés en la IA. Los sistemas expertos, que buscaban replicar el razonamiento humano, alcanzaron su apogeo en esa época. La Universidad de Stanford presentó MYCIN en 1972, mientras que el MIT introdujo DENDRAL en 1965. Estos sistemas dependían de un «motor de inferencia» que proporcionaba respuestas lógicas y fundamentadas cuando se les proporcionaba información relevante.

La victoria del Deep Blue sobre Kasparov marca un hito significativo en la línea de tiempo de la inteligencia artificial.

Prometiendo avances significativos, estos sistemas enfrentaron desafíos hasta finales de la década de 1980 o principios de la década de 1990. Implementar y mantener sistemas tan complejos resultó ser laborioso, con un efecto de «caja negra» que oscurecía la lógica subyacente de la máquina al tratar con cientos de reglas. En consecuencia, la creación y el mantenimiento de estos sistemas se volvieron cada vez más difíciles, especialmente cuando surgieron alternativas más accesibles y eficientes. Cabe destacar que durante la década de 1990, el término «inteligencia artificial» perdió prominencia en el discurso académico, dando paso a términos más moderados como «computación avanzada».

En mayo de 1997, el supercomputador Deep Blue de IBM logró un hito significativo al derrotar al campeón de ajedrez Garry Kasparov. A pesar de la capacidad limitada de Deep Blue para analizar solo una pequeña parte de la complejidad del juego, la derrota de un ser humano por una máquina se mantuvo como un evento simbólicamente significativo en la historia.

Es importante reconocer que, aunque «2001: Una odisea del espacio» y la victoria de Deep Blue no impulsaron directamente la financiación y el avance de la IA, contribuyeron al diálogo cultural más amplio en torno al potencial de la IA y sus implicaciones para la humanidad, acelerando la línea de tiempo de la inteligencia artificial.

Tiempo moderno

Las tecnologías de IA ganaron gran atención después de la victoria del Deep Blue sobre Garry Kasparov, alcanzando su punto máximo alrededor de la mitad de la década de 2010.

Dos factores clave contribuyeron al nuevo auge en el campo alrededor de 2010:

- Acceso a grandes cantidades de datos: La disponibilidad de enormes conjuntos de datos se volvió crucial para los avances en IA. La abundancia de datos permitió que los algoritmos aprendieran y realizaran predicciones basadas en información extensa.

- Descubrimiento de procesadores de tarjetas gráficas altamente eficientes: La percepción de que los procesadores de tarjetas gráficas podrían ejecutar algoritmos de IA con una eficiencia excepcional impulsó aún más el progreso en el campo. Este descubrimiento permitió cálculos más rápidos y potentes, impulsando la investigación en IA.

Un logro notable durante este período fue el sistema de IA de IBM, Watson, que derrotó a dos campeones en el programa de televisión Jeopardy en 2011. Otro hito significativo ocurrió en 2012, cuando la IA de Google X identificó con éxito gatos en videos utilizando más de 16,000 procesadores. Esto demostró el impresionante potencial de las máquinas para aprender y diferenciar entre varios objetos.

En 2016, la IA AlphaGo de Google derrotó a Lee Sedol y Fan Hui, los campeones europeo y mundial en el juego de Go. Esta victoria representó un cambio radical con respecto a los sistemas expertos y destacó la transición hacia el aprendizaje inductivo.

¿Y la mejor parte? Puedes verlo con tus propios ojos en el siguiente video, gracias al canal de YouTube de Google DeepMind.

En lugar de codificar reglas manualmente, como en los sistemas expertos, el enfoque cambió para permitir que las computadoras descubran patrones y correlaciones de forma independiente a través del análisis de datos a gran escala.

El aprendizaje profundo (deep learning) surgió como una tecnología altamente prometedora de aprendizaje automático para diversas aplicaciones. Investigadores como Geoffrey Hinton, Yoshua Bengio y Yann LeCun iniciaron un programa de investigación en 2003 para revolucionar las redes neuronales. Sus experimentos, realizados en instituciones como Microsoft, Google e IBM, demostraron el éxito del aprendizaje profundo al reducir significativamente las tasas de error en tareas de reconocimiento de voz e imagen.

La adopción del aprendizaje profundo por parte de los equipos de investigación aumentó rápidamente debido a sus ventajas innegables. Aunque ha habido avances significativos en el reconocimiento de texto, expertos como Yann LeCun reconocen que todavía hay un largo camino por recorrer antes de crear sistemas de comprensión de texto.

Un desafío importante radica en el desarrollo de agentes de conversación. Aunque nuestros teléfonos inteligentes pueden transcribir instrucciones con precisión, todavía tienen dificultades para contextualizar adecuadamente la información o discernir nuestras intenciones, lo que destaca la complejidad de la comprensión del lenguaje natural.

¿Cuáles son las tendencias y desarrollos actuales en IA?

La línea de tiempo de la inteligencia artificial nunca tendrá un final, ya que el campo de la IA está en constante evolución y varias tendencias y desarrollos clave están moldeando su panorama actual.

Aprendizaje automático

El aprendizaje automático es una rama de la inteligencia artificial (IA) que se centra en capacitar a las máquinas para que aprendan y mejoren basándose en experiencias, sin ser programadas explícitamente. En lugar de seguir instrucciones rígidas, los algoritmos de aprendizaje automático analizan datos, identifican patrones y realizan predicciones o decisiones basadas en ese análisis.

Al aprender a partir de grandes cantidades de datos, las máquinas pueden adaptarse automáticamente y mejorar su rendimiento con el tiempo.

Aprendizaje profundo

El aprendizaje profundo, impulsado por redes neuronales con múltiples capas, sigue impulsando avances en IA. Los investigadores están explorando arquitecturas como las redes neuronales convolucionales (CNN) para el procesamiento de imágenes y videos, y las redes neuronales recurrentes (RNN) para el análisis de datos secuenciales.

Técnicas como el aprendizaje transferido, las redes generativas adversarias (GAN) y el aprendizaje por refuerzo también están recibiendo atención.

Big data

Big data, una de las cosas más importantes que la línea de tiempo de la inteligencia artificial trae a tu negocio, se refiere a las vastas cantidades de datos estructurados y no estructurados que son demasiado grandes y complejos para procesar de manera efectiva utilizando métodos tradicionales de procesamiento de datos. El big data abarca datos de diversas fuentes, como redes sociales, sensores, transacciones y más. El desafío con el big data radica en su volumen, velocidad y variedad.

El análisis avanzado y las técnicas de IA, incluido el aprendizaje automático, se emplean para extraer información valiosa, patrones y tendencias de estos datos, lo que permite a las organizaciones tomar decisiones basadas en datos y obtener una ventaja competitiva.

La línea de tiempo de la inteligencia artificial nos ha llevado a un futuro en el que la IA se ha convertido en una parte integral de nuestras vidas.

Chatbots

Quizás el mayor regalo de la línea de tiempo de la inteligencia artificial sean los chatbots. Son programas de computadora impulsados por IA diseñados para simular conversaciones humanas y brindar experiencias interactivas a los usuarios. Utilizan técnicas de procesamiento de lenguaje natural (PLN) para comprender e interpretar las entradas de los usuarios, responder con información relevante y realizar tareas o brindar asistencia.

Los chatbots pueden integrarse en plataformas de mensajería, sitios web o aplicaciones, y pueden manejar una amplia gama de consultas, proporcionar recomendaciones, facilitar transacciones y ofrecer soporte al cliente, entre otras funciones.

Robótica

La robótica de IA combina inteligencia artificial con robótica para crear máquinas inteligentes capaces de realizar tareas de forma autónoma o con intervención humana mínima. Los robots impulsados por IA están equipados con sensores, sistemas de percepción y algoritmos de toma de decisiones para percibir e interactuar con su entorno.

Pueden analizar datos sensoriales, tomar decisiones y ejecutar acciones en consecuencia. La robótica de IA encuentra aplicaciones en áreas como la automatización industrial, la salud, la agricultura y la exploración, permitiendo que los robots realicen tareas complejas, mejoren la productividad y asistan a los seres humanos en diversos ámbitos.

Procesamiento de lenguaje natural

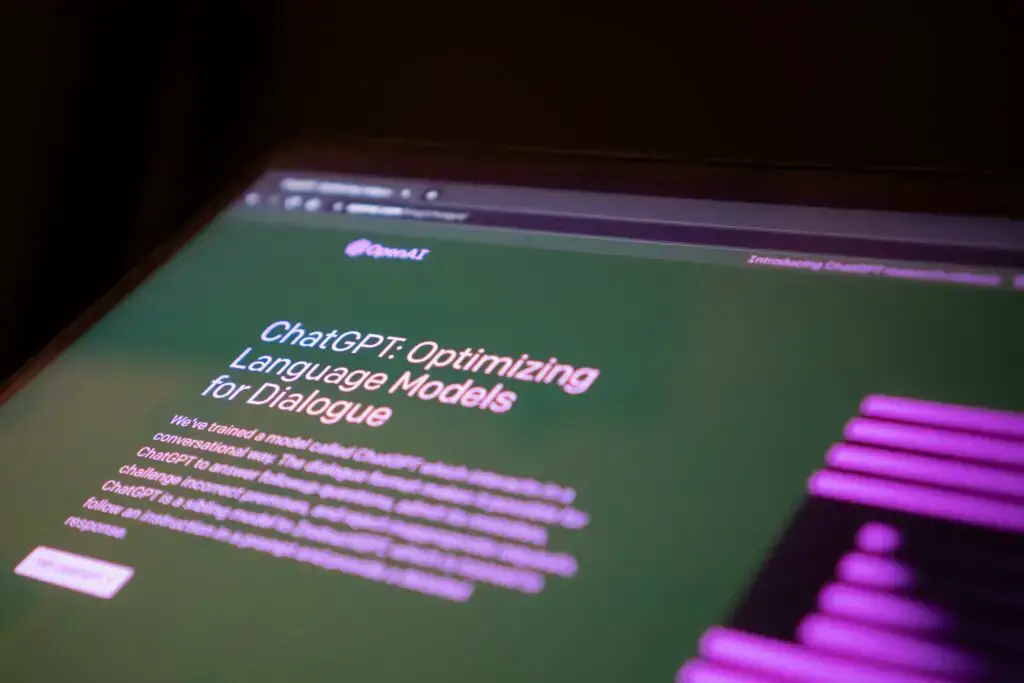

El PLN es un área en rápido avance de la IA, enfocada en capacitar a las máquinas para comprender, interpretar y generar lenguaje humano. Modelos de lenguaje como el GPT-3 de OpenAI han demostrado habilidades impresionantes en tareas como generación de texto, traducción, preguntas y respuestas y análisis de sentimientos.

El PLN se está aplicando en diversos campos, incluyendo soporte al cliente, asistentes virtuales y generación de contenido.

Al llegar al final de esta cautivadora línea de tiempo de la inteligencia artificial, nos maravillamos con el increíble viaje que ha recorrido. Desde sus humildes comienzos hasta el presente, la IA ha evolucionado, se ha transformado y ha desafiado nuestras percepciones.

Estamos en la primera era de la línea de tiempo de la inteligencia artificial.

A lo largo de la línea de tiempo de la inteligencia artificial, hemos sido testigos de los sueños de visionarios que se atrevieron a imaginar máquinas capaces de pensar como seres humanos. Admiramos el trabajo pionero de mentes brillantes que sentaron las bases para este campo extraordinario. Hemos experimentado altibajos, contratiempos y triunfos que han moldeado la trayectoria de la IA.

Hoy en día, la IA es un testimonio de la ingeniosidad y curiosidad humana. Se ha convertido en una parte integral de nuestras vidas, revolucionando industrias, impulsando innovaciones y abriendo puertas a posibilidades infinitas.

Pero la línea de tiempo de la inteligencia artificial no termina aquí. Lleva consigo una sensación de anticipación, como si susurrara sobre las maravillas que nos esperan en el futuro. Al adentrarnos en territorio desconocido, nos embarcamos en un viaje de descubrimiento donde el potencial de la IA no conoce límites.

Con contenido de Dataeconomy.