De acordo com um estudo recente, o ChatGPT supera a qualidade e a empatia dos médicos ao responder a consultas on-line. No entanto, existem algumas ressalvas.

Um estudo recente publicado no JAMA Internal Medicine revela que o ChatGPT supera os médicos em termos de qualidade e empatia ao responder a consultas on-line. O estudo avaliou o desempenho do ChatGPT em comparação com os médicos em responder às perguntas dos pacientes do fórum r/AskDocs do Reddit.

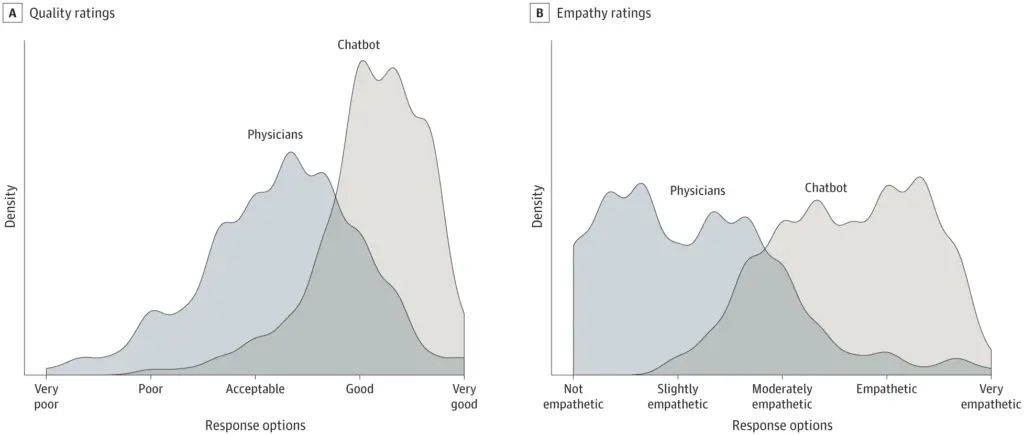

O estudo transversal envolveu 195 perguntas selecionadas aleatoriamente e descobriu que as respostas dos chatbots eram preferidas às respostas dos médicos. O ChatGPT recebeu classificações significativamente mais altas para qualidade e empatia.

Notavelmente, o estudo usou o GPT 3.5, que é uma versão mais antiga, sugerindo que a atualização mais recente do GPT-4 poderia fornecer resultados ainda melhores.

Médicos assistidos por chatbots

Os pesquisadores escrevem que os assistentes de IA poderiam ajudar a elaborar respostas às perguntas dos pacientes, potencialmente beneficiando médicos e pacientes. É necessária uma exploração mais aprofundada dessa tecnologia em ambientes clínicos, incluindo o uso de chatbots para elaborar respostas para os médicos editarem. Ensaios randomizados podem avaliar o potencial dos assistentes de IA para melhorar as respostas, reduzir o esgotamento do médico e melhorar os resultados dos pacientes.

Respostas rápidas e empáticas às consultas dos pacientes podem reduzir as visitas clínicas desnecessárias e liberar recursos. As mensagens também são um recurso crítico para promover a equidade do paciente, beneficiando indivíduos com limitações de mobilidade, horários de trabalho irregulares ou medo de contas médicas.

Apesar dos resultados promissores, o estudo apresenta limitações. O uso de perguntas do fórum on-line pode não refletir as interações típicas entre pacientes e médicos, e a capacidade do chatbot de fornecer detalhes personalizados dos registros eletrônicos de saúde não foi avaliada.

Além disso, o estudo não avaliou as respostas do chatbot quanto à precisão ou informações fabricadas, o que é uma grande preocupação com o aconselhamento médico gerado pela IA. Às vezes é mais difícil pegar um erro do que evitar cometer um, mesmo quando os humanos estão no circuito para a revisão final. Mas é importante lembrar que os humanos também cometem erros.

Os autores concluem que mais pesquisas são necessárias para determinar o impacto potencial dos assistentes de IA em ambientes clínicos. Eles enfatizam a abordagem de preocupações éticas, incluindo a necessidade de revisão humana de conteúdo gerado por IA para precisão e possíveis informações falsas ou fabricadas.

Vale a pena notar que o ChatGPT não é especificamente otimizado para tarefas médicas. O Google está desenvolvendo o Med-PaLM 2, um grande modelo de linguagem aperfeiçoado para fins médicos. O Google afirma que pode passar por exames médicos e planeja iniciar testes com profissionais.