Depois do Alpaca vem o Vicuna, um chatbot de código aberto que, de acordo com seus desenvolvedores, está ainda mais próximo do desempenho do ChatGPT.

A Vicuna segue a “fórmula da alpaca” e usa a saída do ChatGPT para ajustar um grande modelo de linguagem da família Metas LLaMA. A equipe por trás do Vicuna inclui pesquisadores da UC Berkeley, CMU, Stanford e UC San Diego.

Enquanto a Alpaca e outros modelos inspirados nela são baseados na versão de 7 bilhões de parâmetros do LLaMA, a equipe por trás do Vicuna usa a variante maior de 13 bilhões de parâmetros.

Para o ajuste fino, a equipe usa 70.000 conversas compartilhadas por usuários na plataforma ShareGPT usando o ChatGPT da OpenAI.

Treinamento da Vicuna custa metade do da Alpaca

O custo de Vicuna foi de cerca de US $ 300 – metade do custo de Alpaca, apesar de ser quase o dobro do tamanho. O motivo: os dados do ShareGPT raspados estão disponíveis gratuitamente, enquanto Stanford gerou seus próprios dados por meio da API OpenAI. Portanto, a Vicuna tem apenas custos de treinamento. Como o modelo de Stanford, Vicuna é liberado apenas para uso não comercial.

Em testes com perguntas de benchmark, Vicuna mostra respostas significativamente mais detalhadas e melhor estruturadas do que Alpaca após ajuste fino com dados ShareGPT. Eles estão em um nível comparável com o ChatGPT, escreve a equipe.

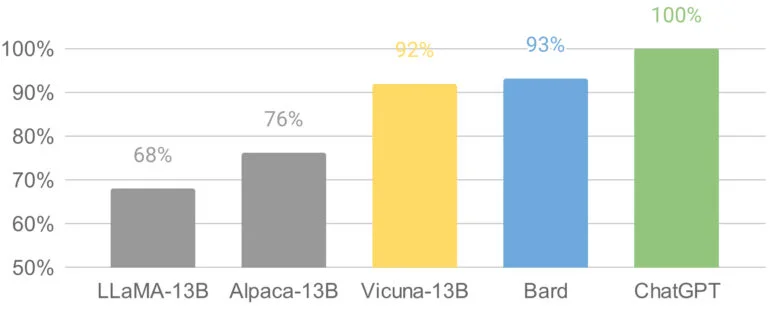

Para avaliar melhor o desempenho de seu chatbot, a equipe está usando o GPT-4, o modelo mais recente da OpenAI, que é capaz de fornecer classificações consistentes e pontuações detalhadas ao comparar diferentes chatbots.

A equipe coloca o GPT-4 contra uma versão de 13 bilhões de parâmetros do Alpaca, o modelo LLaMA original da Meta, o Bard do Google e o ChatGPT. O GPT-4 mostra o ChatGPT no topo, Vicuna e Bard quase empatados, Alpaca e LLaMA muito atrás. No entanto, o benchmark GPT-4 é “não-científico” e é necessária uma avaliação mais aprofundada, disse a equipe.

O modelo Vicuna está disponível para uso não comercial

Vicuna tem conhecido problemas como fraquezas no raciocínio e na matemática e produz alucinações. Para a demonstração publicada, a equipe também conta com a API de moderação do OpenAI para filtrar a saída inadequada. “No entanto, prevemos que a Vicuna possa servir como um ponto de partida aberto para futuras pesquisas para enfrentar essas limitações”.

Com seu primeiro lançamento, a equipe lançou código relevante, como para treinamento. Desde então, também lançou os pesos do modelo Vicuna-13B, embora estes exijam um modelo LLaMA-13B existente.

Aqueles que querem experimentar Vicuna podem fazê-lo através desta demonstração.