“O número de incidentes relacionados ao uso indevido da IA está aumentando rapidamente”. Esta é uma das principais declarações que podem ser lidas no Relatório de Índice de Inteligência Artificial 2023.

O trabalho de 400 páginas deste ano é considerado um dos relatórios mais confiáveis sobre o status quo da inteligência artificial e está agora em seu sexto ano de publicação pela Universidade de Stanford.

Os autores não mencionaram a palavra “deepfake” uma vez em seu primeiro relatório em 2017, mas mencionaram 21 vezes no relatório deste ano. Eles dedicam um capítulo inteiro à “ética técnica da IA”.

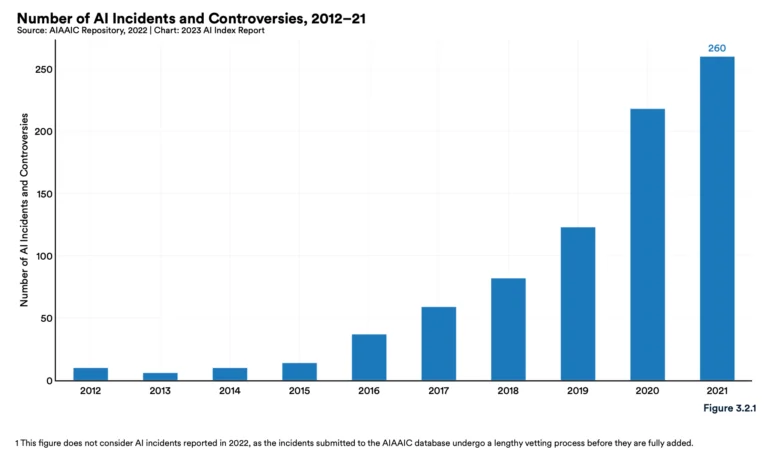

O aumento dos incidentes relatados é uma evidência provável tanto do grau crescente em que a IA está se tornando interligada no mundo real quanto de uma crescente conscientização sobre as maneiras pelas quais a IA pode ser eticamente mal utilizada. O aumento dramático também levanta um ponto importante: à medida que a conscientização cresceu, o rastreamento de incidentes e danos também melhorou – sugerindo que incidentes mais antigos podem ser subnotificados.

AI Index Report 2023

De acordo com o banco de dados independente AIAAIC, que rastreia incidentes relacionados ao uso indevido de IA, o número de incidentes de IA aumentou 26 vezes entre 2012 e 2021.

Os números finais para 2022 ainda não estão disponíveis, pois as entradas do banco de dados estão sujeitas a um longo processo de verificação. Além disso, um alto número de casos não relatados pode ser esperado nos primeiros anos de rastreamento.

Os autores citam um vídeo deepfake publicado em março de 2022, no qual o presidente ucraniano Volodymyr Zelensky supostamente pede que suas tropas se rendam, como um exemplo com alcance particularmente alto.

Prisões dos EUA monitoram telefonemas com IA

Mas, mesmo além dos deepfakes, o uso da IA no passado recente levou a discussões sobre como usá-la eticamente. Por exemplo, há relatos de que a IA está sendo usada para monitorar chamadas telefônicas nas prisões dos EUA. O reconhecimento de fala também foi encontrado para produzir transcrições menos precisas para indivíduos negros, apesar do fato de que uma grande proporção de prisioneiros nos EUA são negros.

Vigilância não é apenas sobre prisioneiros, e nem sempre é secreta. A gigante de TI Intel, por exemplo, é bastante aberta sobre o fato de ter desenvolvido um software para a ferramenta de videoconferência Zoom que pode ler emoções como “entediado”, “distraído” ou “confuso” dos rostos dos alunos.

Finalmente, Midjourney – representante de todos os geradores de imagem AI, incluindo DALL-E 2 e Stable Diffusion – aparece nesta linha preocupante. Os sistemas levantam questões éticas sobre justiça, preconceito, direitos autorais, empregos e privacidade, de acordo com o relatório.

Não mencionada, no entanto, é a capacidade de criar imagens fotorrealistas, que recentemente fizeram manchetes em conexão com pessoas como o Papa Francisco e Donald Trump.