Quando o mundo dos jogos e a inteligência artificial se encontrarem completamente… esperamos que pareça tão bom assim, mas soe ainda melhor.

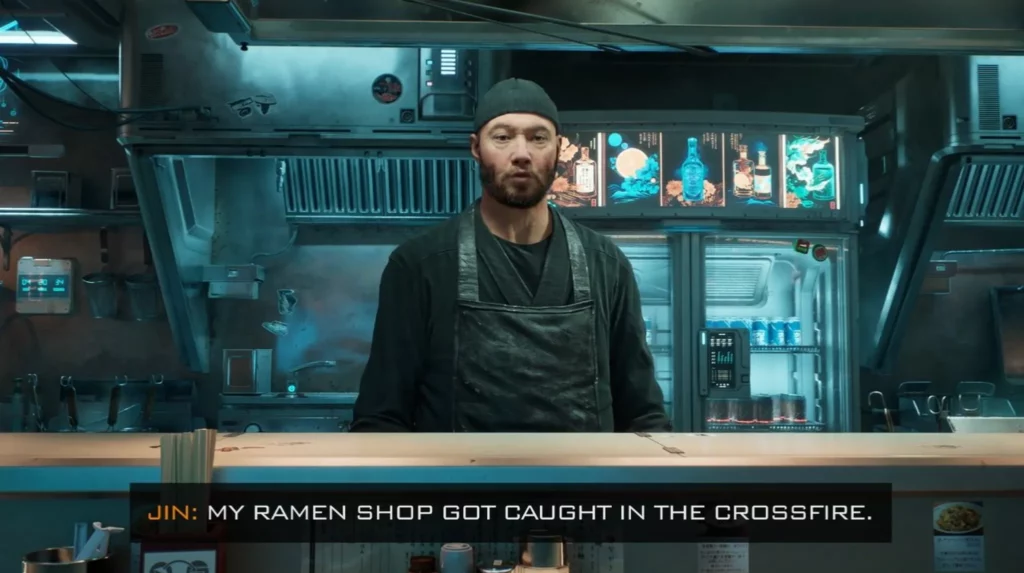

Na Computex 2023 em Taipei, o CEO da Nvidia, Jensen Huang, deu ao mundo um vislumbre do que pode ser quando os jogos e a inteligência artificial se encontram – com uma recriação visualmente deslumbrante de uma loja de ramen cyberpunk onde você pode realmente conversar com o proprietário.

Sério, em vez de clicar em opções de diálogo, imagina-se que você possa segurar um botão, apenas dizer algo com sua própria voz e obter uma resposta de um personagem de videogame. A Nvidia chama isso de “um vislumbre do futuro dos jogos”.

Infelizmente, o diálogo real deixa muito a desejar – talvez tentem usar o GPT-4 ou o Sudowrite da próxima vez, Nvidia?

Aqui está a conversa completa que transcrevi rapidamente:

Jogador: Ei, Jin, como vai?

Jin: Infelizmente, não muito bem.

Por quê?

Estou preocupado com a criminalidade por aqui. Tem piorado ultimamente. Minha loja de ramen foi pega no fogo cruzado.

Posso ajudar?

Se você quiser fazer algo a respeito, ouvi rumores de que o poderoso chefe do crime, Kumon Aoki, está causando todo tipo de caos na cidade. Ele pode ser a raiz dessa violência.

Vou falar com ele, onde posso encontrá-lo?

Ouvi dizer que ele frequenta os clubes de luta clandestinos do lado leste da cidade. Tente lá.

OK, vou lá.

Tenha cuidado, Kai.

Ao assistir a um único vídeo de uma única conversa, é difícil ver como isso é melhor do que escolher entre as opções de diálogo de um NPC, mas a parte impressionante é que a IA generativa está reagindo a uma fala natural. Esperamos que a Nvidia disponibilize o demo para que possamos experimentá-lo nós mesmos e obter resultados radicalmente diferentes.

O demo foi desenvolvido pela Nvidia em parceria com a Convai para promover as ferramentas que foram utilizadas para criá-lo – especificamente uma suíte de middleware chamada Nvidia ACE (Avatar Cloud Engine) for Games, que pode ser executada localmente ou na nuvem. A suíte ACE inclui as ferramentas NeMo da empresa para implantação de modelos de linguagem extensos (LLMs), Riva para conversão de fala em texto e texto em fala, entre outros componentes.

É importante ressaltar que o demo utiliza mais do que essas ferramentas – ele é construído no Unreal Engine 5 com muita renderização de ray tracing… e visualmente é impressionante ao ponto de tornar a parte do chatbot um tanto sem brilho em comparação. Neste ponto, já vimos diálogos muito mais cativantes de chatbots, mesmo que às vezes sejam banais e derivativos.

Durante uma prévia da Computex, o vice-presidente da plataforma GeForce da Nvidia, Jason Paul, afirmou que sim, a tecnologia pode ser escalada para mais de um personagem ao mesmo tempo e teoricamente até permitir que NPCs conversem entre si, mas admitiu que ainda não havia visto isso sendo testado.

Não está claro se algum desenvolvedor irá adotar o conjunto completo de ferramentas ACE da maneira como o demo tenta, mas S.T.A.L.K.E.R. 2 Heart of Chernobyl e Fort Solis utilizarão a parte que a Nvidia chama de “Omniverse Audio2Face”, que tenta sincronizar a animação facial de um personagem 3D com a fala do dublador.

Com conteúdo do The Verge.