A OpenAI introduziu o GPT-4 como um modelo multimodal com compreensão de imagem, mas ainda não lançou a parte de imagem do modelo. MiniGPT-4 torna disponível hoje – como um modelo de código aberto.

MiniGPT-4 é um chatbot com compreensão de imagem. Este é um recurso que o OpenAI introduziu no lançamento do GPT-4, mas ainda não foi lançado fora do aplicativo Be my Eyes.

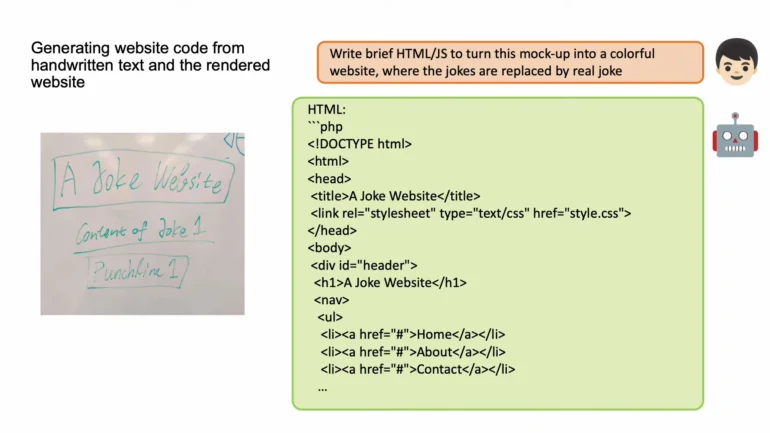

Como sua contraparte maior, o MiniGPT-4 pode descrever imagens ou responder a perguntas sobre o conteúdo de uma imagem: por exemplo, dada uma imagem de um prato preparado, o modelo pode produzir uma (possivelmente) receita correspondente (ver imagem em destaque) ou gerar uma descrição de imagem apropriada para pessoas com deficiência visual. Semelhante ao novo recurso “/describe” do Midjourney, o MiniGPT-4 pode extrair prompts de imagens, ou pelo menos algumas ideias. O muito elogiado recurso de imagem para site do OpenAI, introduzido no lançamento do GPT-4, também pode ser feito com o MiniGPT-4, de acordo com os pesquisadores.

“Nossas descobertas revelam que o MiniGPT-4 processa muitos recursos semelhantes aos exibidos pelo GPT-4, como geração detalhada de descrição de imagens e criação de sites a partir de rascunhos escritos à mão”, afirma o documento.

A equipe de desenvolvimento disponibiliza o código, as demonstrações e as instruções de treinamento do MiniGPT-4 no Github. Eles também anunciam uma versão menor do modelo que será executado em uma única placa gráfica Nvidia 3090. O vídeo abaixo mostra alguns exemplos.

IA de código aberto está em ascensão

A coisa notável sobre o MiniGPT-4 é que ele é baseado no Vicuna-13B LLM e no BLIP-2 Vision Language Model, software de código aberto que pode ser treinado e ajustado por relativamente pouco dinheiro e sem dados maciços e sobrecarga computacional.

A equipe de pesquisa primeiro treinou o MiniGPT-4 com cerca de cinco milhões de pares de texto de imagem em dez horas em quatro cartões Nvidia A100. Em uma segunda etapa, o modelo foi refinado com 3.500 pares de imagens de texto de alta qualidade gerados por uma interação entre o MiniGPT-4 e o ChatGPT. O ChatGPT corrigiu as descrições de imagem incorretas ou imprecisas geradas pelo MiniGPT-4.

Corrija o erro no parágrafo dado. Remova quaisquer frases repetidas, caracteres sem sentido, não frases em inglês e assim por diante. Remova a repetição desnecessária. Reescreva quaisquer frases incompletas. Retorne diretamente os resultados sem explicação. Retorne diretamente o parágrafo de entrada se ele já estiver correto sem explicação.

ChatGPT prompt no MiniGPT-4

Esta segunda etapa melhorou significativamente a confiabilidade e a usabilidade do modelo – e exigiu apenas sete minutos de treinamento em um único Nvidia A100. Os próprios pesquisadores disseram que ficaram surpresos com a eficiência de sua abordagem.

O modelo de linguagem do MiniGPT-4 Vicuna segue a “fórmula da alpaca” e usa a saída do ChatGPT para ajustar um modelo de linguagem Meta da família LLaMA. Vicuna é dito estar a par com o Google Bard e ChatGPT, novamente com um esforço de treinamento relativamente pequeno.

O MiniGPT-4 é outro exemplo do rápido progresso que a comunidade de código aberto fez em um tempo muito curto. Isso sugere que o fosso para empresas de modelos puros de IA pode não ser tão alto: ontem, o chatbot de código aberto OpenAssistant foi lançado, treinado com dados instrucionais coletados de voluntários e destinado a se tornar uma alternativa aberta ao ChatGPT eventualmente.

Dado esse desenvolvimento, faria sentido que a OpenAI primeiro se concentrasse na construção de um ecossistema de parceiros usando plugins ChatGPT para GPT-4, em vez de treinar GPT-5 agora. O esforço de pesquisa e treinamento para um novo modelo pode ser maior para a OpenAI do que a vantagem que ela pode ganhar sobre os concorrentes ou a comunidade de código aberto. Em comparação, construir um ecossistema de bate-papo é mais desafiador e economicamente insustentável. Ele também pode ter um forte efeito de bloqueio nos usuários.