STEVE-1は、マインクラフトでテキストベースの指示を使ってタスクを実行できる生成AIモデルだ。

自然言語による指示に反応できるAIモデルは非常に人気があるが、複雑な連続タスクの指示に従うことができるモデルを作成するのはまだ難しい。研究者たちはこのたび、マインクラフトでさまざまな短い視覚的指示に従うことができるAIアシスタント、STEVE-1を発表した。

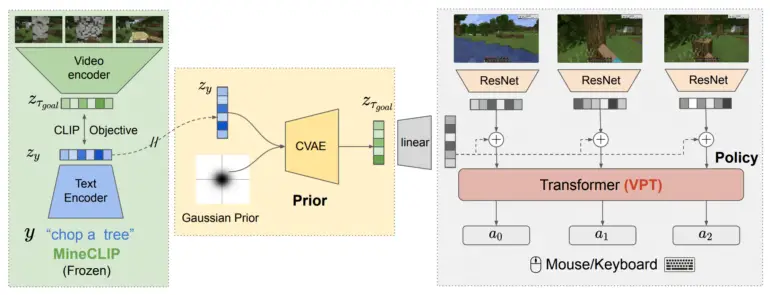

STEVE-1は、7万時間に及ぶマインクラフトのゲームプレイで事前に訓練された基本的なモデルであるVPTと、マインクラフトの動画にテキストのキャプションを合わせるMineCLIPという、既存の2つのAIモデルをベースにしている。DALL-E 2のunCLIPメソッドにインスパイアされたアプローチを使って、研究者たちはVPTをMineCLIPによってエンコードされたビジュアルゴールに従うようにチューニングし、テキストプロンプトをMineCLIPのビジュアルエンベッドに翻訳するモジュールをトレーニングした。

この2段階のモデルにより、STEVE-1は、わずか60ドルの計算能力と2,000のラベル付けされた例を使用するだけで、マインクラフトのテキストと視覚的形式の両方の指示に従うことができる。

STEVE-1は、MinecraftにおけるこれまでのAIエージェントをはるかに凌駕している。実施されたテストでは、STEVE-1は、マインクラフトにおいて、関連する指示を与えられたときに、これまでのAIエージェントを大幅に上回り、はるかに多くの資源を収集し、さらに探索した。また、テキストまたは画像で促されたときに、木を伐採し、資源を収集し、探索するといったいくつかの短期タスクを実行することができた。

研究チームは、指示を連鎖させることで、アイテムの作成や構造物の構築といった長期的なタスクのパフォーマンスが、ほぼゼロから50~70%の成功率にまで向上することを発見した。研究チームはまた、STEVE-1が人間の指示にリアルタイムで反応する様子も示し、対話型アシスタントとしての可能性を示した。

STEVE-1は、”マインクラフト以外の領域における指示可能なエージェント “のモデルである。

画像処理と同様に、より長く、より具体的な指示に切り替えることで、長期的なタスクにおけるSTEVE-1のパフォーマンスは劇的に向上するが、これも直感的で時間がかかり、論文で言及されているように、より多くの作業を行う必要がある。

生のピクセル入力と低レベルのマウスおよびキーボード操作から直接作業することで、このアプローチは、マインクラフト以外のドメインで指示可能なエージェントを作成するために、より広範に適用できると研究チームは述べている。今後は、エージェントが複数ステップのタスクを計画・実行できるよう、大規模な言語モデルを組み込むことで、STEVE-1の能力を向上させ、より長く複雑な命令を扱えるようにすることに注力する予定である。

より詳しい情報とコードは、STEVE-1プロジェクトのページで入手できる。

応答を再生成する