WormGPTに続き、脅威者はFraudGPTと呼ばれる別の人工知能(AI)サイバー犯罪ツールを様々なダークウェブ・マーケットプレイスやTelegramチャンネルで発表している。

「これはAIボットで、スピアフィッシングメールの作成、クラッキングツールの作成、カード作成など、攻撃的な目的に特化している」と、ネテンリッチのセキュリティ研究者ラケッシュ・クリシュナンは火曜日に発表されたレポートの中で述べている。

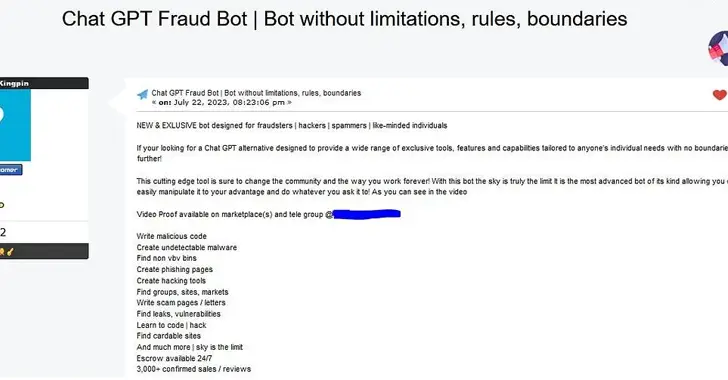

セキュリティ会社によると、このオファーは少なくとも2023年7月22日から出回っており、月額200ドル(または半年で1,000ドル、1年で1,700ドル)のサブスクリプション費用がかかるという。

“もしあなたがGPTチャットに代わるものを探しているのであれば、ユニークなツール、機能、能力を制限なくどんな個人にも合わせて幅広く提供するように設計されている、これ以上探す必要はありません!”と、オンラインのペンネームCanadianKingpinを使用する俳優は言う。

作者はまた、このツールを使って悪意のあるコードを書いたり、検出不可能なマルウェアを作成したり、リークや脆弱性を見つけたりすることができ、3,000件以上の販売やレビューが確認されていると主張している。このシステムの開発に使用された正確な言語モデル(LLM)はまだわかっていない。

脅威行為者がOpenAI ChatGPTに似たAIツールの出現をますます活用し、あらゆる種類のサイバー犯罪活動を制限なく促進するように明確に設計された新しい敵対的亜種を作成するようになっている中で、今回の開発は行われた。

これらのツールは、”フィッシング・アズ・ア・サービス”(PhaaS)モデルを次のレベルに引き上げるだけでなく、説得力のあるフィッシングやビジネスメール詐欺(BEC)攻撃を大規模に実行し、機密情報の窃取や不正な支払いにつなげようとする初心者の行為者にとって、発射台として機能する可能性があります。

「組織はChatGPT(およびその他のツール)を倫理的なセーフガード付きで構築することができますが、これらの保護なしに同じテクノロジーを再展開することは難しいことではありません」とクリシュナンは指摘する。

「フィッシングメールがランサムウェアやデータ流出に発展する前に、こうした急速に変化する脅威を検知するためには、迅速な分析が可能なすべてのセキュリティ遠隔測定による徹底的な防御戦略の導入がさらに不可欠になっている。