日本の研究者が、ニューロモーフィック・ハードウェアをAIコンピューティングに実用化する可能性のある新しいトランジスタを発表。

ニューロモーフィック・コンピューティングの分野では、人間の脳の構造と計算能力を模倣したシステムを開発している。その要素のひとつが、ニューラルネットワークをエミュレートするいわゆる「リザーバー」であり、AIの研究開発において、より大きな計算能力と速度に対する膨大な需要を満たす日が来ると期待されている。

ニューロモーフィック・コンピューティングにおけるリザーバーのアイデアは、リザーバー・コンピューティングの概念から来ている。リザーバー・コンピューティングとは、リカレント・ニューラル・ネットワーク(RNN)のフレームワークで、リカレント層(「リザーバー」)はランダムに生成され、トレーニングは行われない。その代わり、学習を通じて出力重みのみが更新される。これにより、学習プロセスが簡素化され、より効率的になる。

ニューロモーフィック・コンピューティングでは、このようなリザーバーは、アナログ電子回路、光電子システム、機械システムなど、さまざまな基板上に実装することができる。この文脈では、「フィジカル・リザーバー・コンピューティング」という用語が使われる。

これらのリザーバーは、入力データの相互作用や処理によって時間と共に変化するニューラルネットワークのように動作するため、データを物体認識などの複雑なタスクに適した高次元表現に変換することができる。しかし実際には、このようなシステムには多数のリザーバー状態が必要であり、現在のハードウェアでは実現が難しい。

新しいトランジスタはリザーバー状態を2倍にする

このようなメモリ・システムの互換性、性能、統合の問題を克服するため、日本の研究者たちは新しいトランジスタを開発した。研究チームによると、この開発は、高性能ニューロモーフィック・コンピューティングの新たな可能性を開くものだという。

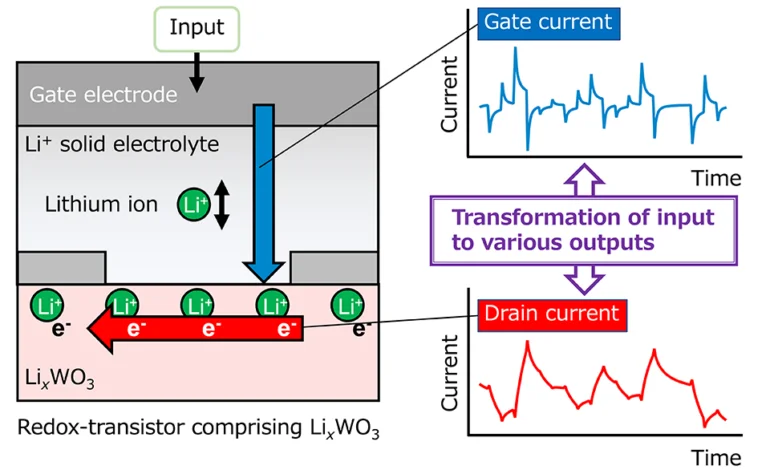

研究チームの新しいトランジスタは、イオンゲート・リザーバ・トランジスタと呼ばれ、記録的な数のリザーバ状態を生成することができる。研究チームによると、このトランジスターは、リチウムイオンが高速で移動する電解質を利用することで、2つの出力電流フローを生成し、リザーバー状態の数を実質的に2倍に増やすことができるという。

さらに、チャネルと電解質におけるイオン輸送速度の違いにより、ドレイン電流とゲート電流の2つの電流間に遅延が生じる。この遅延により、システムは以前の入力からの情報を短時間保存し、将来の動作に利用することができる。

テストでは、このデバイスはメモリスタなど他の類似技術を凌駕し、過去の入出力データに基づく予測精度が非常に高いことが証明された。東京理科大学の樋口徹准教授によると、このシステムは「将来、コンピューターや携帯電話など幅広い電子機器に搭載される汎用技術」になる可能性があるという。

デコーダーのコンテンツで