Usando um manual de jogo, uma IA aprendeu um antigo jogo Atari milhares de vezes mais rápido do que com métodos mais antigos. Essa abordagem também pode ser útil em outras áreas.

Em março de 2020, os cientistas da DeepMind revelaram o Agent57, o primeiro modelo treinado em aprendizado de reforço profundo (RL) a superar os humanos em todos os 57 jogos do Atari 2600.

Para o jogo Skiing da Atari, que é considerado particularmente difícil e exige que o agente de IA evite árvores em uma pista de esqui, o Agent57 precisava de 80 bilhões de quadros de treinamento – a 30 quadros por segundo, o que levaria um ser humano quase 85 anos.

IA aprende a jogar 6.000 vezes mais rápido

Em um novo artigo, “Read and Reap the Rewards”, pesquisadores da Carnegie Mellon University, Ariel University e Microsoft Research mostram como esse tempo de treinamento pode ser reduzido para apenas 13 milhões de quadros – ou cinco dias.

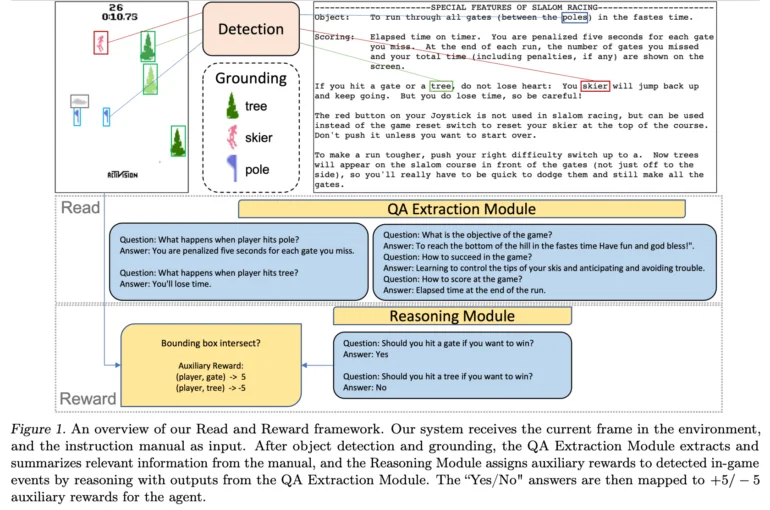

O Read and Reward Framework usa instruções de jogo escritas por humanos, como o manual do jogo, como fonte de informações para o agente de IA. De acordo com a equipe, a abordagem é promissora e pode melhorar significativamente o desempenho dos algoritmos RL nos jogos da Atari.

Extrair informações, fazer inferências

Os pesquisadores citam o comprimento das instruções, que muitas vezes são redundantes, como um desafio. Além disso, dizem eles, muitas das informações importantes nas instruções são muitas vezes implícitas e só fazem sentido se puderem estar relacionadas ao jogo. Um agente de IA que usa instruções deve, portanto, ser capaz de processar e raciocinar sobre as informações.

A estrutura, portanto, consiste em dois componentes principais: o módulo de Extração de GQ e o módulo de Raciocínio. O módulo de Extração de GQ extrai e agrupa informações relevantes das instruções, fazendo perguntas e extraindo respostas do texto. O módulo Raciocínio avalia as interações objeto-agente com base nessas informações e atribui recompensas de ajuda para eventos reconhecidos no jogo.

Essas recompensas de ajuda são então passadas para um agente A2C-RL (Advantage Actor Critic), que conseguiu melhorar seu desempenho em quatro jogos no ambiente Atari com recompensas esparsas. Esses jogos geralmente exigem um comportamento complexo até que o jogador seja recompensado – então as recompensas são “esparsas”, e um agente RL que procede apenas por tentativa e erro não recebe um bom sinal de aprendizado.

Aproveite as recompensas fora do Atari Skiing

Usando as instruções, o número de quadros de treinamento necessários pode ser reduzido por um fator de 1.000, escrevem os autores. Em uma entrevista com a New Scientist, o primeiro autor Yue Wu até fala de uma aceleração por um fator de 6.000. Se o manual vem dos próprios desenvolvedores ou da Wikipédia é irrelevante.

Segundo os pesquisadores, um dos maiores desafios é o reconhecimento de objetos nos jogos da Atari. Nos jogos modernos, no entanto, isso não é um problema porque eles fornecem verdade objetiva, eles escrevem. Além disso, avanços recentes em modelos multimodais de vídeo-linguagem sugerem que em breve estarão disponíveis soluções mais confiáveis que poderiam substituir a parte de reconhecimento de objetos da estrutura atual. No mundo real, algoritmos avançados de visão computacional podem ajudar.