Quand le monde du jeu et l’intelligence artificielle se rencontreront… nous espérons que ce sera aussi beau, mais que ça sonnera encore mieux.

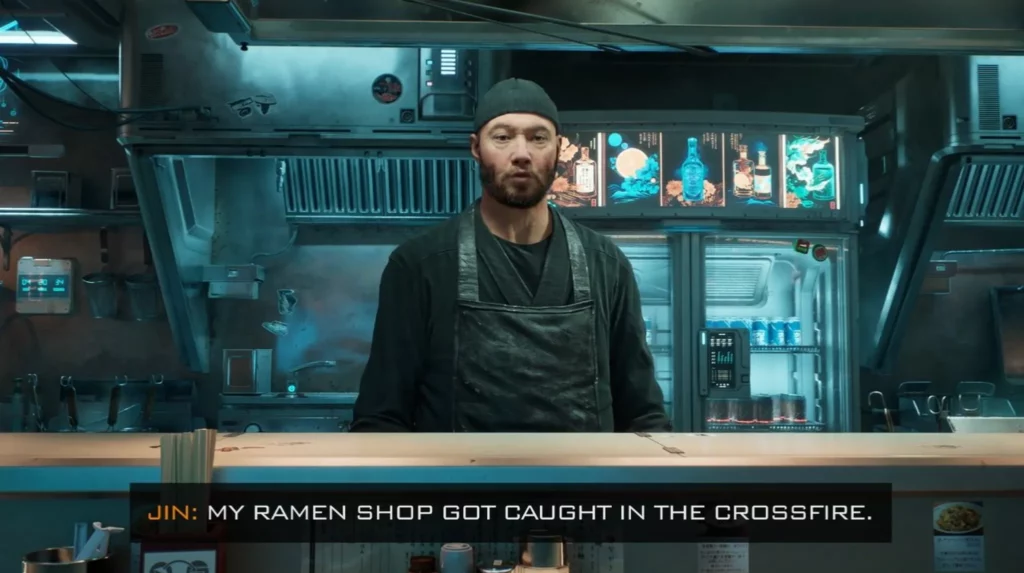

Lors du Computex 2023 à Taipei, le PDG de Nvidia, Jensen Huang, a donné au monde un aperçu de ce que pourrait être la rencontre du jeu et de l’IA – avec une reconstitution visuellement stupéfiante d’un magasin de ramen cyberpunk où l’on peut réellement parler au propriétaire.

Sérieusement, au lieu de cliquer sur des options de dialogue, on imagine que l’on peut appuyer sur un bouton, dire quelque chose avec sa propre voix et obtenir une réponse d’un personnage de jeu vidéo. Nvidia parle d’un « aperçu de l’avenir des jeux vidéo ».

Malheureusement, le dialogue proprement dit laisse beaucoup à désirer – essayez peut-être d’utiliser GPT-4 ou Sudowrite la prochaine fois, Nvidia ?

Voici la conversation complète que j’ai rapidement transcrite :

Joueur : Hé Jin, comment vas-tu ?

Jin : Malheureusement, pas très bien.

Pourquoi ?

Je m’inquiète de la criminalité dans le coin. Elle a empiré ces derniers temps. Mon magasin de ramen a été pris entre deux feux.

Je peux vous aider ?

Si vous voulez faire quelque chose, j’ai entendu des rumeurs selon lesquelles le puissant chef du crime, Kumon Aoki, sème le chaos dans la ville. Il est peut-être à l’origine de cette violence.

Je vais lui parler. Où puis-je le trouver ?

J’ai entendu dire qu’il fréquentait les clubs de combat clandestins de l’est de la ville. Essayez là-bas.

D’accord, j’y vais.

Fais attention, Kai.

En regardant une seule vidéo d’une seule conversation, il est difficile de voir en quoi c’est mieux que de choisir parmi les options de dialogue d’un PNJ, mais ce qui est impressionnant, c’est que l’IA générative réagit à la parole naturelle. Espérons que Nvidia rendra la démo disponible pour que nous puissions l’essayer nous-mêmes et obtenir des résultats radicalement différents.

La démo a été développée par Nvidia en partenariat avec Convai afin de promouvoir les outils qui ont permis de la créer, en particulier une suite de logiciels intermédiaires appelée Nvidia ACE (Avatar Cloud Engine) pour les jeux, qui peut fonctionner localement ou dans le nuage. La suite ACE comprend les outils NeMo de l’entreprise pour le déploiement de modèles de langage étendus (LLM), Riva pour la conversion de la parole au texte et du texte à la parole, parmi d’autres composants.

Il est important de noter que la démo utilise plus que ces outils – elle est construite dans Unreal Engine 5 avec beaucoup de rendu par ray tracing… et visuellement, c’est impressionnant au point de rendre la partie chatbot quelque peu terne en comparaison. À ce stade, nous avons vu des dialogues beaucoup plus engageants de la part des chatbots, même s’ils sont parfois banals et dérivés.

Lors d’une présentation au Computex, Jason Paul, vice-président de la plateforme GeForce de Nvidia, a déclaré qu’effectivement, la technologie pouvait s’adapter à plus d’un personnage à la fois et même théoriquement permettre aux PNJ de se parler, mais il a admis qu’il n’avait pas encore testé cette technologie.

Il est difficile de savoir si des développeurs adopteront l’ensemble des outils ACE comme le fait la démo, mais S.T.A.L.K.E.R. 2 Heart of Chernobyl et Fort Solis utiliseront la partie que Nvidia appelle « Omniverse Audio2Face », qui tente de synchroniser l’animation faciale d’un personnage en 3D avec la voix de l’acteur.

Avec le contenu de The Verge.