Cuando el mundo de los juegos y la inteligencia artificial se fusionen por completo, esperamos que no solo luzca increíble, sino que también tenga un sonido aún más espectacular.

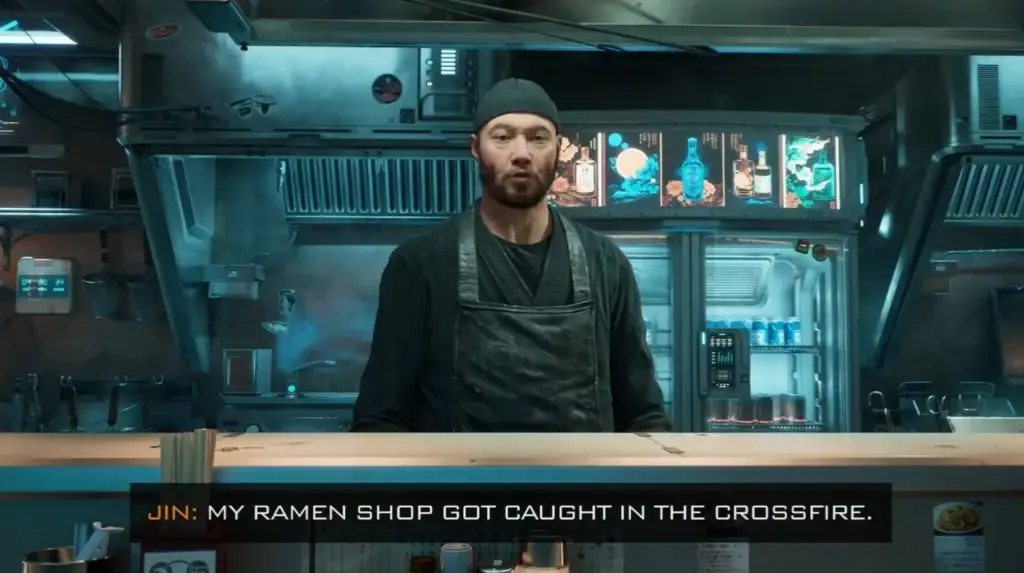

En la Computex 2023 en Taipei, el CEO de Nvidia, Jensen Huang, dio al mundo una visión de lo que podría ser cuando los juegos y la inteligencia artificial se encuentren, con una recreación visualmente deslumbrante de una tienda de ramen cyberpunk donde realmente puedes conversar con el propietario.

En serio, en lugar de hacer clic en opciones de diálogo, se imagina que podrías mantener presionado un botón, simplemente decir algo con tu propia voz y obtener una respuesta de un personaje de videojuego. Nvidia llama a esto «una visión del futuro de los juegos».

Lamentablemente, el diálogo real deja mucho que desear. Tal vez deberían intentar usar GPT-4 o Sudowrite la próxima vez, ¿no, Nvidia?

Aquí está la conversación completa que transcribí rápidamente:

Jugador: ¡Hola, Jin! ¿Cómo estás?

Jin: Lamentablemente, no muy bien.

¿Por qué?

Estoy preocupado por la delincuencia aquí. Ha empeorado últimamente. Mi tienda de ramen se ha visto atrapada en un fuego cruzado.

¿Puedo ayudar?

Si quieres hacer algo al respecto, he escuchado rumores de que el poderoso jefe del crimen, Kumon Aoki, está causando todo tipo de caos en la ciudad. Él puede ser la raíz de esta violencia.

Voy a hablar con él, ¿dónde puedo encontrarlo?

He oído que frecuenta los clubes de lucha clandestinos del lado este de la ciudad. Intenta allí.

OK, iré allí.

Ten cuidado, Kai.

Al ver un solo video de una sola conversación, es difícil ver cómo esto es mejor que elegir entre las opciones de diálogo de un NPC, pero lo impresionante es que la IA generativa está reaccionando a una conversación natural. Esperamos que Nvidia ponga el demo a disposición para que podamos probarlo nosotros mismos y obtener resultados radicalmente diferentes.

El demo fue desarrollado por Nvidia en colaboración con Convai para promocionar las herramientas que se utilizaron para crearlo, específicamente una suite de middleware llamada Nvidia ACE (Avatar Cloud Engine) for Games, que puede ejecutarse localmente o en la nube. La suite ACE incluye herramientas de la empresa como NeMo para la implementación de modelos de lenguaje extensos (LLMs), Riva para la conversión de habla a texto y texto a habla, entre otros componentes.

Es importante destacar que el demo utiliza más que estas herramientas, está construido en Unreal Engine 5 con una gran cantidad de renderizado de trazado de rayos… y visualmente es impresionante hasta el punto de hacer que la parte del chatbot sea un tanto opaca en comparación. Hasta ahora, hemos visto diálogos de chatbots mucho más cautivadores, incluso si a veces son triviales y derivativos.

Durante un adelanto de Computex, el vicepresidente de la plataforma GeForce de Nvidia, Jason Paul, afirmó que sí, la tecnología puede ser escalada para más de un personaje al mismo tiempo y teóricamente incluso permitir que los NPCs conversen entre sí, pero admitió que aún no había visto que esto se probara.

No está claro si algún desarrollador adoptará el conjunto completo de herramientas ACE de la forma en que intenta hacerlo el demo, pero S.T.A.L.K.E.R. 2 Heart of Chernobyl y Fort Solis utilizarán la parte que Nvidia llama «Omniverse Audio2Face», que intenta sincronizar la animación facial de un personaje en 3D con la voz del actor de doblaje.

Con contenido de The Verge.