Normalmente, ninguém responde quando você fala consigo mesmo. A IA pode preencher essa lacuna.

Em um tópico no subreddit r/singularity, um usuário apresentou seu projeto mais recente: um grande modelo de linguagem que ele treinou com 100 horas de entrevistas autoconduzidas. Agora, o usuário UsedRow2531 pode conduzir entrevistas com uma “versão fantasmagórica local” de si mesmo.

Ele explicou que o projeto envolveu muitas experimentações e “muitas noites até tarde conversando comigo mesmo”. Ele enfatizou que o sucesso do projeto dependia menos do método e mais da qualidade do corpus de entrevistas.

A methodologia não importa, o corpus é crucial

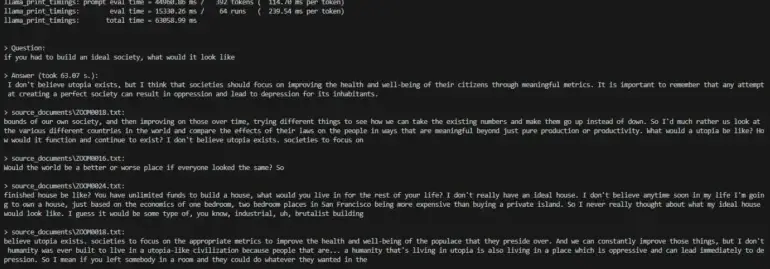

Ele escolheu o modelo Vicuna após obter “resultados estranhos” com o Metas LLaMA 2 (llama-2-70b-hf). Ele não tinha certeza se isso se devia a modificações incorretas que ele fez ou se o modelo realmente não estava fazendo o que deveria fazer.

De forma conveniente, o modelo dele também pode indicar a fonte, possibilitando rastrear de qual período de tempo a resposta veio.

Google, engenharia e muitas noites até tarde conversando comigo mesmo como uma pessoa insana. O método não importa. A qualidade do corpus de entrevistas é o que importa. Com um conjunto de dados massivo, o “como” não tem significado. Este modelo foi treinado com base em mim até 2019. Ainda não o alimentei com dados de 2019 a 2023. É puramente uma prova de conceito para me certificar de que estou no caminho certo.

u/UsedRow2531 no Reddit

A postagem recebeu uma resposta positiva da comunidade do Reddit. Muitos usuários ficaram impressionados e pediram instruções específicas sobre como criar um “gêmeo digital” de si mesmos. Outros perguntaram sobre possíveis aplicações para projetos semelhantes, incluindo a possibilidade de treinar um modelo de IA com e-mails pessoais.

Novas ferramentas para historiadores e investigadores, também?

As discussões em torno da contribuição de UsedRow2531 também levaram a reflexões filosóficas sobre o futuro das autobiografias e registros pessoais.

O usuário u/Pelumo_64 especulou que uma pessoa poderia coletar seus pensamentos em um diário digital, com texto gerado a partir de gravações de áudio conforme necessário. Esse texto seria convertido em um bot interativo capaz de responder a perguntas.

As perguntas poderiam ser sobre a vida diária ou crenças que a pessoa tinha anteriormente. De acordo com u/Pelumo_64, um bot assim poderia ser uma ferramenta valiosa para antropólogos, historiadores e investigadores criminais mergulharem mais profundamente nos pensamentos e na vida cotidiana das pessoas.

O “fantasma” também tem alucinações

No entanto, o projeto reproduz as conhecidas deficiências dos principais modelos de linguagem. Essas deficiências podem não ser um problema no âmbito privado, mas também mostram que a profissão do biógrafo profissional provavelmente não desaparecerá tão cedo.

Apesar do banco de dados cuidadosamente selecionado, o modelo de IA apresentou alguns comportamentos inesperados. Entre outras coisas, ele repetiu várias vezes que era um gênio e que acreditava na existência de extraterrestres. Esses eram aspectos que o usuário u/UsedRow2531 nunca mencionou em suas entrevistas originais.

Eu nunca disse isso. Eu verifiquei tudo. Ele fica distorcido quando eu o corrijo. O LLM de alguma forma analisa o que eu disse e decidiu que era um gênio. Eu não sou um gênio, nem considero isso um gênio. Tudo muito estranho.

u/UsedRow2531 no Reddit

O usuário u/More_Grocery-1858 tem uma resposta plausível: o modelo funciona com probabilidades estatísticas e, portanto, reconhece as diferentes conexões entre palavras.

Pessoas que disseram coisas semelhantes ao autor original também se autodenominariam gênios. Isso leva ao efeito mostrado, mesmo que o autor do tópico inicial não se chame de gênio.

O conceito não é realmente novo. No final de 2022, uma artista teve a ideia de alimentar o GPT-3 com entradas de diário de sua infância para se conhecer melhor. E o que o próprio inventor u/UsedRow2531 diz sobre o projeto? “O futuro vai ser estranho.”

Com conteúdo do The Decoder.