Após meses de rumores, o Apple Intelligence finalmente chegou e promete oferecer aos usuários mais do que apenas imagens generativas.

No final da apresentação da Apple para a WWDC 2024, após os principais anúncios do sistema operacional, a empresa passou para o evento principal. Ela discutiu seu impulso, muitas vezes rumorizado, para o aprendizado de máquina.

Batizada de Apple Intelligence, a nova adição tem tudo a ver com o uso de grandes modelos de linguagem (LLMs) para lidar com tarefas que envolvem texto, imagens e ações no aplicativo.

Para começar, o sistema é capaz de resumir as principais notificações, mostrando aos usuários os itens mais importantes em um resumo, com base no contexto.

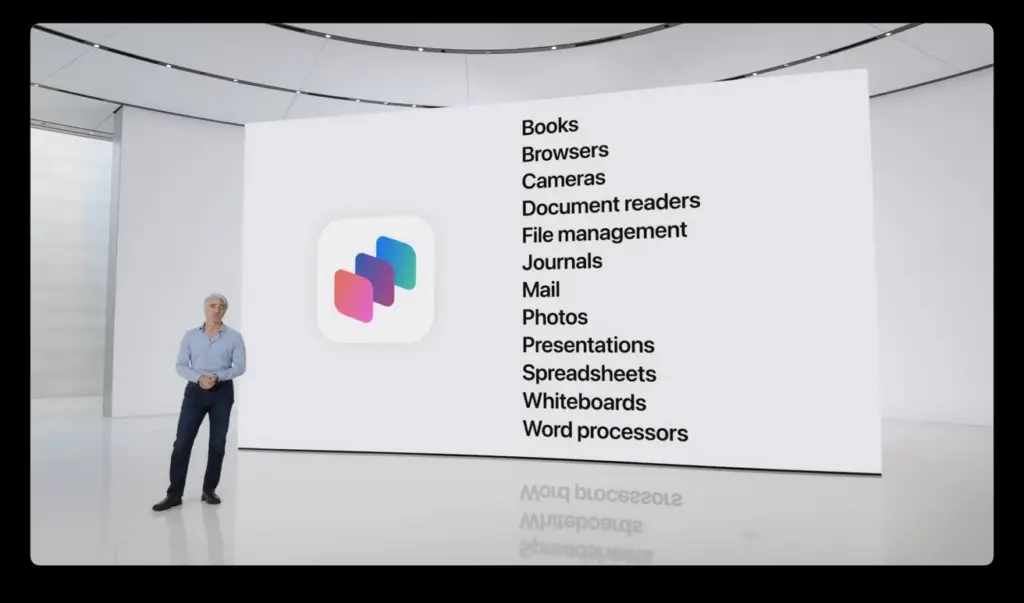

As ferramentas de redação de todo o sistema podem escrever, revisar e resumir textos para os usuários. Isso está disponível automaticamente em aplicativos incorporados e aplicativos de terceiros.

O Apple Intelligence também pode criar imagens, novamente para muitos aplicativos incorporados. Isso inclui imagens personalizáveis para conversas com contatos específicos no Messages, por exemplo.

Essas imagens são criadas em três estilos: Esboço, Animação e Realismo.

Ele também pode executar ações nos aplicativos em nome do usuário. Por exemplo, ele pode abrir o Photos e mostrar imagens de grupos específicos de pessoas a partir de uma solicitação.

A Apple também afirma que o Apple Intelligence se baseia no contexto de uma solicitação dentro dos dados de um usuário. Por exemplo, ela poderia descobrir quem são os membros da família em relação ao usuário e como as reuniões podem se sobrepor ou entrar em conflito.

Muito disso é baseado no processamento no dispositivo para segurança e privacidade. O chip A17 Pro da linha iPhone 15 Pro é considerado suficientemente potente para lidar com esse nível de processamento.

Computação em nuvem privada

Muitos modelos estão sendo executados no dispositivo, mas às vezes o processamento requer processamento na nuvem. Isso pode ser um problema de segurança, mas o método da Apple é diferente.

O Private Cloud Compute permite que o Apple Intelligence trabalhe na nuvem, preservando a segurança e a privacidade. Os modelos são executados em servidores que executam o Apple Silicon, usando aspectos de segurança do Swift.

Os processos no dispositivo determinam se a solicitação deve ser enviada aos servidores em nuvem ou se pode ser tratada localmente.

A Apple insiste que os servidores são seguros, que eles não armazenam dados do usuário e usam elementos criptográficos para manter a segurança.

Não é para todos os usuários

Embora o Apple Intelligence seja benéfico para muitos usuários, os requisitos impedirão que muitos o utilizem.

No iPhone, a exigência de um chip A17 Pro significa que somente os usuários do iPhone 15 Pro e Pro Max podem experimentá-la na versão beta. Da mesma forma, iPads com chips da série M e Macs com Apple Silicon também poderão usá-lo.

Ele estará disponível em versão beta “neste outono”, somente em inglês dos EUA.