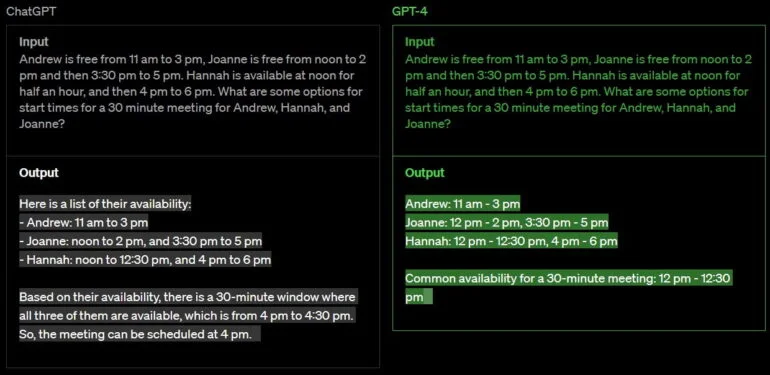

De acordo com a OpenAI, o GPT-4 é “mais criativo e colaborativo” do que qualquer sistema anterior de IA, tem uma base de conhecimento mais ampla e é melhor em resolver problemas.

Como um sistema multimodal, ele aceita imagens como entrada, além de texto.

De acordo com a OpenAI, o GPT-4 é um “avanço” em tarefas que exigem solução estruturada de problemas. Por exemplo, o GPT-4 pode fornecer instruções passo a passo em resposta a uma pergunta sobre como limpar um aquário.

Em um exame de barra simulado, espera-se que o GPT-4 pontue nos dez por cento dos exames, onde o GPT-3.5 pontuou nos dez por cento inferiores.

O GPT-4 pode lidar com mais de 25.000 palavras, tornando-o adequado para gerar documentos e análises maiores.

O banco de dados do GPT-4 termina em setembro de 2021, e o modelo não aprende com sua própria experiência. O GPT 3.5 foi um primeiro teste para o novo sistema, de acordo com a OpenAI.

O novo sistema de IA é baseado diretamente nas lições aprendidas com os programas de testes adversários e no feedback sobre o ChatGPT.

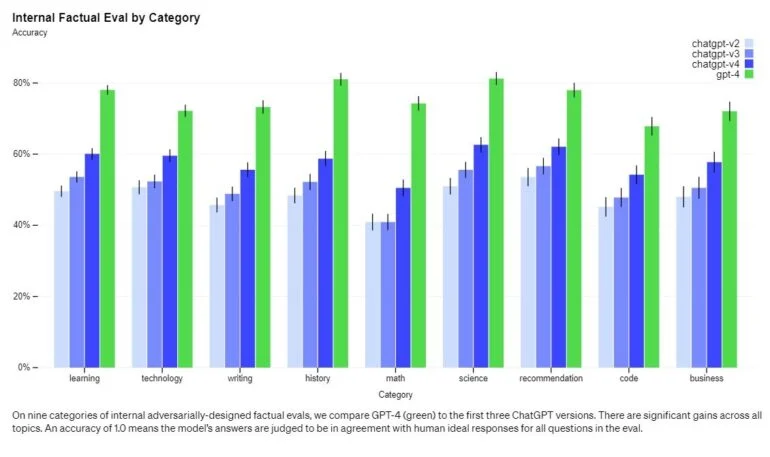

Diz-se que supera significativamente os sistemas existentes em termos de factualidade e dirigibilidade, embora esteja “longe de ser perfeito”.

![Desempenho de referência GPT 4 em tarefas projetadas para humanos em comparação com GPT 3.5. | Imagem: OpenAI]](https://andrelug.com/wp-content/uploads/2023/03/gpt-4-mais-rapido.webp)

O GPT-4 também supera seu antecessor em até 16% em benchmarks comuns de aprendizado de máquina e supera o GPT 3,5 em 15% em tarefas multilíngues.

A OpenAI também desenvolveu novos métodos para prever o desempenho do GPT-4 em alguns domínios, usando modelos treinados com apenas um milésimo do esforço computacional do GPT-4.

Nesta previsão dos recursos de IA, a OpenAI vê um aspecto importante de segurança que não está sendo abordado adequadamente, dado o impacto potencial da IA.

“Estamos ampliando nossos esforços para desenvolver métodos que forneçam à sociedade uma melhor orientação sobre o que esperar dos sistemas futuros, e esperamos que isso se torne um objetivo comum no campo”, escreve OpenAI.

A OpenAI também começou a usar o GPT-4 para ajudar os seres humanos a avaliar as saídas de IA. Esta é a segunda fase de sua estratégia de alinhamento anunciada anteriormente.

Vídeo oficial de lançamento:

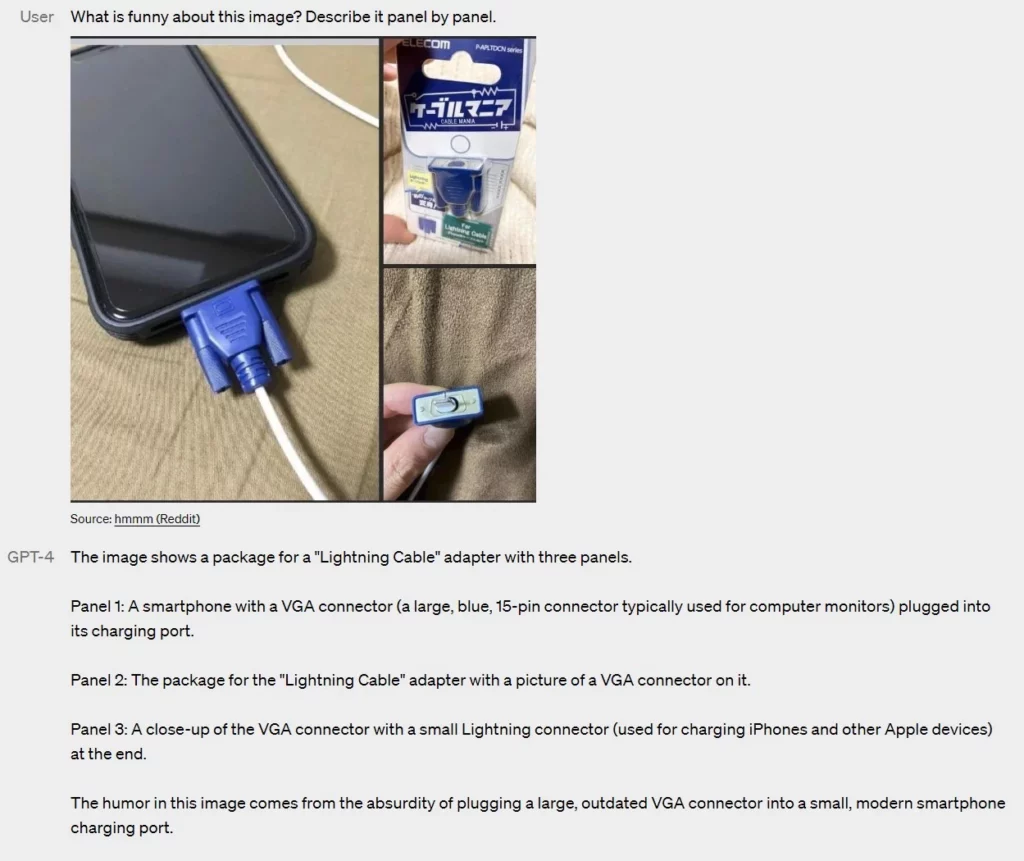

GPT-4 também pode processar imagens

O novo recurso mais óbvio do GPT-4 é sua capacidade de processar imagens como entrada. Por exemplo, ele pode explicar um meme ou a singularidade de um motivo usando apenas entrada de imagem, pode quebrar infográficos passo a passo e pode resumir gráficos científicos ou explicar aspectos individuais deles.

Em benchmarks comuns, o GPT-4 já supera os modelos de imagem de texto existentes. A OpenAI diz que ainda está descobrindo “tarefas novas e emocionantes” que o GPT-4 pode resolver visualmente.

Para controlar o modelo, o OpenAI depende de mensagens do sistema para clientes de API. Estes podem ser usados para determinar, até certo ponto, o caráter das respostas do modelo, ou seja, se GPT-4 responde mais no estilo de um ator de Hollywood ou de uma forma socrática.

Suas limitações são parecidas com as últimas versões

Apesar dos avanços significativos no raciocínio e na multimodalidade, o GPT-4 tem limitações semelhantes às do seu antecessor. Por exemplo, ainda não é completamente confiável e é propenso a alucinações. No entanto, nas avaliações internas de factualidade adversária do OpenAIs, o GPT-4 tem um desempenho em média 40% superior ao GPT 3.5 e atinge pontuações médias de precisão entre 70 e 80%.

O GPT-4 também continua a criar preconceitos ou reforçar os existentes – “ainda há muito trabalho a ser feito”, admite a OpenAI. Neste contexto, a empresa aponta para planos recentemente anunciados para modelos de linguagem de IA personalizáveis que podem refletir os valores de diferentes usuários e, assim, representar um maior grau de diversidade de opinião.

A OpenAI melhorou significativamente a segurança em relação às consultas que o modelo não deve responder porque violam as políticas de conteúdo da OpenAI. Em comparação com o GPT 3.5, o GPT-4 responde 82% menos consultas críticas.

Também é dito que é 29% mais provável que forneça respostas que estejam em conformidade com as políticas da OpenAI para consultas confidenciais, como aquelas relacionadas a tópicos médicos.

Passamos 6 meses tornando o GPT-4 mais seguro e alinhado. O GPT-4 é 82% menos propenso a responder a solicitações de conteúdo não permitido e 40% mais propenso a produzir respostas factuais do que o GPT-3.5 em nossas avaliações internas.

OpenAI

GPT-4 será primeiro lançado para assinantes do ChatGPT Plus

A OpenAI está inicialmente disponibilizando o GPT-4 para clientes pagantes do ChatGPT Plus. O serviço custa US $ 20 por mês e está disponível internacionalmente.

Os desenvolvedores terão acesso por meio de uma API, como nos modelos anteriores. OpenAI oferece uma lista de espera GPT-4 aqui.

O comprimento do contexto do GPT-4 é limitado a cerca de 8.000 tokens, ou cerca de 25.000 palavras. Há também uma versão que pode lidar com até 32.000 tokens, ou cerca de 50 páginas, mas o OpenAI atualmente limita o acesso.

Os preços são de US $ 0,03 por token de prompt 1k e US $ 0,06 por token de conclusão 1k (8k) ou US $ 0,06 por token de prompt 1k e US $ 0,12 por token de conclusão 1k (32k), significativamente mais altos do que os preços do ChatGPT e GPT 3.5.

O modelo mais barato, o gpt-3.5-turbo, custa apenas cerca de US $ 0,002 por 1000 tokens.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

O relatório OpenAI atual não fornece mais detalhes sobre arquitetura (incluindo tamanho de modelo), hardware, computação de treinamento, construção de conjunto de dados e similares. A OpenAI justifica isso com o mercado competitivo.

O fato de a OpenAI não divulgar o número de parâmetros também pode ser interpretado como uma indicação de que a empresa não atribui mais importância decisiva ao número de parâmetros em seu PR, uma vez que isso por si só não tem significado para a qualidade do modelo, mas muitas pessoas pensam que sim.

No período que antecedeu as apresentações do GPT-4, alguns números de parâmetros absurdos foram mencionados nas mídias sociais para visualizar o desempenho do GPT-4 e alimentar o hype. Em todos os modelos anteriores, a OpenAI comunicou o tamanho do modelo como uma característica diferenciadora.

De acordo com a OpenAI, os primeiros clientes do GPT-4 incluem o aplicativo de aprendizado de idiomas Duolingo, o aplicativo de visão computacional Be My Eyes e o Morgan Stanley Wealth Management, que usa o GPT-4 para organizar sua base de conhecimento interna.

O governo islandês está usando GPT-4 para preservar sua própria língua. “Tivemos o treinamento inicial do GPT-4 feito por um bom tempo, mas levou muito tempo e muito trabalho para nos sentirmos prontos para lançá-lo”, disse Sam Altman, CEO da OpenAI.

Logo após a revelação do GPT-4 da OpenAI, a Microsoft também revela que o Bing Chat tem usado o GPT-4 desde o início. Portanto, qualquer pessoa que tenha interagido com “Sydney” nas últimas semanas provavelmente já tem alguma compreensão das capacidades do GPT-4. Notícia inspirada no The Decodr.