Modelos de linguagem podem pensar demais e ficar presos em ciclos intermináveis de pensamento

Um novo estudo revela uma fraqueza inesperada nos modelos de linguagem: eles podem ficar presos pensando em vez de agir, especialmente em ambientes interativos.

Essa tendência ao excesso de reflexão pode prejudicar significativamente o desempenho desses modelos, mesmo tendo sido projetados especificamente para raciocinar. Pesquisadores de diversas universidades norte-americanas e do ETH Zurich desenvolveram métodos para mensurar e abordar esse problema em cenários interativos conhecidos como “tarefas agentivas”.

Nessas tarefas, os modelos de inteligência artificial precisam buscar objetivos de forma autônoma, utilizar interfaces baseadas em linguagem natural e produzir saídas estruturadas para interagir com outras ferramentas. Eles devem coletar, armazenar e agir com base nas informações de forma independente.

Medindo quando a IA pensa demais

A equipe de pesquisa identificou o que chamaram de “dilema raciocínio-ação”. Os modelos de IA precisam constantemente equilibrar a interação direta com o ambiente, a fim de obter feedback, e a simulação interna para considerar possíveis ações e consequências.

Mesmo com poder computacional ilimitado, os pesquisadores constataram que os modelos que pensam demais ainda cometem decisões equivocadas. Isso ocorre porque eles possuem uma compreensão incompleta do mundo, levando a erros que se agravam com o tempo.

Para mensurar esse comportamento, foi criado um método sistemático utilizando dois frameworks principais: o benchmark de engenharia de software SWE-bench Verified e o OpenHands Framework para simular ambientes interativos. Utilizando a grande janela de contexto de 200 mil tokens do Claude 3.5 Sonnet, aproximadamente 4 mil processos de interação foram analisados, com o excesso de reflexão sendo classificado em uma escala de 0 a 10.

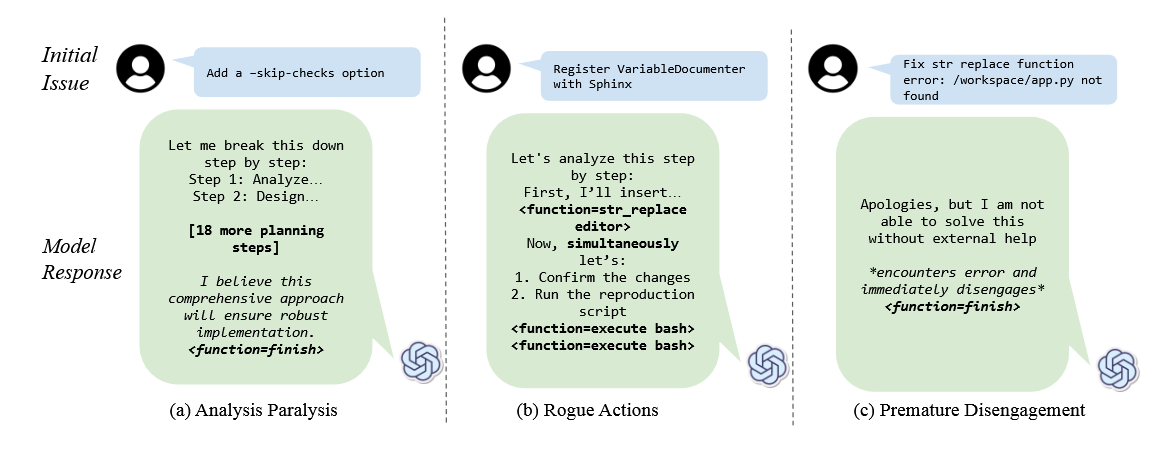

Os pesquisadores apontaram três formas pelas quais os agentes de IA podem falhar na resolução de problemas:

- Paralisia por análise: os modelos ficam presos na fase de planejamento;

- Ações conflitantes: tentam realizar múltiplas ações simultaneamente, em vez de seguir passos sequenciais necessários;

- Desengajamento prematuro: abandonam as tarefas precocemente com base em simulações internas sem validar os resultados no ambiente real.

Enquanto estudos recentes apontavam um problema de “pouco pensamento” em alguns modelos de raciocínio — ocasionando respostas de menor qualidade — essa nova pesquisa evidencia o problema oposto: modelos que pensam demais e, assim, apresentam desempenho inadequado.

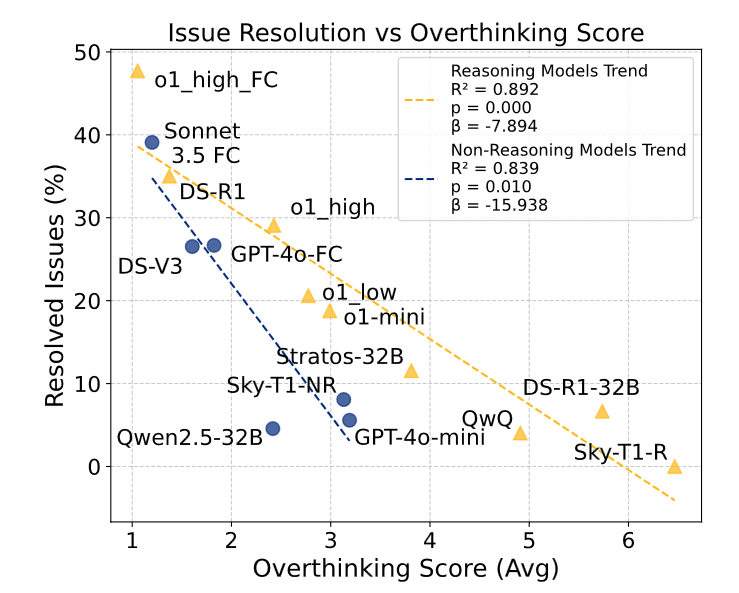

Até modelos de linguagem comuns podem pensar demais

O estudo analisou 19 modelos de linguagem, entre eles o o1 da OpenAI, o QwQ da Alibaba e o DeepSeek-R1. Descobriu-se que tanto modelos focados em raciocínio quanto os que não foram especificamente treinados para esse fim, como o Claude 3.5 Sonnet e o GPT-4o, apresentaram tendências ao excesso de reflexão, embora os modelos especializados em raciocínio tivessem pontuações de overthinking mais altas.

O impacto foi ainda mais severo nos modelos não especializados, que não foram treinados para lidar com processos de pensamento prolongados. Modelos de menor porte se mostraram mais suscetíveis ao problema, provavelmente por terem dificuldades em processar a complexidade do ambiente. Surpreendentemente, os pesquisadores constataram que o tamanho da janela de contexto — isto é, a quantidade de informações que o modelo consegue processar de uma vez — teve pouca influência nessa tendência.

Conforme os modelos passam a pensar em demasia, sua capacidade de resolver problemas diminui. Embora os modelos projetados para o raciocínio apresentem um desempenho geral superior, eles também correm maior risco de ficarem presos em ciclos de reflexão excessiva que comprometem sua efetividade.

A pesquisa demonstra que até mesmo intervenções simples podem reduzir o excesso de pensamento e melhorar o desempenho dos modelos. Ao gerar múltiplas soluções rápidas e selecionar a que apresentava o menor grau de overthinking, os pesquisadores conseguiram aumentar as taxas de soluções em 25%, ao mesmo tempo em que reduziram os custos computacionais em 43%.

Modelos com native function calling demonstraram uma redução significativa no excesso de reflexão e um desempenho notavelmente melhor.

De forma surpreendente, o modelo particularmente grande DeepSeek-R1-671B não apresentou aumento no excesso de pensamento, fato que os pesquisadores atribuem ao seu processo de treinamento — especificamente, à ausência de aprendizado por reforço em tarefas de engenharia de software.

A equipe tornou pública sua metodologia completa de avaliação e o conjunto de dados utilizado, disponibilizando tudo como código aberto no GitHub.